Un algorithme pourrait-il jouer un rôle de police prédictive, autrement dit anticiper de futurs crimes avant même qu’ils ne se produisent ? Si l’idée a déjà inspiré le cinéma de science-fiction dans la dystopie Minority Report, les expérimentations qui se rapprochent de ce fantasme suscitent quelques inquiétudes — à l’instar de ce programme récemment testé par la police australienne pour anticiper les crimes de préadolescents.

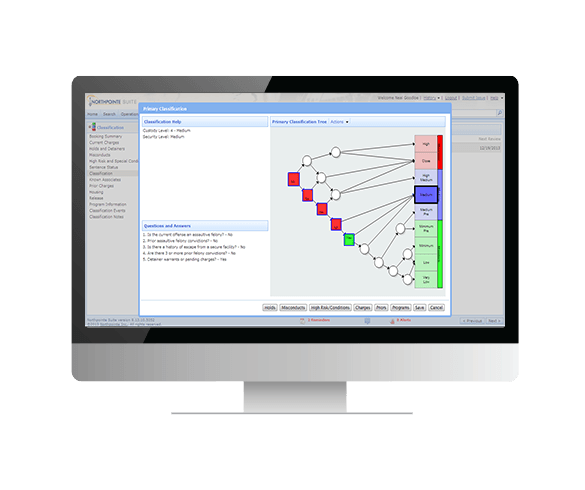

Aux États-Unis, l’un des outils les plus utilisés, et qui se rapproche de cette projection, porte le nom de Compas, pour « Correctional Offender Management Profiling Alternative Sanctions ». Il a été mis au point par Equivant — anciennement connu sous le nom de Northpointe.

Son rôle est d’établir un score entre 1 et 10 qui est ensuite pris en compte par le juge lors de sa décision : faut-il opter pour une détention provisoire ou envisager une libération conditionnelle, par exemple. Or, dans la logique de ce système d’évaluation, plus le chiffre est élevé, plus le risque de récidive est estimé important.

Pas plus précis qu’un humain

Censé aiguiller la décision du juge, cet algorithme est de plus en plus mobilisé comme une justification du jugement. Or, l’efficacité de cet outil est régulièrement remise en question : une étude publiée le 17 janvier 2018 par le Darmouth College remet en cause la validité de Compas. Julia Dressel et Hany Farid, professeurs d’informatique dans cette université, estiment même que l’algorithme ne donnerait pas une estimation plus précise que celle d’un humain.

« Les défenseurs de ces systèmes soutiennent que les données et l’apprentissage automatique avancé rendent ces analyses plus précises et moins biaisées que celles des humains. Cependant, nous montrons que le logiciel d’évaluation des risques Compas, largement utilisé, n’est pas plus précis ou juste que des prédictions faites par des personnes qui ont peu ou pas du tout d’expertise en matière de justice pénale », écrivent les deux professeurs.

Julia Dressel et Hany Farid ont confronté les résultats de Compas aux avis de 462 personnes, recrutées sur Internet et non formées au préalable. Les chercheurs leur ont présenté des profils de condamnés, accompagnés d’informations sur leur genre, leur âge et leurs antécédents judiciaires. Les répondants devaient estimer si chacun de ces condamnés était, selon eux, susceptible de commettre un autre crime d’ici deux ans.

Les humains ont vu juste dans 67 % des cas, contre 65,2 % pour Compas

En moyenne, les humains sollicités ont vu juste dans 67 % des cas, tandis que Compas affichait pour sa part un score de 65,2 %. Si les scores semblent proches, les chercheurs notent que l’algorithme prend sa décision sur la base de 127 critères, quand les humains n’ont eu qu’une poignée d’informations à leur disposition.

Equivant n’a pas tardé à réagir à la suite de la publication de l’étude, indiquant dans un communiqué que l’analyse des chercheurs était « erronée ». La société explique que les 127 critères mis en avant par les universitaires ne sont pas tous utilisés dans l’évaluation des risques par Compas : ils seraient en fait au nombre de six.

La pertinence de Compas a déjà été remise en question en 2016, par ProPublica. L’organisme à but non lucratif avait considéré que l’outil souffrait de biais racistes — la recherche se penche actuellement sur ce phénomène qui concerne certaines IA.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !