La course à l’intelligence artificielle passe aussi par une course au matériel. Justement, Meta, la maison mère de Facebook, a récemment accéléré le pas dans ce domaine. Il est rapporté que le géant des réseaux sociaux a augmenté ses achats de certaines puces spécialisées dans l’IA, pour les faire figurer dans ses futurs centres de traitement de données (data centers).

C’est le Wall Street Journal qui rapporte l’information, dans son édition du 10 septembre 2023. Sous l’impulsion du PDG de Meta, Mark Zuckerberg, le quotidien économique américain évoque le désir de l’entreprise américaine de se doter d’un nouveau grand modèle de langage, suffisamment performant pour pouvoir rivaliser avec GPT-4 d’OpenAI.

Les grands modèles de langage peuvent être vus comme le moteur et le carburant des agents conversationnels comme ChatGPT d’OpenAI. C’est sur eux que reposent les chatbots. Ces modèles ont été formés à partir de grandes quantités de données, et c’est sur ces vastes corpus que sont appliquées des règles de fonctionnement, en vue de satisfaire une tâche particulière.

GPT-4 est le tout dernier grand modèle de langage concocté par OpenAI pour faire vivre ChatGPT et il est considéré comme le mètre-étalon du secteur. Du moins, tant que ne sort pas GPT-5, dont l’arrivée apparaît inéluctable ; dans le cas contraire, la société fondée par Sam Altman, et qui est partenaire de Microsoft, prendrait le risque de se faire rattraper et doubler.

Concurrence accrue dans l’IA générative

Facebook a déjà conçu deux grands modèles de langage, avec la première génération de LLaMA (Large Language Model Meta AI) puis la seconde. Mais, en particulier pour LLaMA 2, l’annonce faite en juillet révélait aussi la nécessité pour Meta de passer par un partenaire, en l’occurrence Microsoft, pour faire tourner LLaMA sur son architecture cloud (Azure).

Il n’y a donc pas uniquement le souhait de se doter d’un modèle de langage aussi poussé que GPT-4. Le projet de Meta vise aussi à s’émanciper de Microsoft, en mobilisant sa propre infrastructure, plutôt que celle d’une autre entreprise pour entraîner et animer le système. La formation elle-même est évoquée pour le début de l’année prochaine.

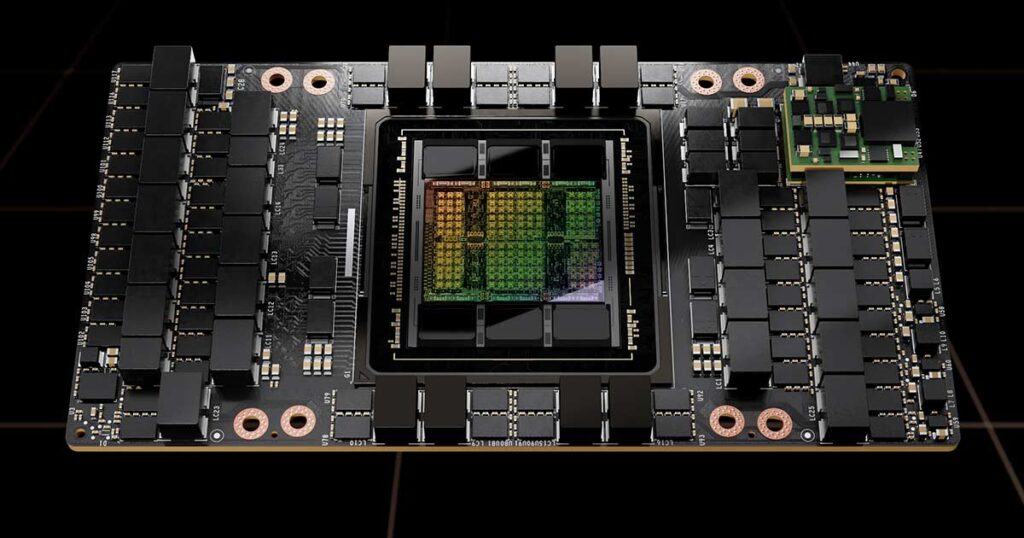

Dans ce cadre, Meta a accru son acquisition des puces H100 de Nvidia, qui sont adaptées aux traitements dans l’intelligence artificielle. Ces puces sont réputées. D’ailleurs, elles sont si performantes que les États-Unis ont interdit leur export en Chine, avec qui Washington est dans une guerre technologique, obligeant Nvidia à inventer une version amoindrie du modèle (H800).

Autre objectif de ce futur grand modèle de langage : fournir un système accessible gratuitement aux entreprises et open source. Objectif évident : il s’agirait d’inciter les sociétés à utiliser plutôt ce système pour créer des applications avec l’IA, plutôt qu’un autre. Au passage, Meta pourrait aussi en profiter pour améliorer cette IA via son utilisation par des tiers.

Dans cette course à l’intelligence artificielle, Meta a toutefois un problème : il n’est pas seul sur la piste. Même si l’entreprise cherche à accélérer, avec davantage de puces et, et à se débrouiller seul, en s’appuyant sur sa propre infrastructure, elle doit faire face aux efforts de la concurrence. Et, eux aussi entendent faire la course en tête.

Outre OpenAI, qui finira bien par sortir GPT-5, ce qui pourrait fixer un tout nouveau standard pour les chatbots, d’autres sociétés de premier plan affûtent leurs armes. On peut surtout à Google avec Bard et LaMDA. On pourrait aussi évoquer Microsoft avec Copilot, Amazon avec Bedrock ou encore Apple et son grand très mystérieux projet Ajax.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !