Les voitures autonomes ont connu mercredi leur premier accident mortel, avec une Tesla Model S en mode Autopilot qui est venu percuter par le pare brise la remorque d’un camion. L’affaire posera beaucoup de questions, à la fois juridiques, éthiques et technologiques. Tour d’horizon.

1. Qui sera tenu responsable de l’accident ?

C’est une question à plusieurs millions de dollars, qui sera probablement répondue dans les tribunaux, à moins que Tesla n’accepte un accord amiable. L’Autopilot n’est pas activé par défaut. Comme nous l’avions expliqué dans notre test de la Tesla Model S, le véhicule prévient que le pilotage automatique ne dispense pas le conducteur de tenir le volant, et envoie même régulièrement des rappels à la vigilance. C’est une assistance, pas une substitution à la conduite manuelle. Dès lors, en principe, Tesla devrait pouvoir s’exonérer de sa responsabilité, en rappelant, comme il le fait dans son communiqué, que c’est la victime elle-même qui a choisi de confier le volant à l’IA et d’assumer les risques d’une technologie encore en développement. Cynique, mais vrai.

La partie adverse (l’assurance du propriétaire), elle, tentera probablement de prétendre que Tesla avait une obligation de résultat, ou qu’il a manqué de diligence en permettant aux clients d’activer une fonctionnalité qui ne serait pas tout à fait mûre. Ce sera toutefois difficile à défendre.

2. Connaissait-on le risque d’un accident de ce type ?

Telsa explique que « ni l’Autopilot ni le conducteur n’ont remarqué le côté blanc de la remorque sur fond d’un ciel très lumineux ». Il savait déjà que ses capteurs n’étaient pas infaillibles, et notamment à l’égard des remorques des camions, dans certaines circonstances. En mai dernier, une Tesla Model S en mode « Summon » (qui exige que le conducteur appuie sur un bouton de son smartphone pour que la voiture continue à avancer) s’était déjà encastrée à l’arrière d’un camion, et le constructeur avait alors expliqué que « le véhicule peut ne pas détecter certains obstacles, notamment ceux qui sont très fins (par ex. des vélos), plus bas que le tableau de bord, ou qui pendent du toit ».

Tesla avait donc connaissance de risques de collisions dues à un manque d’omniscience de ses capteurs, et c’est aussi pour cela qu’il insiste autant pour que le conducteur reste prêt à tourner le volant ou à freiner à tout moment, si le mode Autopilot ne perçoit pas un danger. Néanmoins, le constructeur assure que l’accident était lié à des « circonstances extrêmement rares ».

3. L’accident remet-il en question la sécurité des voitures autonomes ?

Non. Jusqu’à aujourd’hui, aucune voiture conduite par un ordinateur n’avait connu d’accident grave. La sécurité des voitures autonomes, actuelle ou future, est jugée meilleure que les voitures conduites par des humains, au point que l’ONU anticipe déjà une future interdiction faite aux humains de conduire. Statistiquement, Tesla a déjà connu moins d’accident en mode Autopilot qu’il n’y a d’accidents avec les voitures en mode manuel.

Le constructeur indique ainsi que son Autopilot aurait conduit sur environ 210 millions de kilomètres, alors qu’il se produit aux USA un mort tous les 151 millions de kilomètres environ. Sur l’ensemble du globe c’est un mort tous les 95 millions de km environ, mais la comparaison n’a pas grand sens puisqu’elle inclut alors les très nombreux pays aux infrastructures et aux voitures moins fiables que ceux où roulent les Tesla.

Mais surtout, si l’enquête démontre un problème logiciel, Tesla pourra facilement mettre à jour ses algorithmes, ou même rappeler ses voitures pour remplacer un capteur physique. Toutes les voitures deviendront alors plus sûres du jour au lendemain. Avec les voitures manuelles, il est certes possible d’améliorer la sécurité matérielle (ceintures, air bag, suspensions, freins…), mais cela prend des années voire des décennies avant de changer les mentalités des conducteurs, et leur manière de conduire. Avec les robots, une simple mise à jour suffira.

La victime elle-même, Joshua Brown, avait publié quelques mois plus tôt une vidéo qui montrait que sa voiture avait parfaitement réagi lorsqu’un camion avait fait une manœuvre dangereuse :

4. Sans Autopilot, l’accident mortel aurait-il été évité ?

Là aussi, c’est une question à laquelle il est très difficile de répondre. De façon peut-être un peu trop définitive, Tesla affirme que si le conducteur n’a pas vu la remorque, c’est parce qu’elle était blanche sur un ciel lui-même très lumineux. Il ne serait donc pas endormi, ou ne faisait pas autre chose que de regarder la route, mais aurait simplement vu la même chose que ce que la voiture voyait, c’est-à-dire rien de particulier. Dans ces conditions, avec ou sans Autopilot, l’accident aurait été le même, avec la même conséquence fatale.

Mais en réalité, nous n’en savons rien, et l’on ne voit pas comment cette question pourrait avoir une réponse définitive. Peut-être que le conducteur, en mode manuel, aurait eu une vigilance accrue, aurait roulé moins vite, et se serait méfié de l’éblouissement. Peut-être pas.

5. Et si la Tesla Model S avait dû choisir entre deux morts ?

Hasard de calendrier, l’accident nous renvoie à la question que nous posions la semaine dernière, sur les choix éthiques que les propriétaires et/ou les constructeurs de voitures autonomes devront faire, qui s’ont d’une énorme complexité morale. Imaginons que pour éviter la remorque du camion qui reculait perpendiculairement à la route, aperçue au dernier moment, la voiture ait dû faire un choix entre poursuivre sa route au risque de tuer son passager, ou de se décaler sur la gauche au risque de renverser une moto qui le doublait au même moment. Quelle décision prendre ?

Et la décision devrait-elle être la même si à l’intérieur de la Tesla il n’y avait pas qu’une seule personne, mais quatre ? Ou si le conducteur est une femme enceinte ?

6. Le mode Autopilot des Tesla pourrait-il être suspendu ?

Pour l’instant, il n’en est pas question. Telsa explique que l’enquête ouverte par la National Highway Traffic Safety Administration (NHTSA) vise à vérifier si le mode Autopilot s’est comporté « conformément aux attentes », et aucune mesure conservatoire n’a été exigée. Il faudra donc déterminer quelles étaient ces attentes (était-il censé voir cette remorque ?), et si le logiciel a de lui-même réalisé une manœuvre dangereuse que le propriétaire ne pouvait ni anticiper, ni éviter. C’est en fonction du résultat de cette enquête que les autorités américaines, et probablement aussi les autorités européennes, décideront du sort du mode Autopilot.

Techniquement, Tesla pourrait le désactiver en imposant une mise à jour à distance.

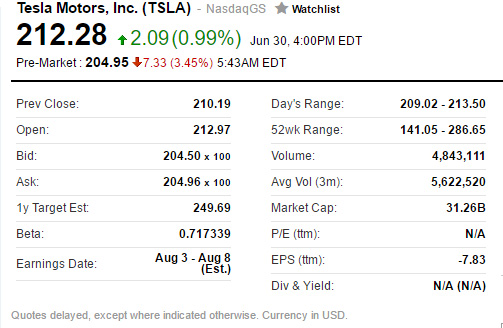

Les investisseurs ne semblent en tout cas pas trop inquiets, ni même pour l’image de Tesla, puisque l’action ne perdait ce vendredi matin que 3,45 % en pre-market, ce qui ne montre pas le signe d’une panique :

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !