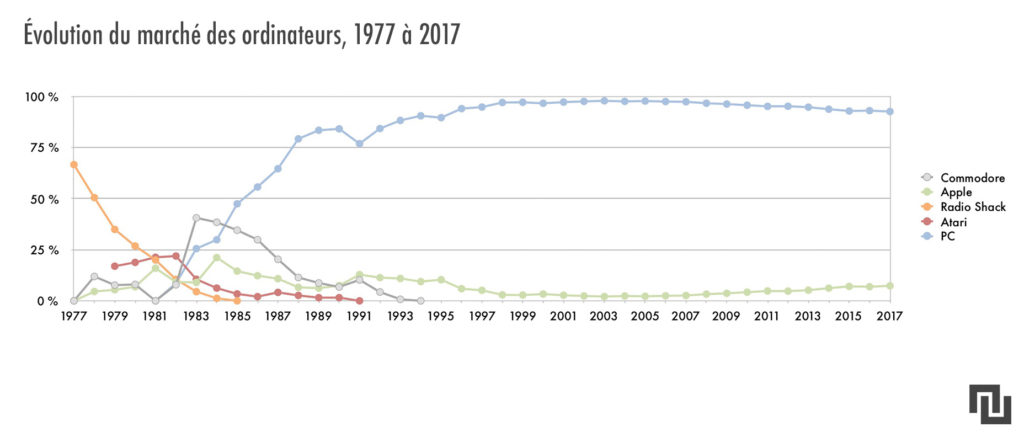

L’opposition entre PC et Mac peut paraître un peu étrange. Déjà, elle semble mettre sur un pied d’égalité la quasi-totalité des fabricants d’ordinateurs personnels d’une part, et d’autre part une entreprise qui en quarante ans d’existence n’a presque jamais capturé plus de 15 % de parts de marché (et autour de 2 %-3 % pour l’essentiel des années 2000). On retrouve néanmoins un clivage historique lié au microprocesseur ; une variable très importante dans la tech à une époque, mais beaucoup moins aujourd’hui.

Comment est née la distinction ?

Il faut se plonger en 1981. L’industrie de la tech, en plein éveil, ne ressemble pas du tout à celle dont on a aujourd’hui coutume. Pour simplifier, le vénérable géant IBM — élitiste, sérieux et fermé — décide de lancer un ordinateur personnel pour contrer la percée de la startup Apple — jeune, rebelle et open. Oui, vous avez bien lu. On vous avait dit que c’était une époque très différente.

Apple : jeune, rebelle et open

L’IBM PC, c’est son nom, est lancé en 1981 et devient un succès instantané. L’influence de Big Blue est telle que nombre de petits constructeurs, voyant que le PC est ouvert niveau software, copient l’IBM PC pour en faire des clones appelés « PC-compatibles » : peut-être pas identiques à l’original, mais pouvant profiter de tous les logiciels créés pour IBM et notamment du système d’exploitation MS-DOS de Microsoft. Résultat, ce qui devait arriver arriva : le PC d’IBM finit noyé dans la concurrence, et bientôt Big Blue enregistre une hémorragie de plusieurs milliards de dollars.

La chute d’IBM fait les affaires de Microsoft, qui s’impose sur tous les PC du monde. Après l’effacement dans les années 90 de la dernière autre architecture en vigueur, celle du Commodore Amiga, l’industrie de l’ordinateur personnel se retrouve divisée en deux : le PC gouverné par Microsoft et Intel (« Wintel » pour les intimes), et le Mac d’Apple seul contre le monde entier.

C’est quoi la différence d’architecture ?

Ces histoires d’architecture sont liées à la manière dont le microprocesseur (ou CPU) fonctionne. Les langages de programmation usuels, que ce soit Java ou C, ne sont pas directement lisibles par le CPU. Celui-ci ne comprend que des actions très basiques, comme « lire », « écrire », « additionner », etc. qui permettent d’exécuter le programme. Imaginez que chacune de ces instructions soit une brique de Lego différente, et que le programme soit une série de plans permettant de construire une maison ou un vaisseau spatial en Lego.

Or, tous les constructeurs de microprocesseurs ne vont pas donner les mêmes jeux d’instructions à leurs CPU, et c’est un problème. Admettons que vous êtes chez Microsoft, et que vous avez dessiné les plans d’un Windows pour qu’un CPU Intel puisse en construire un avec ses briques de Lego certifiées Intel. Si vous essayez de donner les plans de ce Windows au CPU PowerPC d’un vieux Macintosh, celle-ci va y rencontrer des briques dont elle n’a jamais entendu parler, et ne va jamais pouvoir faire tourner le Windows.

C’est pareil si vous essayez de donner les plans d’un OS X au CPU Intel d’un PC : il ne va pas trouver les briques indiquées dans la notice, et ne pourra rien faire. La différence d’architecture va au-delà des jeux d’instructions. On peut citer la taille du mot, par exemple de 32 bits ou 64 bits, qui correspond à la taille des données traitées à chaque cycle. Retenez au moins que le gros facteur de variabilité vient du fabricant du CPU et du modèle utilisé.

Pour porter un système d’exploitation (OS) d’une architecture à l’autre, faudrait-il le réécrire entièrement en remplaçant méthodiquement chaque instruction typique du x86 par une instruction PowerPC, ou inversement ? Cela aurait été le cas à la fin des années 70 et au début des années 80, quand les OS étaient encore largement écrits en assembleur (un équivalent lisible par les humains du très rustre langage machine). Mais au lieu d’écrire bêtement à la main quelle brique de Lego poser à quelle étape de la construction, ne serait-il pas plus efficace de dessiner d’un coup les plans de la maison au crayon, et de faire un programme pour déterminer automatiquement quelles briques sont nécessaires ?

C’est ainsi que l’ampleur de la tâche a été grandement diminuée par le langage C. Un des piliers de l’informatique moderne, le C a pratiquement été inventé pour écrire les premiers OS de la famille Unix à partir de 1972. La première branche majeure de cette famille, BSD, est ainsi écrite dans ce langage relativement lisible et intellectuellement esthétique, avec seulement de petits morceaux écrits en assembleur pour faire la jonction avec le CPU. Mac OS Classic et Windows emboîtent ensuite le pas.

Les tentatives de passage à Intel

Le Macintosh originel de 1984, avec son système d’exploitation graphique et son processeur Motorola 68000, était très différent des PC-compatibles dotés de puces Intel et d’un système d’exploitation MS-DOS. L’architecture Intel dérivée de la puce 8086 — dite x86 — souffrait de quelques complications d’un point de vue informatique, notamment lorsqu’ils s’agissait de rechercher des informations dans la mémoire (les fameux « pointeurs »). Des propositions de passage du Macintosh à Intel ont été entendues juste après le licenciement de Steve Jobs en 1985, sans suite.

Au début des années 90 se popularisent les PC sous Windows 3.1, la première version répandue du système d’exploitation de Microsoft. Cela effraie la firme Novell, dont l’OS réseau NetWare pourrait se trouver concurrencé par le futur Windows NT. Novell a besoin d’un autre OS pour contre-attaquer et se tourne vers Apple. Ce dernier commence aussi à souffrir de la vague Windows. Son CEO, John Sculley, veut réorienter l’entreprise vers le software.

À la Saint-Valentin 1992, Novell et Apple s’unissent dans un projet secret, nom de code « Star Trek » et dont le slogan est « to boldly go where no Mac has gone before ». Le but est de créer un Mac OS sous architecture Intel x86, capable de faire tourner des applications MS-DOS et peut-être même Windows (selon les rumeurs). Le tout se passe avec la bénédiction d’Intel, qui lui aussi s’inquiète du rouleau compresseur Microsoft. Un prototype de Star Trek est livré pour Halloween 1992, mais Sculley se fait éjecter de son poste quelques mois plus tard à la suite du fiasco palmtop Newton. Il est remplacé par Michael Spindler, qui abandonne Star Trek pour passer à l’architecture PowerPC.

Les PowerPC sont une nouvelle gamme de processeurs d’IBM, réalisés en partenariat avec Motorola et qu’Apple introduit dans ses Macintosh. Ainsi s’établit l’alliance AIM (« Apple-IBM-Motorola »). Grâce à leur architecture RISC (reduced instruction set computer), les PowerPC sont plus rapides que les Intel à cadence équivalente, mais ont un rapport qualité-prix médiocre et chauffent beaucoup.

Dans les années 2000, la firme de Cupertino se lasse de ses PowerPC qui subissent de plus des retards de livraison. Les Intel sont au contraire plus standards, économiques, faciles à trouver et, dorénavant, rapides. Autre enjeu majeur pour Apple, la plupart des contributions open source à Unix se trouvent être taillées pour du x86. La solution semble être, de nouveau, de passer à Intel.

Un des facteurs facilitant la future transition à Intel vient de la startup NeXT de Steve Jobs, qui a selon la blague « racheté Apple avec l’argent d’Apple » en 1996. Si les machines de cette dernière étaient sous Motorola, son système d’exploitation NeXTSTEP — ancêtre direct d’OS X — faisait partie de la famille Unix et comportait des versions pour architecture x86.

Le passage à Intel s’effectue en 2006

Le passage à Intel est annoncé à la WWDC de juin 2005 et la première mouture d’OS X supportant la transition, OS X 10.4.4 Tiger, est lancée en janvier 2006 avec la sortie du MacBook Pro et de l’iMac Core Duo. Les rumeurs disent que dans les premières phases secrètes de l’opération, des ingénieurs d’Apple étaient envoyés acheter discrètement des processeurs Intel à titre personnel (les notes de frais étant évidemment remboursées) ; une livraison massive de x86 à l’adresse 1, Infinite Loop aurait en effet laissé beaucoup de monde pantois.

L’architecture du Mac étant désormais la même que celle de la plupart des PC Windows, le mois d’avril voit la sortie de Boot Camp sur les Mac x86 pour permettre le dual boot avec Windows XP. Pendant la période de transition, l’émulateur Rosetta permet de faire tourner la plupart des applications PowerPC sur Intel (la suite créative d’Adobe faisant partie des malheureuses exceptions, jusqu’à ce qu’Adobe sorte une version x86 en 2007). À partir de 2009, OS X 10.6 Snow Leopard ne supporte plus les Mac PowerPC. Le hardware PowerPC est officiellement déclaré obsolète en août 2013.

Que reste-t-il de ces différences matérielles ?

Aujourd’hui, plus grand chose. PC et Mac sont assemblés avec les mêmes fournisseurs, et en ce qui concerne les entrailles de la bête, il n’est pas faux de dire que le Mac d’aujourd’hui est un PC. De fait, une machine Intel 64-bits est presque plus proche d’un Mac (également d’architecture Intel) que d’un autre PC d’architecture AMD, ou même d’un autre Intel 32-bits.

De nos jours, les principales différences sont ne concernent pas l’architecture mais plutôt certains standards. Alors que l’influence de Microsoft sur le PC fut telle qu’une touche Windows a été rajoutée par défaut sur tous les claviers, le Mac garde un clavier distinct où la touche Cmd joue par défaut le rôle du Ctrl sous PC. Il ne dispose pas non plus de touche « clic droit », le support des souris à plusieurs boutons ne datant que des années 2000.

Un standard important diffusé par le Macintosh sur le PC est l’USB. Au début des années 90, les ordinateurs personnels de tout poil avaient un certain nombre de standards épars pour les ports externes. Créé à partir de 1994 par un consortium de sept entreprises, dont Intel, IBM ou Microsoft, l’USB s’est répandu de manière très timide et sans rallier à sa cause beaucoup de fabricants de périphériques. Quand l’iMac de 1998 est arrivé en disposant exclusivement de ports USB, le succès de ce modèle a été suivi par la création de claviers et de souris USB utilisables tant sur Mac que sur les autres PC (sauf si les utilisateurs PC veulent une souris avec plus d’un seul bouton, on est bien d’accord). De nouveaux PC dits legacy-free ont emboîté le pas, jusqu’à ce que l’USB se généralise.

Mais alors, pourquoi oppose-t-on autant le Mac et le PC ?

Pour des raisons politiques, culturelles et surtout, pour la comm’. Dans les années 90 où Apple était très affaibli, l’expression « Macintosh PC » n’était pas du tout choquante car PC s’était mis à désigner par abus de langage tout ordinateur personnel, compatible ou non avec la norme instaurée par IBM. De nos jours, personne ne conteste dans l’industrie que le terme « marché du PC » inclut aussi les Mac.

Après le retour de Steve Jobs en 1997, Cupertino a relancé sa croisade contre Microsoft à grands renforts de publicité. L’appellation « PC » est devenue une autre manière de désigner le système d’exploitation Windows, tant la firme de Redmond régnait comme dénominateur commun des fabricants d’ordinateurs. Aujourd’hui encore, quand un logiciel est marketé pour « Mac et PC », il est rare qu’il dispose d’une version Linux. De même pour les « jeux PC », qui ne s’accommodent souvent que d’un Windows.

La transition à Intel a certes permis au Mac de devenir compatible avec Windows en 2006, peu de temps avant le lancement de la série de publicités « Get a Mac » la même année. Au-delà des raisons commerciales, c’est une manière de poser le Mac comme supérieur au PC, car supportant les deux systèmes d’exploitation. La compatibilité Linux était elle déjà assurable sur PowerPC dès 1996 grâce au noyau MkLinux — le premier projet open source d’Apple, en partenariat avec le centre de recherche de l’Open Software Foundation à Grenoble — même si le passage à x86 a grandement facilité les choses. On nous murmure même que certains ingénieurs Apple, chargés des serveurs Linux de Cupertino, auraient remplacé les macOS de leurs machines par des Ubuntu…

Maintenant que le Mac s’est quelque peu répandu, que Microsoft fait son propre hardware et que chaque année qui vient s’annonce comme « l’année du Linux sur desktop », opposer Mac et PC est surtout devenu une manière de demander si on veut acheter du Apple ou pas. La réponse est alors une question de goûts et de besoins, bien loin d’histoires de petites briques à l’intérieur des microprocesseurs.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !