Présenté en grandes pompes, le mode Cinématique est l’ajout grand public le plus visible de la caméra des iPhone 13 (notre test) et iPhone 13 Pro (notre test) — le premier appareil peut s’en servir avec son capteur principal, quand le second peut aussi l’utiliser avec le téléobjectif de 77mm (zoom x3). Pour le dire vite, il s’agit d’un mode de l’application caméra qui promet de rendre une prise « cinématographique ». Derrière ce terme se cache surtout une capacité à faire une mise au point dynamique sur différents plans, et donc flouter ce qui n’est pas le sujet de la séquence à la manière d’une caméra professionnelle.

Mais comment fonctionne le mode Cinématique ? Nous avons pu le tester de manière extensive sur les iPhone 13 et les iPhone 13 Pro et nous nous sommes entretenus avec Vitor Silva et Johnnie Manzari, respectivement Product Manager senior pour l’iPhone et designer dans l’équipe Interface, pour en comprendre les rouages.

Mode Cinématique des iPhone 13 et 13 Pro : comment ça marche ?

« C’est un mode qui symbolise bien notre manière de travailler ensemble à Apple, lance Vitor Silva, car le mode Cinématique est une combinaison de matériel, de logiciel, d’interface, de l’équipe qui a travaillé sur le processeur A15, de l’équipe chargée du machine learning… » : en bref, un vrai projet global centré autour des capacités de l’iPhone. Et on comprend tout de suite à l’usage ce qu’explique Vitor Silva.

Calculer la profondeur de champ

Le mode Cinématique est avant tout un processus qui se passe dans l’iPhone. L’application Caméra va procéder à une mesure stéréoscopique en utilisant la différence de focale entre deux objectifs (la caméra TrueDepth à l’avant calcule la profondeur différemment). Pour faire simple, c’est comme si, en « voyant » loin et près en même temps, l’iPhone était capable de mesurer la distance entre deux points, et donc la profondeur qui les sépare. Une notion de calcul en plusieurs dimensions existe, car cette mesure va en fait créer une « carte de disparité » (depth map), qui va donner une information brute au smartphone : quels éléments du plan sont à quelle distance de l’objectif qui filme. Le tout, en temps réel et plusieurs fois par seconde pour ajuster en permanence ces informations.

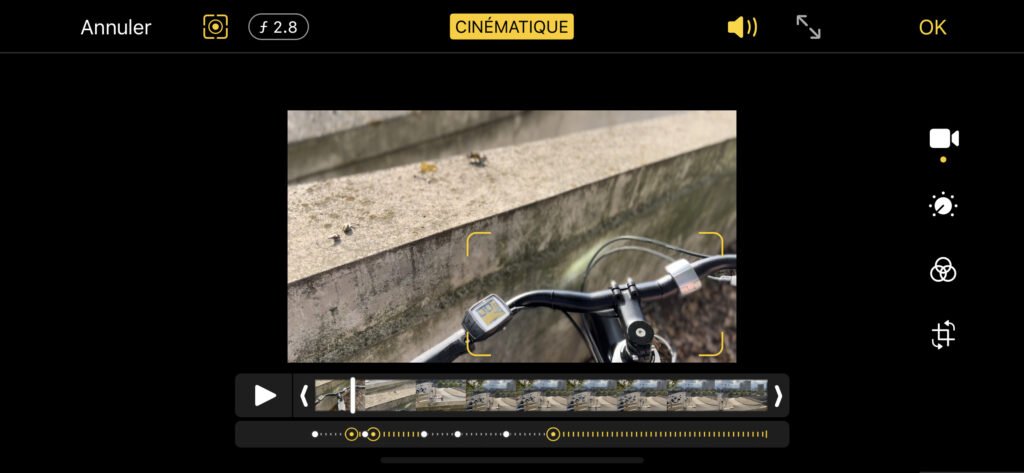

Ce processus technique n’est que la première partie de notre affaire, car l’iPhone n’a pour l’instant qu’une capacité : voir en profondeur et identifier plusieurs plans. On comprend très bien comment cela fonctionne dans l’exemple ci-dessous :

Dans cet exemple, l’iPhone 13 Pro a repéré 3 plans, à 3 distances différentes : celui du vélo, celui du premier muret et celui du second muret. C’est bien d’avoir une notion de distance, mais ça ne fait pas tout. C’est là qu’entre en jeu le machine learning.

Comprendre ce qui se passe à l’écran

Pour faire en sorte que le mode Cinématique soit utilisable sans la moindre connaissance en réalisation audiovisuelle, Apple s’est mis au défi de proposer un mode « automatique » convenable. En gros, c’est lui qui doit, tout seul, s’assurer de faire la mise au point sur la bonne partie du cadre. Si un personnage entre dans le champ, il favorisera cette entrée. Si des plans changent rapidement (comme sur notre exemple ci-dessus), il fera une mise au point successive sur les différents plans. Si une personne parle, le focus sera fait sur elle.

Comment décide-t-il ? Vitor Silva nous affirme qu’Apple a créé un processus d’entraînement d’un algorithme qui a été nourri par « des centaines de films », ajusté par des « discussions avec des réalisateurs ». L’objectif : « essayer de comprendre ce qui fait la cinématographie d’une scène ». Comme un apprenti-réalisateur, l’algorithme a donc été entraîné à repérer une différence de plan, une transition, une entrée dans le champ, un champ contre-champ dans un dialogue, etc. Les résultats de cet apprentissage ont été intégrés à l’application Caméra et le processeur Apple A15 Bionic se charge, en temps réel, de les appliquer à ce qu’il voit. Bien entendu, l’humanisation est ici faite à titre pédagogique : tout n’est que nombres, vecteurs et formes pour de la vision par ordinateur.

Travailler l’esthétique d’un plan

Une fois que l’on a la profondeur et une certaine idée de la composition d’un plan au cinéma, il faut appliquer un traitement à l’image. C’est ici qu’entre en jeu le neural engine du processeur A15 Bionic : il doit interpréter la complexité du plan en cours de tournage et appliquer un effet de bokeh réaliste. Cet effet « de flou » est tout un art : il ne suffit pas de flouter grossièrement une partie de la scène, mais de faire en sorte de copier le fonctionnement d’un vrai objectif mécanique (on comprend probablement pourquoi le mode est limité à du 1080p à 30 images par seconde, toute configuration supérieure aurait été trop demandeuse en ressource) .

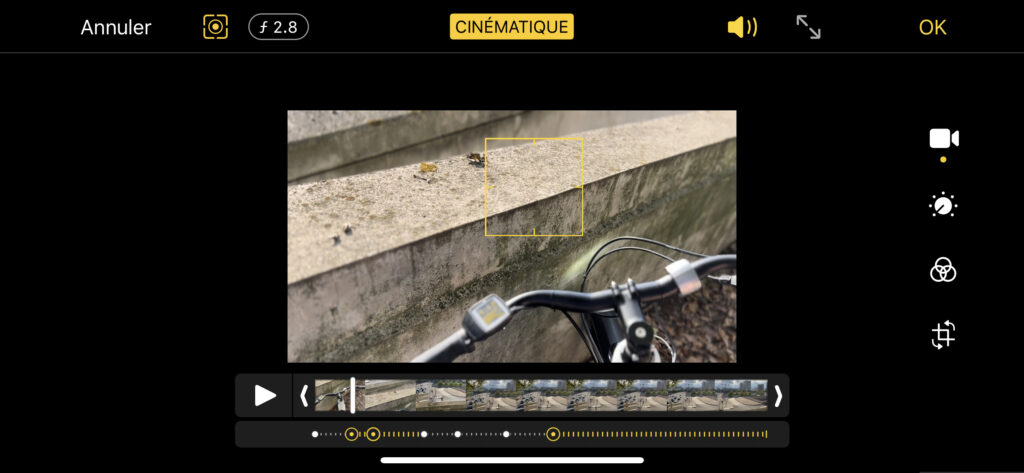

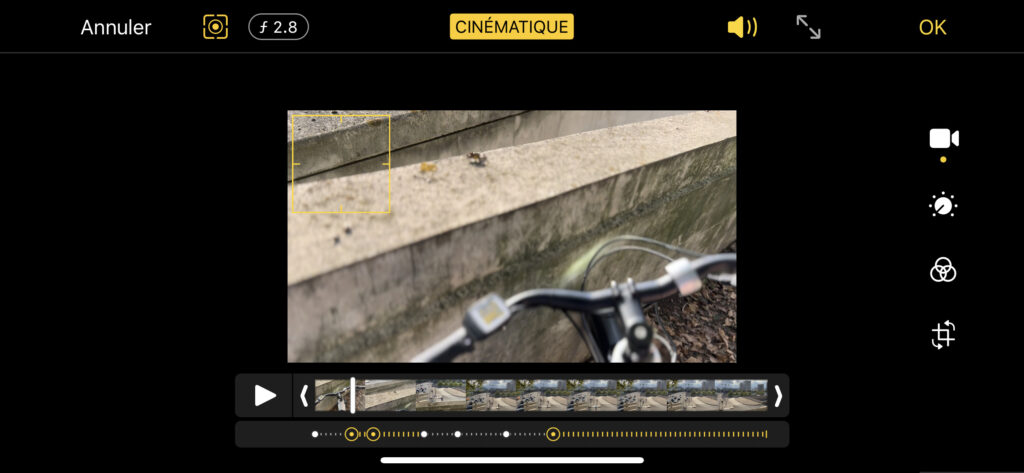

Dans la capture ci-dessous, on voit comment le mode Cinématique a compris que la partie de sol entre la manette de vitesse et le guidon appartenait non pas au vélo, mais au plan le plus éloigné.

Dans la capture ci-dessous, on voit à l’inverse qu’en faisant la mise au point sur le bateau qui arrive sur la Seine, les plantes au premier plan ne sont pas bien floutées du tout. Ici, tout le processus du mode Cinématique s’est bien passé jusqu’à l’application des éléments de « post-production », signe qu’il s’agit d’une des tâches les plus difficiles. On peut se rappeler, à titre de comparaison, à quel point le mode Portrait de l’iPhone a mis du temps avant d’être vraiment honnête. C’est ici la même tâche que se donne Apple, mais avec des humains, des animaux, des objets, des végétaux, etc., le tout en temps réel et sur des images animées. On comprend qu’il y ait quelques ratés.

L’interface et la postproduction du mode Cinématique

Apple souhaite que son mode Cinématique soit utilisé et pour cela, l’entreprise a cherché à concevoir une interface simple d’accès pour un procédé complexe — on l’a vu. Hors de question d’avoir à ajuster le point comme des professionnels du cinéma, qui ont été consultés pour l’élaboration de la fonction, comme l’affirme Johnnie Manzari. « Nous avons souhaité offrir la possibilité aux utilisateurs et utilisatrices du mode Cinématique la possibilité de tester de nouvelles choses avec la caméra de l’iPhone », poursuit Manzari. Et c’est précisément pour cela que tout le travail effectué en direct est aussi accessible en post-production, directement dans l’application Photos de l’iPhone.

Chaque tape sur l’écran du smartphone va ajouter un « point » dans la séquence, qui correspond à un changement de mise au point. L’utilisateur peut aussi, très simplement, sélectionner un personnage ou un objet à l’écran pour garder la mise au-dessus, qu’importe sa position dans le champ. L’accessibilité de la fonctionnalité est exemplaire.

Le mode Cinématique, un outil grand public

Qu’on se le dise : le mode Cinématique va sans nul doute évoluer si Apple entend en faire un vrai hit. Aujourd’hui, nos tests montrent qu’il s’en sort magistralement avec des humains (l’expérience mode Portrait ?) mais beaucoup moins bien avec des formes complexes (grillages, plantes, etc.). Un réalisateur professionnel, s’il utilise l’iPhone, préfèrera très probablement le mode ProRes et un contrôle des objectifs dans une application de caméra autorisant un mode Manuel — voire, une visualisation en même temps de plusieurs objectifs d’un iPhone Pro. Filmic DoubleTake en est par exemple capable.

Mais le fait de rendre ce mode disponible également sur les iPhone 13 montre aussi l’intention d’Apple : le mode Cinématique est un outil grand public, principalement pour s’amuser à créer différemment. Il pourra peut-être faire naître des vocations, avant de s’effacer pour des logiciels offrant un contrôle plus précis.

Nos exemples du mode Cinématique sur l’iPhone

iPhone 13 Pro

iPhone 13

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !