La reconnaissance faciale est un domaine qui n’a rien de nouveau, mais où on attend encore d’avoir entre les mains une implémentation convaincante de la chose pour la sécurité des appareils mobiles. Quoi qu’il faille attendre de manipuler l’iPhone X pour se prononcer, le système Face ID d’Apple aurait de quoi être à la hauteur de nos exigences.

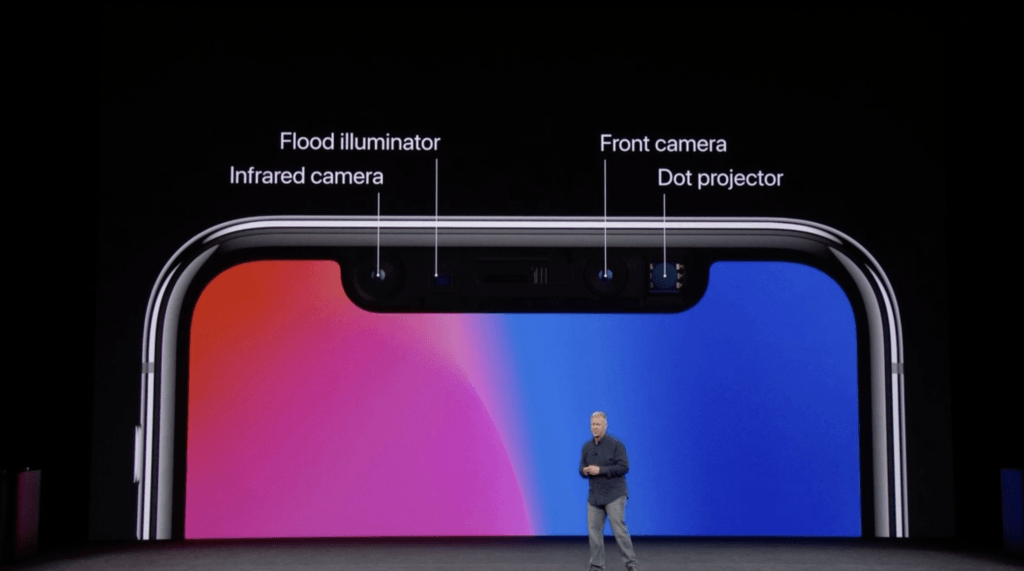

TrueDepth est le nom choisi par les équipes marketing d’Apple pour désigner l’ensemble de capteurs présents dans la fameuse « saillie » en haut de l’écran de l’iPhone X. Aux côtés des composants traditionnels tels le capteur de proximité — pour désactiver l’écran quand on tient le téléphone à l’oreille –, le haut-parleur, le micro et la caméra frontale, de nouveaux éléments dédiés à Face ID se nichent. Le flood illuminator est par exemple un flash à lumière infrarouge permettant à la caméra infrarouge de prendre une image de vous, y compris dans le noir.

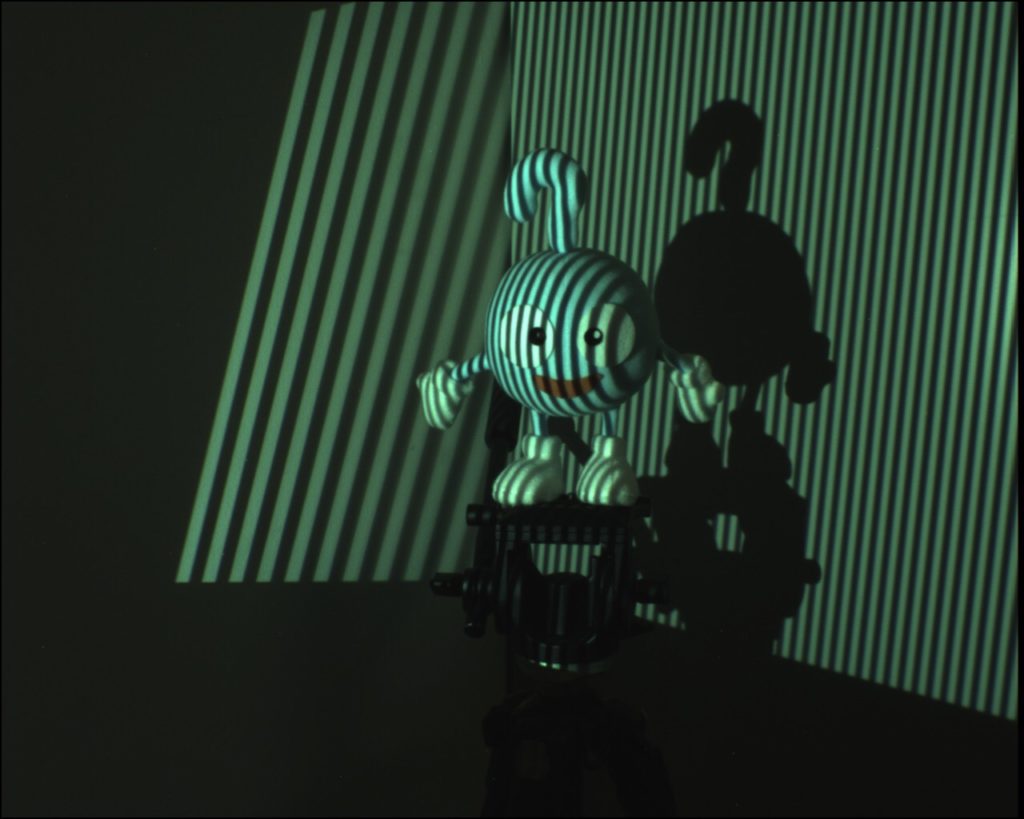

Les fails récoltés par la reconnaissance faciale du Samsung Galaxy S8, auquel il suffit de montrer votre selfie pour obtenir l’accès aux données, mettent en avant un enjeu finalement assez simple : déterminer si votre visage est en deux ou trois dimensions. C’est le rôle du « projecteur de points », une forme de scanner à lumière structurée. La technologie, connue depuis belle lurette, consiste à envoyer des motifs lumineux — points, bandes, échiquiers ou autres — sur un objet, puis à analyser la manière dont ils se retrouvent déformés pour en tirer une carte tridimensionnelle.

Cette méthode est déjà utilisée par le périphérique Kinect de la Xbox de Microsoft pour analyser les mouvements des joueurs. Les 30 000 petits faisceaux de lumière de l’iPhone X servent également à cet effet. Rappelons que la carte du visage est stockée exclusivement en local dans le Secure Enclave de l’iPhone, et n’est transférée sur aucune base de données ou serveur.

Les informations récoltées sont traitées dans le processeur, dont la nouvelle mouture Apple porte le doux nom d’A11 Bionic. On a par ailleurs vérifié sur le Wiktionnaire que « bionic » se dit « d’un organisme biologique ayant été amélioré avec des pièces électroniques ou mécaniques », et qu’on ne voit donc pas le rapport avec une CPU en silicium — mais les voies de la pomme sont impénétrables. Outre sa vitesse, la nouveauté de l’A11 Bionic par rapport à son prédécesseur A10 Fusion est l’inclusion d’un « moteur neural » : un processeur, en l’occurrence un dual core capable d’effectuer 600 milliards d’opérations par seconde, optimisé pour faire tourner un réseau de neurones artificiel.

Le moteur neural, un processeur optimisé pour faire tourner un réseau de neurones

Toute reconnaissance d’image (ou plus largement, toute analyse automatique et un peu sophistiquée d’un grand nombre de données) passe presque par définition par de l’intelligence artificielle ou de l’algorythmie complexe, généralement un réseau neuronal. Ce dernier compare la carte du visage transmise par les capteurs au modèle préenregistré — et contrairement à Touch ID qui permet plusieurs empreintes digitales, Face ID n’accepte qu’un seul visage. L’intérêt du réseau de neurones est qu’il peut apprendre à la volée, et ainsi s’entraîner à vous reconnaître à chaque fois que vous regardez votre iPhone, sans être perturbé par un changement d’apparence (nouvelle coupe de cheveux, lunettes, vieillissement…).

Le réseau de neurones analyse par ailleurs où se concentre votre attention. En gros, si vous ne regardez pas votre iPhone « dans les yeux », il ne se déverrouillera pas. On ne devrait ainsi pas pouvoir entrer dans l’appareil en le mettant devant votre visage pendant que vous dormez. Idem, si vous êtes en garde à vue, les forces de l’ordre auront du mal à ouvrir le téléphone en le brandissant devant vous — le smartphone demandera le code après quelques tentatives (4 sur Touch ID) ou après utilisation du verrouillage d’urgence. C’est en scrutant ainsi vos expressions faciales que l’appareil peut également faire fonctionner les Animojis, ces émojis qui adoptent vos moues et le mouvement de vos lèvres.

Bien que Phil Schiller n’ait pas donné de détails à ce sujet, on suppose que la caméra infrarouge intégrée dans TrueDepth sert également à faire la différence entre un vrai visage d’humain à sang chaud et un masque hollywoodien froid et synthétique. La firme de Cupertino affirme avoir testé le système avec de tels masques et assure que Face ID ne sera pas berné.

Une personne tierce aurait par ailleurs une chance sur un million de pouvoir usurper votre identité devant Face ID, contre une chance sur 50 000 pour Touch ID. Ce résultat, impressionnant à première vue, est à tempérer fortement par le fait que les risques augmentent considérablement pour Face ID avec des membres proches de la famille — on n’ose imaginer le cas des vrais jumeaux.

Rappelons enfin que l’identification biométrique n’est pas un stade que l’on pourrait qualifier de sécurité avancée : un mot de passe, pour qu’il soit fort, doit pouvoir être changé (difficile avec votre pouce ou votre tête). Elle reste cependant un moindre mal et un bon compromis entre sécurité et confort d’utilisation… si la pratique fonctionne aussi bien que la théorie.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !