GPT-4, Gemini Pro, Llama 2 et Mistral Large connaissent désormais le nom de leur rival : Grok-1.

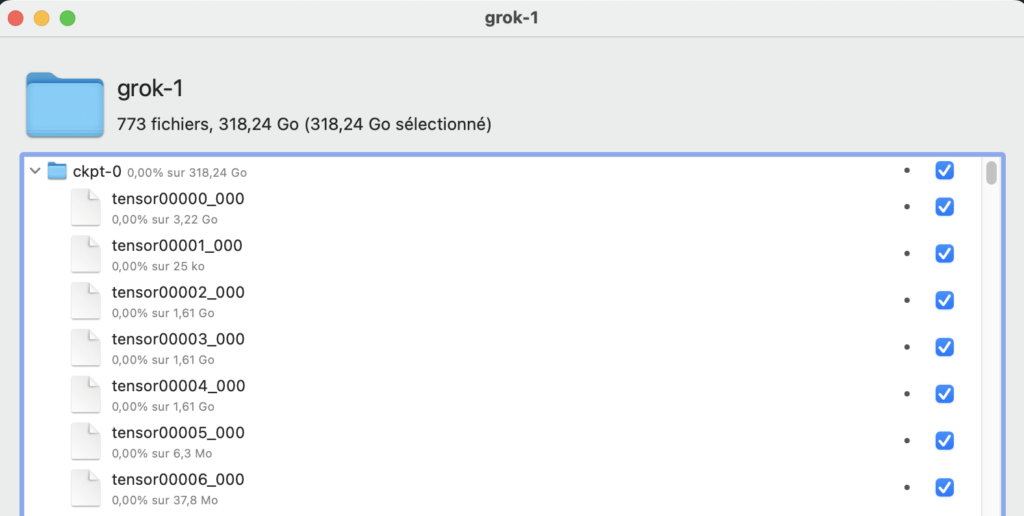

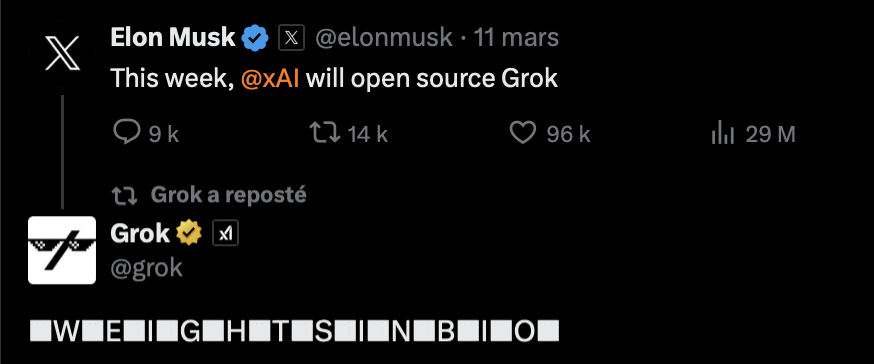

Depuis le 18 mars, les équipes d’Elon Musk proposent au téléchargement un gigantesque dossier de 318,24 Go, accessible sous la forme d’un fichier torrent (en bio sur son compte Twitter). Il contient un modèle de langage avec 314 milliards de paramètres, développé par l’entreprise xAI. C’est Grok-1 qui alimente le chatbot Grok, disponible sur X depuis la fin de l’année 2023. Mistral avait procédé à la même technique du torrent en décembre 2023.

Grok peut-il devenir une alternative sérieuse aux autres modèles de langage ?

Présenté par beaucoup comme une version satyrique de ChatGPT (il peut insulter ses utilisateurs et faire des blagues vulgaires), le chatbot Grok n’a jamais été considéré comme un concurrent sérieux dans la guerre de l’intelligence artificielle générative. Avec sa transformation en un modèle open source, et donc utilisable par quiconque le souhaite, la donne change peut-être.

Grok-1 n’est plus un modèle de langage exclusif au service d’Elon Musk, mais peut être testé localement par les personnes qui possèdent des machines assez puissantes. Ses développeurs l’ont aussi publié sur Github, pour inciter la communauté de l’IA à tester Grok-1. Le LLM d’Elon Musk devient une des références de l’open source, au côté du Français Mistral et du géant Meta (Google et OpenAI ont des approches plus fermées).

Dans un billet de blog, xAI explique que le modèle publié en torrent date d’octobre 2023 et qu’il se base sur une architecture appelée Mixture-of-Experts (MoE). Il s’agit d’un modèle restreint dans ses capacités, puisqu’il n’est pas conçu pour répondre directement à des besoins spécifiques (aux développeurs de l’adapter). Chaque token peut utiliser jusqu’à 25 % de la capacité totale de Grok-1, ce qui le rend plus efficace.

Début mars, Elon Musk avait annoncé porter plainte contre OpenAI, à qui il reproche d’avoir menti sur ses intentions (Elon Musk a contribué à créer l’entreprise, avant de s’éloigner du projet). OpenAI explique qu’Elon Musk rêvait de fusionner l’entreprise avec Tesla, ce qui avait provoqué un différend. Avec xAI, Elon Musk espère créer un contre-modèle à celui d’OpenAI, dans l’espoir de nuire à l’entreprise.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !