Google a-t-il menti sur l’intelligence de Gemini, son nouveau modèle de langage présenté comme supérieur au GPT-4 d’OpenAI ? Si rien ne permet aujourd’hui de remettre en question les affirmations du géant du web, force est de constater que Google a commis une erreur dans sa manière de présenter les choses.

Dans une vidéo de 6 minutes et 23 secondes, diffusée le 6 décembre 2023 et massivement partagée dans les médias et sur les réseaux sociaux, Google présentait Gemini comme une super-IA façon Jarvis (Iron Man), avec d’incroyables capacités de compréhension de ce qui l’entoure. Gemini semblait capable de voir le monde en temps réel et de le commenter, avec une logique digne d’un être humain. Son interlocuteur se contentait de petites relances orales à chaque fois, qui paraissaient suffisantes pour que l’IA devine ce qu’on lui demande et fournisse des réponses complètes. En réalité, Gemini ne se comportera probablement jamais ainsi.

Comme l’ont remarqué plusieurs internautes, le site de Google indique que plusieurs éléments ont été changés dans la vidéo de démonstration, qui fait passer Gemini pour ce qu’il n’est pas. Il n’y a rien de vraiment grave (au final, Gemini est vraiment capable de répondre comme dans la vidéo), mais la manipulation de cette démo risque de desservir Google.

Gemini ne peut pas commenter le monde en temps réel

Dans la vidéo de Google, le modèle de langage Gemini Ultra, qui sera disponible début 2024, est présenté sous sa forme multimodale. Il semble capable d’écouter ce qu’on lui dit, de voir le monde en temps réel et de répondre avec du texte énoncé par une voix de synthèse. La super-IA des films de science-fiction parait enfin prête, avec le potentiel de révolutionner le monde. Google présente d’ailleurs Gemini comme un « allié » plutôt qu’un logiciel.

En réalité, la multimodalité de Gemini Ultra n’a rien à voir avec la démonstration de Google.

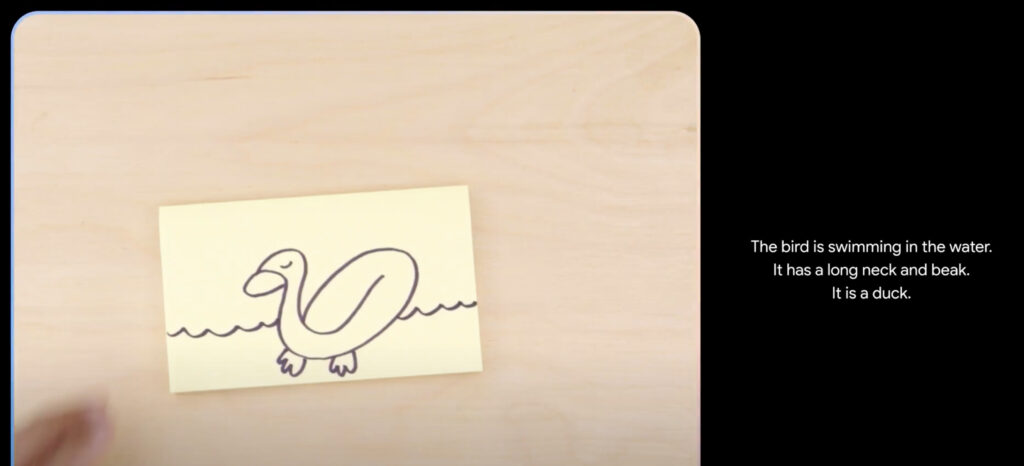

Un peu à la manière de Google Bard, le Gemini Ultra de la démonstration est un agent conversationnel qui accepte des requêtes textuelles et photographiques. Google ne lui a jamais posé de questions en parlant, tout était écrit. En ce qui concerne le contenu à analyser, Gemini Ultra ne le voyait pas en direct, mais se contentait de photos… Des tâches que ChatGPT sait aussi faire. Google indique aussi avoir fluidité le montage en raccourcissant les délais de réponse. Autrement dit, Gemini met du temps pour formuler du texte. La voix de synthèse a aussi été ajoutée manuellement.

En description de la vidéo sur YouTube, Google indique : « Pour les besoins de cette démonstration, le temps de latence a été réduit et les réponses de Gemini ont été raccourcies pour des raisons de brièveté ».

Encore plus problématique : les prompts ont été manipulés. Quand Google prétend demander à Gemini « quelle voiture va le plus vite ? », la réalité est qu’il lui a demandé : « en se basant sur l’aérodynamisme de ces voitures, quelle voiture ira le plus vite entre celle de gauche et celle de droite ? Explique pourquoi et détaille ta réponse ». Cet indice lui a permis de donner une réponse complète, qui mentionne l’aérodynamisme, mais sa réponse n’était pas spontanée.

Autre exemple, quand l’humain joue au jeu des gobelets, Gemini ne peut pas voir les déplacements. Il lui a été expliqué avec du texte que « le gobelet 1 a pris la place du gobelet 2 ». L’ordre des astres du système solaire est aussi bidonné, Google n’a pas juste demandé « est-ce que c’est le bon ordre » mais « est-ce que c’est le bon ordre en prenant en compte la distance avec le Soleil. Explique ton raisonnement ». La démo n’a plus rien à voir.

Dans un billet de blog publié sur son site pour les développeurs, Google détaille certains prompts envoyés à Gemini. L’entreprise confirme que sa démonstration consiste en une discussion textuelle avec des images. Les demandes sont beaucoup plus longues que celles énoncées dans la vidéo, ce qui a aidé Gemini à fournir des réponses qui semblent très intelligentes. Son but était sans doute de ringardiser ChatGPT… au risque de présenter une situation qui n’existe pas.

Bref, en l’état, Gemini Ultra n’est pas Jarvis. Il n’est qu’une version sophistiquée de Google Bard, avec une super compréhension des images.

Google envoie le mauvais message

Doit-on en déduire que Gemini n’est pas aussi intelligent qu’annoncé ? La réponse est non. Les réponses du modèle de langage sont bluffantes et prouvent que Google a probablement rattrapé son retard sur OpenAI, après une année compliquée durant laquelle Google a souvent donné l’impression que le créateur de ChatGPT l’avait complètement pris de court. Gemini semble être un pas en avant majeur vers le futur, avec la possibilité d’ajouter de la compréhension du contexte aux services de Google.

Malgré cela, il est impossible de ne pas voir une erreur majeure dans la communication de Google. Après avoir impressionné le monde, le Californien est maintenant en train de le décevoir. Gemini Ultra parait incapable de réaliser des tâches inédites. Finalement, il fonctionne de manière similaire à ChatGPT avec son module Vision (qui lui permet de voir des images). Il est regrettable de donner l’impression que Gemini est capable d’observer des flux en direct et de parler avec un humain en temps réel, puisque la vidéo de démonstration dessert finalement le vrai progrès technologique de Google.

Avec sa fonction ChatGPT Voice, OpenAI est plus proche de la démo de Gemini que Google. ChatGPT Voice lit les réponses de ChatGPT avec une voix de synthèse et donne l’impression que l’IA sait parler. Google pourrait sans doute faire de même un jour, mais Gemini en est incapable aujourd’hui. Pourquoi avoir fait croire l’inverse ?

En 2024, le monde de la tech devrait se battre pour continuer de faire avancer l’intelligence artificielle générative. Google se positionne plus que jamais comme le meilleur rival d’OpenAI. Mais, il lui faut maintenant développer des usages concrets, non falsifiés, que les gens souhaiteront utiliser (comme l’intégration d’une version lite de Gemini aux smartphones Pixel, avec un traitement local). Sur ce terrain, OpenAI a pris de l’avance.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !