Les webmasters ont désormais la possibilité de refuser que leur site web serve de terrain d’entraînement à l’intelligence artificielle (IA) de Google. Depuis le 28 septembre, l’entreprise américaine fournit un composant appelé « Google-Extended », qui permet de dire aux robots d’indexation du moteur de recherche si l’on souhaite ou non figurer dans le corpus d’entraînement de l’IA.

« En utilisant Google-Extended pour contrôler l’accès au contenu d’un site, l’administrateur d’un site web peut choisir d’aider ces modèles d’IA à devenir plus précis et plus performants au fil du temps », écrit Google dans son billet d’annonce. Mais il donne aussi la faculté aux éditeurs de sites web de refuser de participer aux projets de la firme de Mountain View.

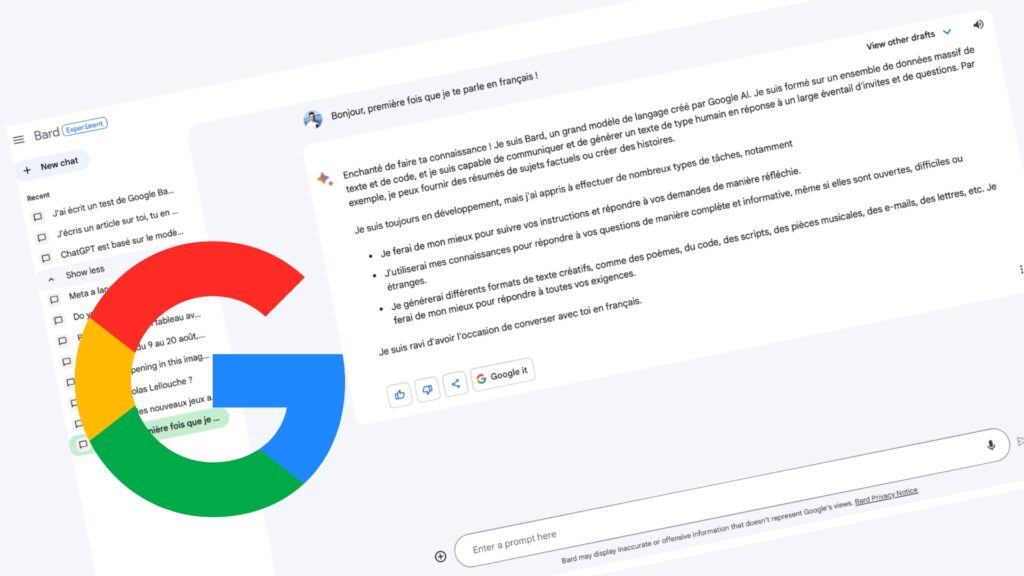

Typiquement, le composant Google-Extended aura une incidence sur Bard, le chatbot de Google, lancé ce printemps pour se frotter à ChatGPT d’OpenAI. Bard a pour particularité d’être connecté à Internet et de fonctionner avec le moteur de recherche, une spécificité que n’avait pas OpenAI jusqu’à la fin du mois de septembre. C’est en train de changer.

Grâce à son accès au web, Bard peut récupérer des informations actualisées et traiter des questions impliquant des données très fraiches. Il n’est pas restreint à un corpus d’entraînement figé, dont le contenu risque d’être progressivement daté. Pour cela, Bard a besoin de parcourir et d’extraire les textes accessibles publiquement sur le net.

Le problème, ici, est que tout cela se fait sans l’approbation explicite des sites web. Résultat des courses, les IA de Google (et plus généralement des autres) sont entrainées avec des données qui n’ont pas été approuvées. C’est un sujet qui a des implications importantes, en particulier en matière de droit d’auteur, avec des perspectives judiciaires complexes.

Un « interrupteur » pour sortir de l’IA générative de Google

L’outil Google-Extended, qui agit comme un interrupteur, donne ainsi aux sites web la possibilité de dire s’ils souhaitent sortir du champ d’entraînement de l’IA générative chez Google. Cela concerne Bard, mais aussi tous les autres projets derrière (en clair LaMDA, le modèle de langage sur lequel Bard repose) ou à venir, avec les futurs développements de l’IA générative.

Surtout, cela se fait avec un réglage assez fin pour refuser de servir de terrain d’entraînement, sans pour autant donner l’instruction qui consisterait à dire à Google que l’on ne veut plus non plus être référencé du moteur de recherche. Cela aurait des conséquences désastreuses pour la visibilité et l’accessibilité des sites, compte tenu du rôle que joue Google dans l’accès en ligne.

La mise en place de ce « switch » apparaît comme la solution intermédiaire la plus simple et rapide à mettre en œuvre, même si cela veut dire que l’aspiration des données reste le comportement par défaut (ceux qui ne s’en servent pas servent à l’entraînement). Il faut dire que l’on veut en sortir, au contraire d’un système qui reposerait sur le volontariat.

Cette autre voie ferait courir le risque, pour Google, de manquer de volontaires et de rendre l’accès au web finalement assez peu pertinent — la force d’un chatbot en ligne est de pouvoir chercher partout, ou du moins presque partout, et pas sur une poignée de sites. C’est aussi plus simple que de contacter un par un chaque éditeur pour lui demander son accord.

Cela ne constitue certes pas une approche idéale — il faut avoir connaissance de ce switch, et peut-être que des webmasters passeront à côté de cette information. À tout le moins, c’est en tout cas une première étape consistant à donner un moyen de contrôle pour les webmasters de ce qui est fait ou non avec leurs contenus. OpenAI a prévu un mécanisme similaire pour ChatGPT.

Tout ceci se fait à travers les règles d’indexation des sites web, des documents dans lesquels sont inscrites des consignes aux robots scannant automatiquement le web à la recherche de nouvelles informations. Ces fichiers sont appelés robots.txt et c’est là que l’on peut dire à un moteur de ne pas indexer telle ou telle partie d’un site web, par exemple. Ou de refuser l’IA, désormais.

« La mise à disposition de contrôles simples et évolutifs par l’intermédiaire de robots.txt est une étape importante dans la mise en place de la transparence et du contrôle que, selon nous, tous les fournisseurs de modèles d’IA devraient mettre à disposition », s’est félicité Google, qui s’engage à continuer sur cette lancée, pour que les éditeurs aient le choix et la maîtrise des choses.

Un volontarisme qui n’est toutefois pas tout à fait spontané. Google comme les autres sont de plus en plus poussés par les pouvoirs politique et législatif à être davantage responsables sur l’intelligence artificielle, compte tenu des enjeux que l’explosion de l’IA générative soulève. Le droit d’auteur est certes l’une des facettes, mais il y en a bien d’autres.

Vous aimez les IA ? Vous vous interrogez sur leurs limites ? Abonnez-vous à Artificielles, la newsletter écrite par des IA, vérifiée par Numerama. Tous nos articles sur le sujet y sont compilés et expliqués, une fois par semaine.

Nouveauté : Découvrez

La meilleure expérience de Numerama, sans publicité,

+ riche,

+ zen,

+ exclusive.

Abonnez-vous gratuitement à Artificielles, notre newsletter sur l’IA, conçue par des IA, vérifiée par Numerama !