Apple va bientôt déployer sur toutes ses machines un nouvel outil dédié à la lutte contre la pédocriminalité. Surnommée NeuralMatch, ce dispositif va analyser les photos mises en ligne sur iCloud (la solution de stockage à distance d’Apple) pour trouver d’éventuels clichés pédopornographiques et, si besoin, alerter les autorités.

Décrié par des spécialistes de la protection des données personnelles, cet outil est « conçu dans le respect de la vie privée des utilisateurs », annonce Apple sur son site. Pour rassurer sur sa démarche, la firme donne d’ailleurs quelques explications sur le fonctionnement technique de NeuralMatch.

Comment fonctionne NeuralMatch ?

Pour détecter les photos criminelles, Apple va comparer la signature électronique d’une image avec celles listées dans une banque de données fournie par le National Center for Missing and Exploited Children (NCME), une association américaine de défense pour le droit des enfants.

Lorsqu’une photo s’apprête à être exportée sur iCloud, l’iPhone ou l’iPad du propriétaire va comparer la signature de la photo avec la base de données téléchargée sur l’appareil. Si la signature de la photo partagée correspond à une image listée dans la base de données, alors une sorte de « ticket d’alerte » chiffrée est généré. Au-delà d’un certain seuil de tickets accumulés, une alerte est envoyée à Apple qui va pouvoir analyser les photos, potentiellement bloquer le compte incriminé et alerter la NCME.

Pour éviter les faux positifs, Apple explique que la base de données fournie par le NCME est téléchargée sur chaque appareil puis chiffrée pour empêcher de possibles manipulations malveillantes. La détection se fait donc sur la mémoire locale du téléphone plutôt que sur le cloud d’Apple et n’intervient que quand une photo est uploadée sur iCloud. Si la synchronisation n’est pas activée, Apple ne procédera à aucun scan.

Des garde-fous critiqués

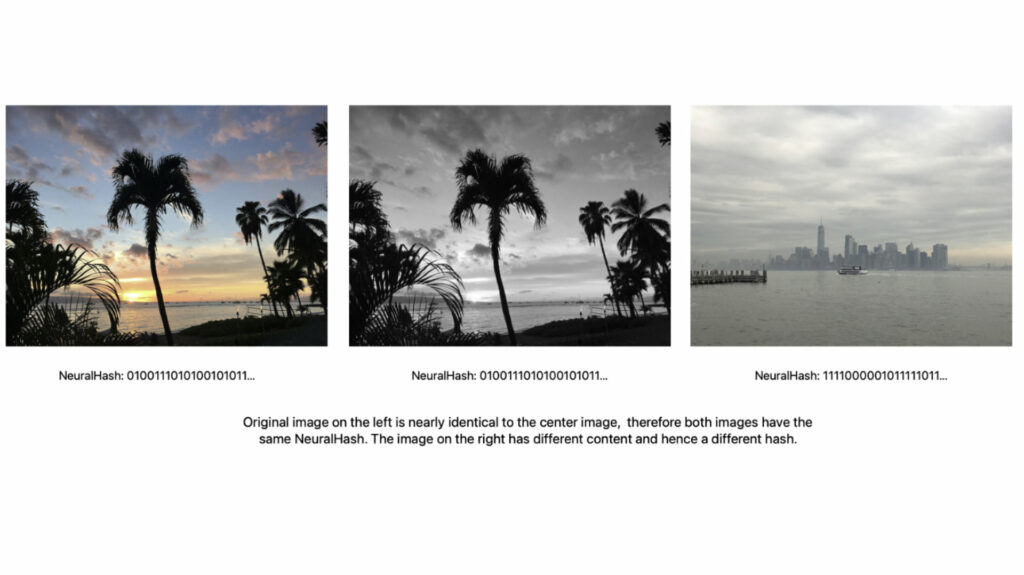

Plutôt que de comparer le contenu brut d’une image en opérant un scan du contenu, le téléphone va « analyser une image et la convertir en un numéro unique spécifique

à cette image ». Cette transformation de l’image en code binaire permet au téléphone d’effectuer une comparaison rapide avec la base de données et évite de transmettre trop d’informations quant au contenu des images. « Apple n’apprend rien sur les images qui ne correspondent pas à la base de données », explique l’entreprise dans sa documentation technique. NeuralMatch est suffisamment performant pour détecter des changements mineurs entre deux photos (recadrage, baisse en qualité) et leur associer la même signature cryptographique.

Enfin, Apple assure que si le seuil de « ticket d’alertes » n’est pas franchi, l’entreprise n’a pas accès à leur contenu. Apple ne précise pas à partir de combien d’infractions un compte sera passé au crible, mais assure que le système a seulement « une risque sur mille milliards » de créer de faux positifs. En cas d’erreur, les propriétaires pourront faire appel pour ne pas voir leurs comptes suspendus.

L’analyse cryptographique d’images pédopornographiques n’est pas exactement neuve, Apple opérait déjà des vérifications similaires sur les photos stockées sur iCloud. NeuralMatch inquiète cependant les spécialistes de la protection des données, car il opère en local sur le téléphone, ouvrant la porte à de potentiels abus. L’Electronic Frontier Foundation (EFF), célèbre ONG dédiée à la protection des droits sur Internet, qualifie l’outil de « porte dérobée » qui pourrait être utilisé par des gouvernements autoritaires pour détecter des contenus potentiellement hostiles au pouvoir, entre autres.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !