Ces photos parfaitement réalistes présentent le portrait de personnes qui n’existent pas. Ce sont des réseaux neuronaux entraînés par trois chercheurs de Nvidia qui les ont générés de toutes pièces. Les trois scientifiques ont publié une vidéo, accompagnée par leur papier de recherche, ce 12 décembre 2018. Ils devraient mettre leur code ainsi que leur base de données en open source dans les jours à venir.

Grâce à leur style-based GAN, les chercheurs de Nvidia peuvent générer une multitudes de visages réalistes, et ils peuvent même en contrôler les différentes variations selon leurs réglages.

De la forme du visage aux tâches de rousseur

Pour arriver à ce résultat, ils se sont appuyés sur un generative adversarial network (GAN), un système de machine learning utilisé notamment par des artistes, dont ceux de la peinture récemment vendue à 400 000 dollars. Ce système de machine learning met deux réseaux neuronaux en compétition. Le premier, le générateur, génère des images à partir des données qui lui sont fournies. Le second, le discriminateur, signale celles qui sont trop proches des images qu’on lui a donné. La tension entre ces deux réseaux neuronaux crée une boucle d’apprentissage, avec pour effet l’amélioration du GAN.

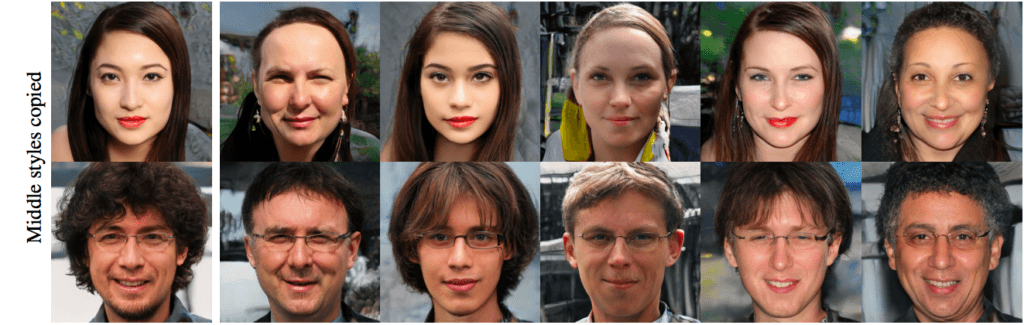

Les chercheurs de Nvidia ont construit leur propre GAN qui distingue différents « styles ». Par exemple, il sépare les attributs de « haut niveau » ou « grossiers » comme la posture ou la forme du visage, et les attributs de « niveau moyen » comme le nez, les yeux, et la bouche. Enfin il existe un troisième niveau, le style « raffiné » qui comprend les détails du visage.

Dans cet exemple, les chercheurs ne font varier que les attributs moyen. La posture et la forme du visage reste la même.

Source : NvidiaEnsuite les chercheurs peuvent régler le niveau de variation de chacun des styles (grossier, moyen ou raffiné), pour générer des visages plus ou moins ressemblants.

Pour finir, les scientifiques ont considéré que plusieurs aspects d’un portrait humain sont aléatoires (ou stochastiques), comme la position des poils, des pores, ou des tâches de rousseurs. « On peut donc les générer aléatoirement sans affecter notre perception de l’image, tant qu’ils sont correctement distribués », écrivent-ils dans leur étude. En insérant du bruit statistique, ils génèrent aléatoirement ces détails, de façon réaliste.

Plus de 70 000 photos ont nourri l’IA

Les scientifiques ont nourri ces réseaux neuronaux d’une base de données faite maison. Ils ont compilé 70 000 photos libres de droit en haute définition récupérées sur Flickr. Toutes ces photos ont été coupées au format 1024×1024, puis ils ont nettoyé la sélection avec des filtres. Enfin, ils ont utilisé un logiciel pour enlever de ces images les statues, peintures, ou photos qui pouvaient s’y trouver, afin de ne pas distraire les réseaux neuronaux.

Cette base de données comporte évidemment des biais, mais ils ont fait attention à avoir une diversité ethnique, d’âge, de genre et dans les arrière-plans. Les chercheurs ont également tenté d’utiliser ce même entraînement pour des images de voitures, de chambres, et surtout de chats, mais avec moins de réussite (malheureusement).

Dans quel but ?

Ces réseaux neuronaux ont été créés par des chercheurs de Nvidia, et leur code, ainsi que les bases de données sur lesquelles ils ont été entraînés, vont être mis en open source très prochainement. L’entreprise californienne ne devrait donc pas tirer de bénéfice direct du GAN développé par ses chercheurs, mais elle peut espérer tirer des bénéfices indirects si d’autres entreprises se l’approprient. Nvidia reste leader sur le marché des GPU (graphic process unit), ces processeurs graphiques utilisés à l’origine par l’industrie du jeu vidéo. Ils sont désormais convoités pour leur capacité à effectuer plusieurs calculs en parallèle, très utiles dans le machine learning, et essentiels pour faire fonctionner de telles intelligences artificielles.

Une fois passée l’admiration face à la prouesse technique, on peut s’inquiéter des potentiels usages qui pourraient être faits d’une telle technologie. On a déjà pu observer les dérives du deep fake, et l’on s’inquiète déjà de son potentiel usage dans des théories du complot, par exemple. Car avec ce niveau de réalisme, il est difficile, même pour un oeil entrainé, de distinguer une photo générée par ce GAN d’une photo réelle.

En tout cas, la recherche en machine learning et notamment du côté des GAN, progresse à grande vitesse, alors que les gouvernements commencent tout juste à penser à son encadrement législatif.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !