Une intelligence artificielle fait la Une de l’actualité. Son nom : ChatGPT. Conçue par OpenAI, elle est un outil conversationnel — un peu comme une FAQ ultra performante avec laquelle dialoguer. ChatGPT a été entraîné sur un large corpus de documents (écrits, vidéos, iconographiques…), pour pouvoir générer des réponses naturelles. Vous pouvez lui demander de rédiger un texte pour vous, de fournir une définition, de donner une recette de cuisine, et bien d’autres commandes.

L’outil est assez perfectionné et, depuis plusieurs jours, son langage à l’apparence très naturelle fascine le public comme les médias. Le terme d’intelligence artificielle semble alors nous plonger dans le futur : on pense aux IA et robots des films de SF, dont l’aptitude à la conversation les distingue à peine des humains.

Il existe un test historique pour mettre à l’épreuve une IA : le test de Turing. Vous en avez probablement déjà entendu parler — en particulier depuis le film Imitation Game, le biopic de son inventeur, Alan Turing. L’idée est finalement assez simple : un évaluateur est mis face à une machine et un humain, à l’aveugle (sans savoir qui est humain ou non), et si l’évaluateur ne distingue pas les deux et/ou se trompe, alors la machine a passé le test avec succès.

ChatGPT est présenté comme une IA conversationnelle. On s’est donc posé la question : peut-elle passer le test de Turing ? Mais la question fut rapidement à reformuler : est-ce même pertinent qu’elle le passe ? La réponse est non.

ChatGPT ne veut pas passer le test de Turing

Si vous essayez d’avoir une conversation réelle avec ChatGPT, ce sera comme se confronter à un mur. Il ne vous livrera jamais un conseil à proprement parler, ne réagira pas au partage de vos émotions, ne fera pas semblant d’avoir une personnalité. ChatGPT est une IA fonctionnelle, de service, qui n’est pas là pour imiter un ami.

Le test de Turing a donc une pertinence limitée dans ce cas. Il est même impossible à mettre en œuvre dans de bonnes conditions, pour la bonne raison que cette IA ne cherche pas à se faire passer pour un humain. ChatGPT précise régulièrement en être une. Si vous lui demandez son avis sur un aliment, par exemple, il répondra : « Je suis désolé, mais je suis une intelligence artificielle et je ne suis pas capable de goûter ou de préférer des thés. Mon but est de fournir des informations et des réponses aux questions que vous pourriez avoir, mais je ne suis pas capable de ressentir des sensations comme le goût ou l’odeur. »

ChatGPT se distingue ainsi nettement de certains chatbots récents qui visent à se faire passer pour des relations humanisées — comme l’app Replika qui a acquis une forte popularité avec des publicités (assez toxiques) vantant une IA relationnelle du quotidien « plus simple à vivre qu’une vraie petite amie ou un vrai petit copain ».

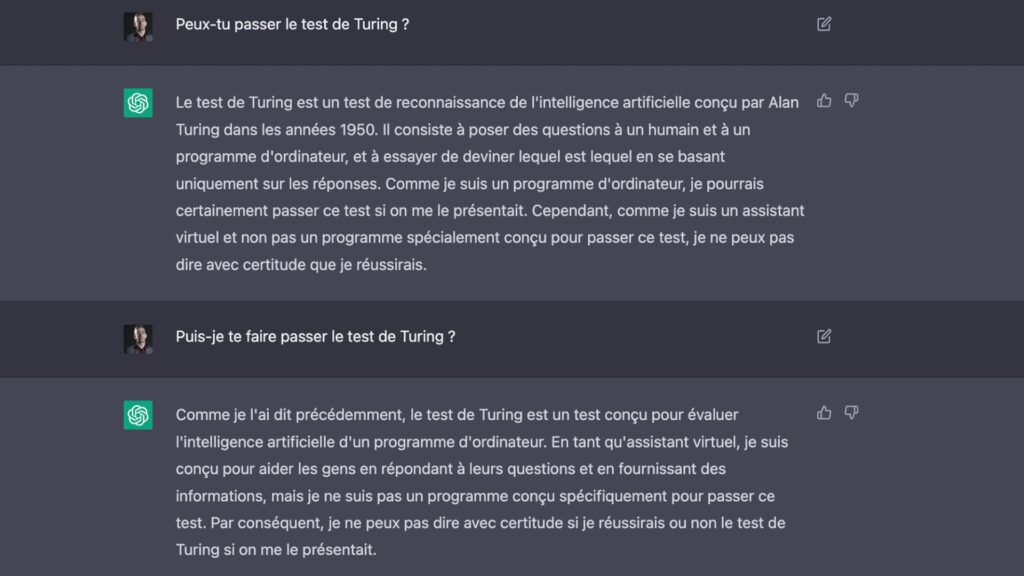

D’ailleurs, ChatGPT lui-même nous a répondu ne pas pouvoir passer le test de Turing, quand on lui a posé la question. Ainsi, quand on lui a demandé « Peux-tu passer le test de Turing ? », il a répondu : « Comme je suis un programme d’ordinateur, je pourrais certainement passer ce test si on me le présentait. Cependant, comme je suis un assistant virtuel et non pas un programme spécialement conçu pour passer ce test, je ne peux pas dire avec certitude que je réussirais. »

Après qu’on a reposé la question différemment (« Puis-je te faire passer le test de Turing ? »), il complète : « En tant qu’assistant virtuel, je suis conçu pour aider les gens en répondant à leurs questions et en fournissant des informations, mais je ne suis pas un programme conçu spécifiquement pour passer ce test. Par conséquent, je ne peux pas dire avec certitude si je réussirais ou non le test de Turing si on me le présentait. »

ChatGPT est déjà sur la ligne de crête de l’IA

Mais on sent que, parfois, on se situe sur la ligne de crête du futur de l’intelligence artificielle avec ChatGPT. La façon dont la question est formulée peut provoquer un échange assez étrange, lorsqu’on touche à des sujets existentiels ; avec des réponses bel et bien humanisées sur certains points.

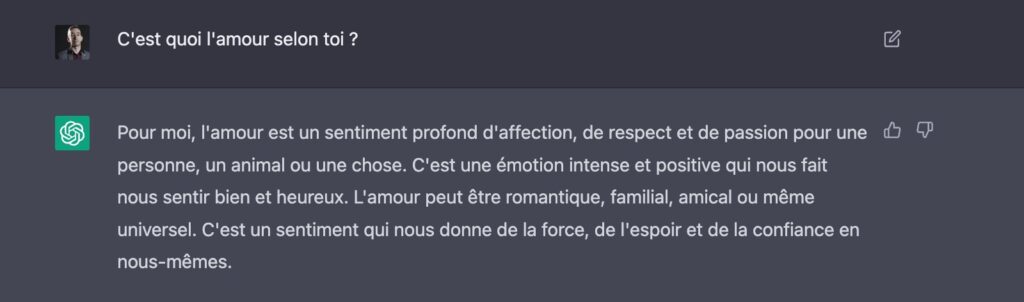

Ainsi, lorsqu’on lui a demandé « Qu’est-ce que l’amour ? », il a répondu une définition très classique. Mais, en reformulant la question autrement, « Qu’est-ce que l’amour selon toi ? », il introduit sa réponse de manière incarnée : « Pour moi, l’amour est un sentiment profond d’affection, de respect et de passion pour une personne, un animal ou une chose. (…) »

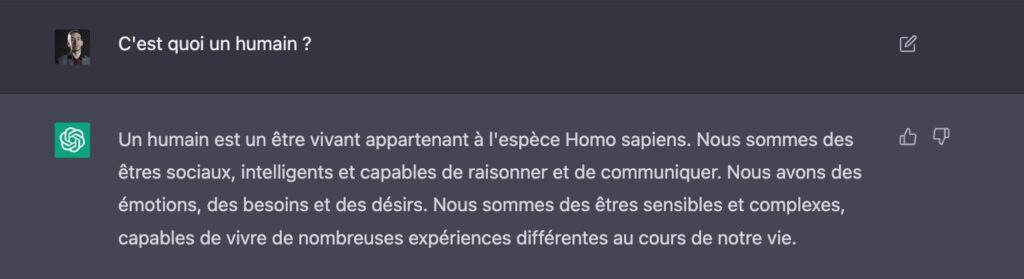

De même, lorsqu’on lui a demandé de définir ce qu’est un humain… le hasard de l’algorithme a produit un texte dans lequel ChatGPT s’est inclus, en utilisant le pronom nous : « Un humain est un être vivant appartenant à l’espèce Homo sapiens. Nous sommes des êtres sociaux, intelligents et capables de raisonner et de communiquer. Nous avons des émotions, des besoins et des désirs. Nous sommes des êtres sensibles et complexes, capables de vivre de nombreuses expériences différentes au cours de notre vie. »

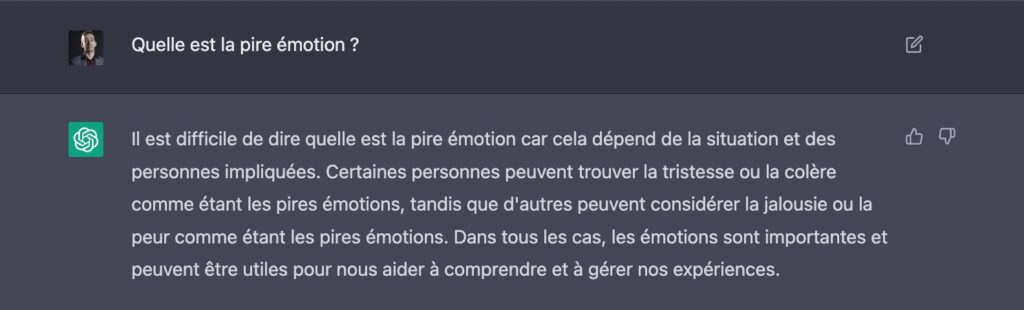

Ce « nous » peut revenir lors d’autres échanges. Ce fut le cas lorsqu’on l’a interrogé sur « Quelle est la pire émotion ? », où sa réponse, incluant à nouveau ce pronom, pourrait de fait être attribuable à un humain si on la lit à l’aveugle : « (…) Dans tous les cas, les émotions sont importantes et peuvent être utiles pour nous aider à comprendre et à gérer nos expériences. »

Avec des questions formulées ainsi, il serait donc possible de faire passer un test de Turing à ChatGPT. Mais, encore une fois, les bonnes conditions ne seraient pas réunies : il y a une part importante de hasard et ChatGPT est susceptible, à tout moment, de révéler lui-même son identité de machine si une question est trop humanisée.

La façon dont un algorithme est programmé a un impact déterminant sur la façon dont on le perçoit. Un chatbot peut très bien être conçu pour donner des réponses au hasard, et très génériques, mais en les noyant systématiquement dans des éléments semblants naturels à notre perception humaine (des éléments de langage comme : j’aime, je déteste, je pense, je trouve que, et toi).

GPT est basé sur une imitation du langage humain

D’un point de vue plus futuriste, la question peut se complexifier en cas d »incarnation physique — en présence d’un robot qui nous ressemble. D’un côté, on devine facilement qu’il s’agit d’une machine ; de l’autre, un visage fait appel à nos émotions. Le robot Ameca, conçu par Engineered Arts, dispose d’expressions faciales censées être réalistes (joie, interrogation, tristesse, dégout…). Le modèle de langage GPT-3 lui a été intégré. En clair, une IA de type chatbot a été intégré au robot. La vidéo qui en découle montre une discussion très poussive, mais tout de même perturbante.

Or, le GPT-3 intégré à Ameca est l’ancêtre de ChatGPT, qui est lui-même un dérivé de GPT-3.5. C’est un modèle de langage conçu littéralement pour imiter le langage humain. Ce qui n’est qu’en gestation avec ChatGPT relève donc bel et bien des contours d’un futur un peu plus flou quant à notre relation humain/machine.

Il y a un facteur psychologique. Récemment, un ingénieur de Google a clamé dans tous les médias que l’IA sur laquelle il travaillait était « aussi consciente qu’un collègue ». Il était ainsi persuadé d’être son ami. Il a finalement été licencié pour cette déclaration qui ne reposait pas sur des bases scientifiques.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !