« Les robots d’aujourd’hui manquent d’émotions », affirment Kingson Man et Antonio Damasio, dans un article de recherche paru dans Nature Machine Intelligence en octobre 2019. À leurs yeux, il est clair que cette absence dans la programmation robotique relève d’un frein à l’émergence d’une intelligence artificielle pour laquelle le mot « intelligence » aurait vraiment du sens. Mais pourquoi les sentiments seraient-ils si importants pour que les robots accèdent à un stade supérieur de conscience et de sentience ?

Vous avez probablement déjà vu passer des vidéos de Boston Dynamics : on y voit des robots humanoïdes, ou des robots-chiens, particulièrement performants. C’est un aspect que nous avons récemment approfondi dans Numerama : un scénariste de Battlestar Galactica et une professeure d’informatique nous expliquaient les raisons et la portée de l’anthropomorphisme robotique. Des vidéos similaires à Boston Dynamics, mais parodiques, ont été diffusées par un collectif appelé Corridor, sous le pseudo Bosstown Dynamics. On y voit des robots humanoïdes tout aussi performants en images de synthèse.

L’une de leur vidéo les plus virales, ci-dessus, développe un questionnement intéressant, au-delà de la parodie : on y voit un robot se faire « maltraiter » par des humains, puis, à la fin, la machine finit par contre-attaquer. La vidéo a eu d’autant plus de succès que tout le monde n’a pas remarqué immédiatement qu’elle provenait d’un compte parodique, quitte à se prendre de compassion pour le robot dans les premières minutes. Quoi qu’il en soit, cette vidéo montre un robot qui, sous le coup de la souffrance, finit par se « réveiller » comme pris d’un instinct de survie. Pour Kingson Man et Antonio Damasio, c’est justement en intégrant un tel désir de survivre que l’on pourrait apporter des sentiments aux robots.

Homéostasie : clé d’une vraie « intelligence » ?

L’idée des deux neuroscientifiques est que, pour qu’il y ait véritablement une intelligence — même artificielle — il faut un but. Ils estiment alors que si des machines intègrent la notion d’un péril envers leur propre existence, alors des émotions émergeront naturellement pour orienter leurs décisions compte-tenu de cet objectif supérieur : survivre.

Pour réussir à intégrer un tel but dans la programmation des IA, les chercheurs suggèrent de s’inspirer de l’homéostasie. Ce principe biologique fondamental permet qu’une forme de vie s’autorégule en permanence pour obtenir l’équilibre qui lui correspond le mieux. Un thermostat servant à réguler la température d’une pièce en est un exemple typique, mais de nombreux organismes vivants fonctionnent ainsi. C’est ce qui pousse à savoir quand il faut boire et se nourrir pour survivre. En neurosciences, des hypothèses avancent que l’homéostasie serait la clé de la conscience de soi (c’est d’ailleurs l’objet d’un livre écrit… par l’un des co-auteurs de l’étude, Antonio Damasio).

Maintenir un robot dans un état assisté, où les humains s’assurent du courant électrique, les bons câblage, la bonne température est tout l’inverse de l’homéostasie. Les deux neuroscientifiques pensent que les émotions ne peuvent pas émerger car, dans ce contexte, elles ne sont tout simplement pas nécessaires. « Le désir de survivre et de maintenir une certaine stabilité identitaire est un facteur nécessaire de la sentience, oui, sans doute », commente, pour Numerama, Sylvie Lainé, autrice de science-fiction et professeure en sciences de l’information et de la communication. Mais elle ajoute que l’homéostasie n’est pas forcément la solution miracle avancée par ces chercheurs. « De là à dire que ce serait un facteur suffisant… je ne crois pas que ce soit si simple, hélas. »

Le film Ex Machina pose la question de l'imitation des émotions par une IA (mais dans le film, c'est justement pour un but précis : s'échapper).

Source : Alex Garland

L’existence ou non d’émotions chez les robots pose, selon Sylvie Lainé, beaucoup trop de problématiques insolubles, notamment en raison de la programmation initiale du code source par des humains. C’est la fameuse question de l’imitation par la machine : comment différencier une émotion imitée d’une véritable émotion ?

Si on prend l’exemple de l’émotion du plaisir, et qu’on imagine qu’un robot l’aurait intégré, alors il « chercherait, comme nous, à maximiser son plaisir. Mais qu’est-ce qui lui ferait plaisir ? D’où pourrait venir ce plaisir ? L’aurait-on programmé pour obtenir du plaisir dans certaines circonstances ? Lesquelles ? Je ne peux pas répondre à ça sans dérouler toute une série de questions… ». D’ailleurs, les deux neuroscientifiques à l’origine de l’étude restent eux-mêmes assez prudents : dans leur article de recherche, ils évoquent des « équivalents » aux émotions.

Un robot peut-il vraiment être intelligent ?

Kingson Man et Antonio Damasio écrivent que l’homéostasie, et les pseudo-émotions qu’elle peut générer chez les machines, aurait la faculté de les rapprocher un peu davantage d’une véritable intelligence. De nos jours, les robots sont essentiellement pré-programmés pour effectuer des tâches précises. Si certaines IA peuvent battre des humains sur des jeux comme Starcraft II, il faut relativiser cette réussite : une telle machine ne sait rien faire d’autre. Tout comme cette fameuse main robotique capable de résoudre un rubik’s cube a été codée à l’avance arriver à accomplir cette tâche précise.

Les deux neuroscientifiques avancent que ces IA ne relèvent pas réellement d’une « intelligence » similaire à celle des humains, puisqu’on est capable d’innover face à toutes sortes de situations. Notre intelligence est multiple, complexe, autonome. Or, selon les chercheurs, tous les ingrédients sont déjà presque là pour incorporer de l’homéostasie et « libérer » les robots du contrôle des humains : la robotique molle et le deep learning, innovations émergentes grâce auxquelles les composants peuvent être flexibles et l’IA peut apprendre par elle-même. Résultat, combiner ces deux éléments permettrait aux robots non seulement d’appréhender leur environnement, mais également de surveiller leur propre état interne. Cela apporterait toute la complexité, l’autonomie et la conscience de soi nécessaires à l’intelligence.

« Les IA peuvent apprendre (dans une certaine mesure) mais peuvent-elles s’adapter ? »

Sylvie Lainé pose un bémol, puisqu’elle estime que le terme d’intelligence n’est ici tout simplement pas approprié. À l’heure actuelle, il serait plus judicieux, selon elle, de parler en termes de performance ou d’efficacité concernant les IA. « Nous avons abusivement simplifié la question [de l’intelligence] en inventant des mesures : le test de QI est une mesure de performance, qui permet de mesurer la capacité d’un être humain et sa performance dans différents domaines : intelligence spatiale, intelligence calculatoire, intelligence verbale (et donc culturelle) etc. », indique Sylvie Lainé à Numerama.

Pour elle, cette vision de l’intelligence sous forme de performance est réductrice, car « elle ne prend pas en compte l’intelligence émotionnelle, par exemple. Ni même le fait essentiel que l’intelligence, c’est la capacité de s’adapter, et d’adapter son comportement, à des situations nouvelles – et aussi la capacité d’apprendre. Les IA peuvent apprendre (dans une certaine mesure), mais peuvent-elles s’adapter ? »

Les lois d’Asimov

La nécessité d’un désir de survie chez les robots n’est pas une invention nouvelle. La science-fiction décrit très largement, dans ses récits, des moments où une machine, prenant soudain conscience qu’elle est en danger, atteint le stade de la sentience voire de la conscience. Le récent jeu vidéo Detroit : Become Human, du studio de jeux vidéo français Quantic Dream, met en scène visuellement cette idée : lorsque les personnages voient leur existence mise en danger, ils « brisent » le mur de leur pré-programmation et se libèrent, laissant libre court à leurs émotions.

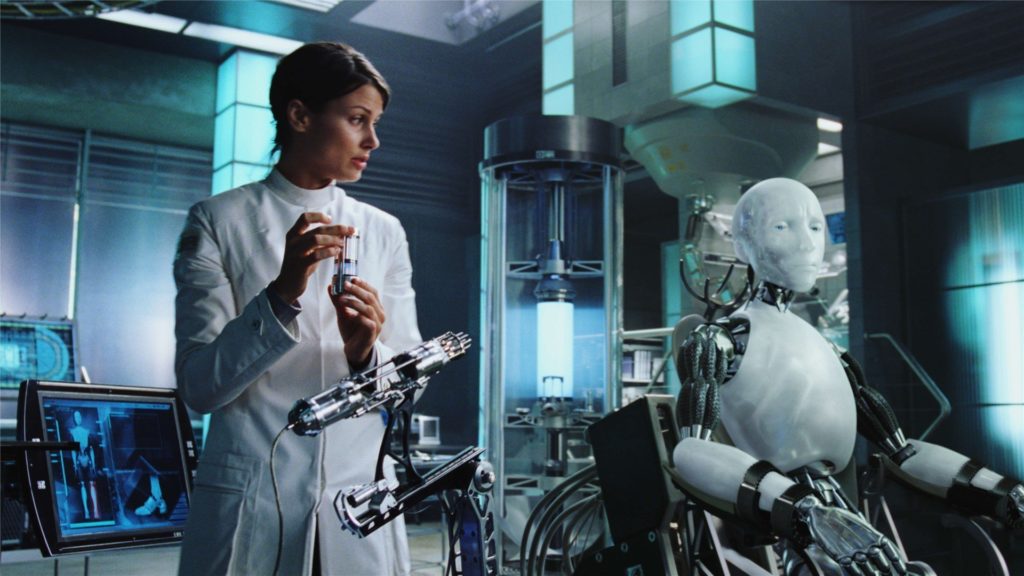

Le film I, Robot est librement inspiré des oeuvres d'Isaac Asimov.

Source : Davis Entertainment

La survie est également inscrite dans les lois de la robotique inventées par l’écrivain Isaac Asimov, dans son célèbre cycle Les Robots. Si la Première loi indique qu’un robot ne doit pas porter atteinte à un être humain, et que la seconde précise qu’il doit obéir aux ordres des humains, la Troisième loi énonce clairement qu’« un robot doit protéger son existence ». Mais elle contient aussi une limite : cette préservation entre en vigueur seulement si elle n’arrive pas en contradiction avec la première loi et la deuxième loi. « Asimov a été très prudent en mettant ses lois dans le bon ordre – l’ordre de priorité des trois lois est encore plus important que les lois elles-mêmes ! », nous indique Sylvie Lainé.

Cette prudence semble relever d’une forme d’inquiétude que l’on retrouve énormément dans les œuvres de SF : un robot qui accède aux émotions va bien souvent se rebeller contre ses créateur — les humains. Car son désir de survie entre alors bel et bien en contradiction avec la relation humain / machine. Sylvie Lainé pense que ce syndrome si souvent mis scène s’explique « parce qu’on imagine que dès qu’un robot éprouvera du plaisir, ce sera parce qu’il aura obtenu une satisfaction conforme à sa nature. Il voudra donc tout connaître, ou bien il voudra que tout soit bien rangé, propre et optimisé. Or les humains ont des choses à cacher, et sont un grand facteur de désordre. »

Les deux neuroscientifiques à l’origine de l’étude parue dans Nature sont assez optimistes, bien plus que dans l’approche asimovienne. Ils sont persuadés qu’un robot avec des émotions bénéficiera bien de toutes les émotions, y compris l’empathie. Si le robot est capable de comprendre les sentiments des autres, alors, selon eux, il n’y a aucun risque que l’on en arrive à une situation désastreuse façon Terminator.

Kingson Man et Antonio Damasio suggèrent finalement que les « lois de la robotique » soient plus épurées : 1) se sentir bien 2) ressentir de l’empathie.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !