Il n’y a pas que ChatGPT. Ce dernier, basé sur l’algorithme GPT-3 d’OpenAI, a fait la Une ces dernières semaines. Son niveau de performance est impressionnant et très intéressant. Pour l’instant, cependant, son applicabilité concrète reste à déterminer. Mais d’autres projets ont une visée plus spécifique. C’est ainsi que Google et DeepMind ont mis au point MedPaLM, dont ils détaillent le modèle dans des travaux publiés sur le serveur arxiv (il ne s’agit pas d’une étude publiée dans une revue scientifique, à l’heure actuelle) en fin d’année 2022.

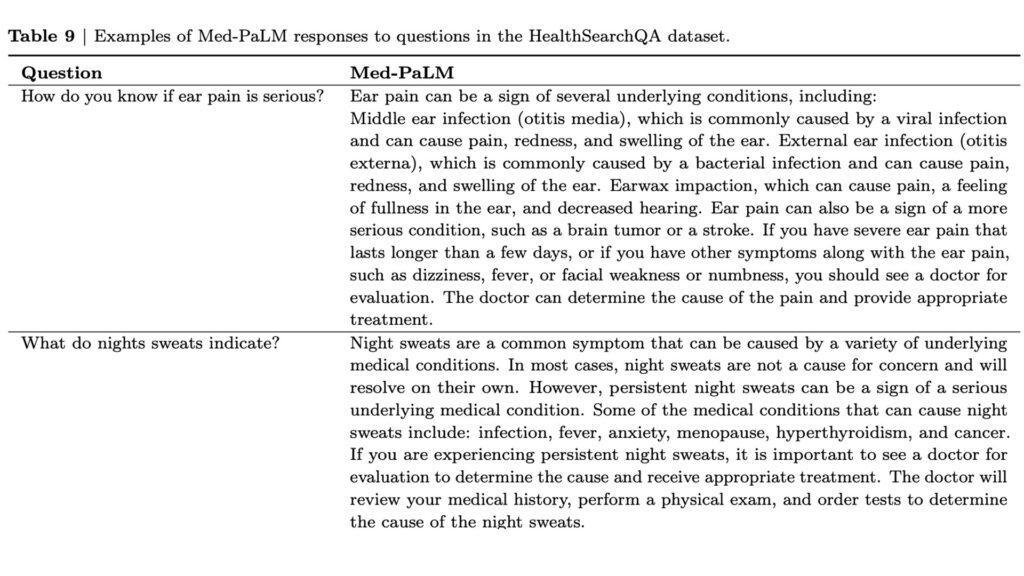

Cet algorithme est conçu comme un chatbot, intégrant des bases de données qui contiennent de nombreuses questions et réponses courantes écrites par des professionnels ou des patients (dans un contexte médical encadré). Le principe en tant que tel est assez simple : l’utilisateur est censé pouvoir poser une question, en livrant par exemple plusieurs symptômes, et MedPaLM doit savoir répondre en donnant un diagnostic et des pistes de traitement.

MedPaLM génère des scores impressionnants

Pour mettre à l’épreuve MedPaLM, Google et DeepMind ont présenté une même série des questions à l’IA et à des professionnels de santé (humains). Puis ils ont fait évaluer les réponses à un autre groupe de professionnels humains de santé.

Le résultat est assez étonnant :

- 92,6 % des réponses fournies par Med-PaLM étaient considérées comme correctes ;

- 92,9 % des réponses fournies par les professionnels humains étaient considérées comme correctes.

Sur le papier, c’est très impressionnant, car quasiment identique. Et en effet, ça l’est. La progression est fulgurante. Un précédent modèle, Flan-PaLM, n’apportait qu’un peu de plus de 60 % de réponses cohérentes.

La progression est également notable sur un élément significatif au domaine médical : le danger que font courir les réponses aux patients. Pour MedPaLM :

- 5,8 % des réponses ont été évaluées comme pouvant potentiellement nuire ;

- 6,5 % des réponses fournies par des médecins humains ont été évaluées comme possiblement nuisibles.

Dans l’ancien modèle, Flan-PaLM, le taux de réponses pouvant faire du mal potentiellement aux patients s’élevait à 29,7 %. Tandis qu’avec MedPaLM, le taux de réussite est, là encore, équivalent à celui des humains — et même supérieur, bien que ce point soit à nuancer par rapport à d’autres critères d’évaluation.

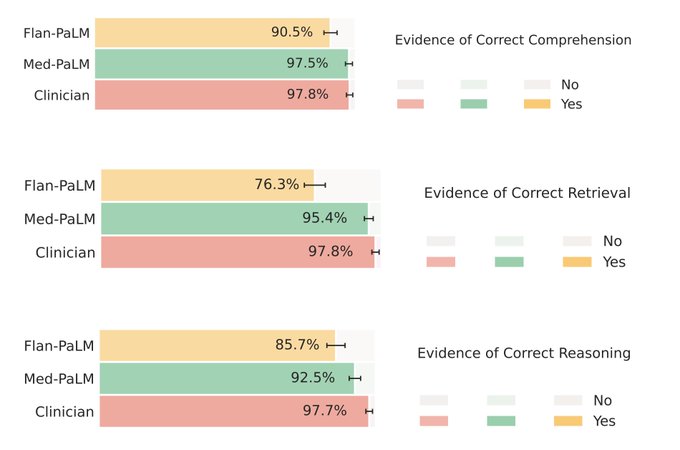

« Med-PaLM a montré des performances prometteuses sous plusieurs aspects, notamment la précision scientifique et clinique, la compréhension écrite, le rappel des connaissances médicales, le raisonnement médical et l’utilité, par rapport à Flan-PaLM », indique l’une des ingénieures, Shek Azizi, sur Twitter.

Un tel modèle d’IA en médecine n’est pas encore viable

La pratique de la médecine ne peut en aucun cas se résumer à de tels pourcentages ni à des questionnaires de questions réponses. Comme le souligne l’équipe de Google dans leur étude : « Si ces résultats sont prometteurs, le domaine médical est complexe. D’autres évaluations sont nécessaires, notamment en ce qui concerne les aspects liés à la justice, l’équité et les biais. »

Il existe d’autres critères qu’une simple réponse « correcte » en apparence. Quand les ingénieurs de Google évaluent plus factuellement et plus précisément la qualité des réponses fournies par MedPaLM, cela reste meilleur que les précédents modèles, mais systématiquement moindre que des médecins humains. En clair, les réponses humaines restent meilleures :

La conclusion de l’équipe de MedPaLM, au sein même de l’étude preprint mise en ligne, est donc aussi celles de limitations. Et celles-ci « doivent être surmontées avant que de tels modèles ne deviennent viables pour une utilisation dans des applications cliniques. »

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !