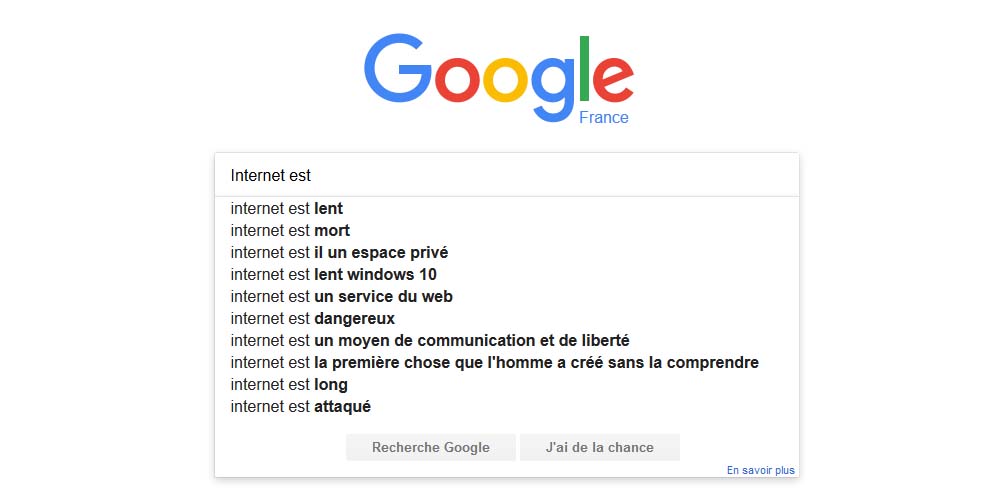

Vous l’avez forcément déjà remarqué si vous utilisez Google. Quand vous tapez les premiers mots de votre requête, une liste de suggestions s’affiche afin de vous faire gagner du temps en anticipant votre recherche. Cette saisie semi-automatique en vigueur depuis 2008 permet aussi de corriger les termes avec la bonne orthographe.

Hélas pour Google, l’outil lui a souvent causé des soucis.

Le dernier incident en date a été révélé à la suite d’un papier publié dans les colonnes du Guardian. Signé par Carole Cadwalladr, il met en lumière la façon dont certaines dérives de la saisie semi-automatique peuvent fausser la perception qu’ont les internautes de la réalité, en suggérant par exemple que les musulmans sont comme ceci, les femmes comme cela, et ainsi de suite.

Suggestions malheureuses

C’est justement ce que la firme de Mountain View a de nouveau fait après l’enquête du journal britannique. Comme l’a noté Ars Technica, les suggestions associant « les juifs sont-ils » ou bien « les femmes sont-elles » à « mauvais(es)» n’ont désormais plus court sur le site. Mais le coup de balai n’a pas été total. Nos confrères notent par exemple que l’association « les musulmans sont-ils » avec « mauvais » perdure.

Cité par le Guardian, Google explique que ses « résultats de recherche reflètent le contenu du web. Cela signifie que les représentations parfois désagréables de sujets sensibles sont susceptibles d’affecter les résultats de recherche apparaissant pour une requête donnée ». Et d’ajouter, au cas où, que ces résultats ne reflètent pas les opinions de la société, qui se dit ouverte à la diversité.

les termes proposés peuvent donc parfois sembler étranges ou surprenants

Dans ses pages d’assistance, Google explique que « les prédictions de recherche sont générées automatiquement par le biais d’un algorithme, sans aucune intervention humaine. Cet algorithme est basé sur un certain nombre de facteurs objectifs, tels que la fréquence de recherche d’un terme par les autres internautes et conçu pour refléter la diversité des informations présentes sur le Web ».

L’entreprise ajoute « qu’en raison de cette diversité, les termes de recherche proposés peuvent donc parfois sembler étranges ou surprenants ». Certaines prédictions peuvent ne pas fonctionner, parce que le terme est trop rare ou trop récent ou parce qu’il enfreint les règles du moteur de recherche (il est lié à de la pornographie, à du piratage, à une activité criminelle, etc).

Ce n’est pas la première fois que la saisie semi-automatique pose problème à Google. Déjà en 2010, l’entreprise américaine avait dû filtrer des suggestions inappropriées. En Europe, le système a provoqué des actions judiciaires en Italie, en Allemagne ou en France avec des conclusions parfois différentes. Dans certains cas, Google s’était résolu à modifier son outil pour éviter certaines associations malheureuses.

En France, l’affaire la plus emblématique concernant les prédictions de Google portait sur les associations de certaines personnalités avec le mot « juif ». Les organisations de lutte contre le racisme et l’antisémitisme avaient porté plainte contre l’entreprise américaine, lui reprochant de lier ce terme à des personnalités dans les suggestions de recherche. Le dossier s’était conclu par un accord amiable confidentiel.

Il est tout à fait possible de signaler à Google des suggestions choquantes, en remplissant le formulaire adéquat, selon le cas de figure : la prédiction associe votre nom, propose un contenu inapproprié ou engendre un problème juridique. La demande de suppression n’est pas automatique : elle sera passée en revue par les équipes de Google qui décideront si oui ou non il faut lui faire droit.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !