Le groupe de chercheurs chinois Keen Security Lab, financé par Tencent, continue ses expérimentations sur les voitures Tesla. Dans une nouvelle étude publiée le 29 mars 2019, ils sont parvenus à réaliser trois choses : activer les essuie-glaces en faisant croire qu’il pleuvait, tromper l’Autopilote lors d’un changement de voie et contrôler le volant à distance avec une manette.

Premier point à savoir, la Model S utilisée par Keen Security Lab disposait d’un firmware qui commence à dater (le 2018.6.1, déployé l’année dernière). Autrement dit, peut-être que les failles décelées ont été corrigées depuis.

Le réseau neuronal trompé par des objets physiques

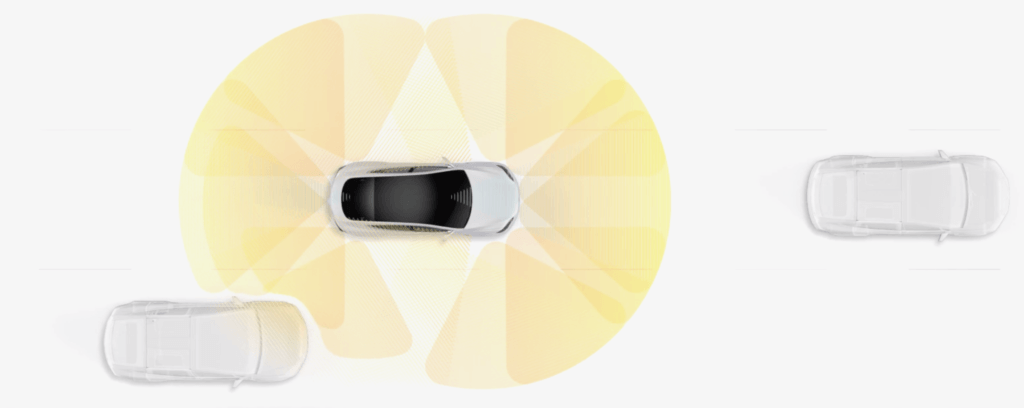

Concernant les essuie-glaces, Keen Security Lab rappelle qu’il s’active non par un capteur d’humidité, mais par l’algorithme capable de détecter la pluie grâce aux caméras de l’Autopilote. Keen Security Lab est parvenu à tromper la technologie en diffusant une image sur un téléviseur. Bien évidemment, il ne s’agit pas d’un risque de sécurité, simplement d’une limite du réseau neuronal amené à évoluer dans le temps. « Ce n’est pas une situation de la vie de tous les jours », explique Tesla, qui rappelle que les essuie-glaces automatiques fonctionnent toujours en bêta.

Pour tromper le changement de voie opéré par l’Autopilote, Keen Security Lab a simplement collé des autocollants sur la route. « L’Autopilote de Tesla reconnaît les voies et assiste la conduite en identifiant les marquages au sol. Grâce à nos recherches, nous pouvons prouver que placer des autocollants interférents sur la route amène l’Autopilote à enregistrer ces informations et à la juger anormalement, ce qui fait prendre une mauvaise voie à la voiture », explique l’institut. Un résultat qui rappelle certains accidents survenus quand l’Autopilote était actif et que le marquage au sol n’était pas net. Il fait dire à Tesla que le conducteur a toujours la possibilité de (et même, doit) reprendre le contrôle pour corriger les erreurs de jugement de l’intelligence artificielle.

Enfin, grâce à un hack du système animant l’Autopilote, Keen Security Lab a réussi à prendre le contrôle du volant via une manette connectée à un appareil mobile. En fonction du mode de conduite, le contrôle peut être limité au-delà d’une certaine vitesse. Sur cette vulnérabilité, Tesla explique que des correctifs ont été appliqués en 2017 et en 2018.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !