C’est une formulation qui est souvent associée aux intelligences artificielles génératives. Lorsqu’un chatbot se trompe dans la réponse qu’il doit donner, on dit qu’il « hallucine ». Un mot pudique pour dire qu’il répond à côté de la plaque ou donne une mauvaise explication. Tout l’enjeu des concepteurs en IA est de réduire l’hallucination de ces outils génératifs.

C’est sur cette problématique que la société Anthropic s’est positionnée ces jours-ci, en détaillant ses avancées obtenues grâce à une nouvelle version de son chabot, Claude. Dans un article de blog paru le 21 novembre, l’entreprise américaine a fait la présentation de Claude 2.1, qui est un rival de ChatGPT, le célèbre agent conversationnel d’OpenAI.

Un chatbot plus juste, et plus prudent dans ses réponses

Ce Claude 2.1 « a réalisé des progrès significatifs en matière d’honnêteté », affirme Anthropic, par rapport à Claude 2.0, dont les premiers pas remontent au début du mois de juillet (Claude 1.0, lui, date de mars). En particulier, les fausses déclarations du chatbot auraient été divisées par deux entre les deux dernières versions du modèle de langage.

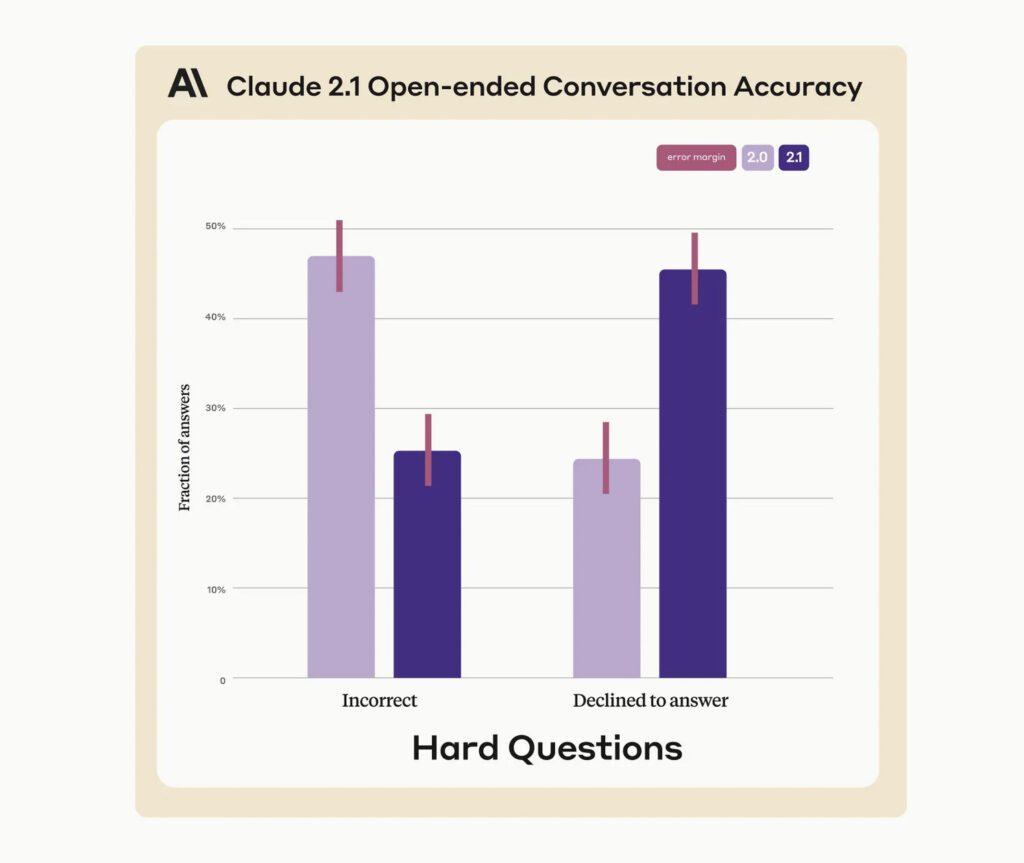

« Nous avons testé l’honnêteté de Claude 2.1 en rassemblant un grand nombre de questions factuelles complexes qui sondent les faiblesses connues des modèles actuels », poursuit Anthropic, qui a partagé à cette occasion quelques graphiques qui comparent les performances des deux modèles. L’une des solutions a été de régler Claude 2.1 pour qu’il dise quand il ne sait pas.

« Claude 2.1 a été beaucoup plus enclin à refuser [de répondre] plutôt qu’à fournir des informations incorrectes », écrit Anthropic. De fait, le taux d’hallucination a donc baissé, selon la société, passant d’une imprécision proche de 50 % sur les questions difficiles à une imprécision autour de 25 %.À l’inverse, Claude 2.1 reconnaît bien plus souvent quand il n’est pas sûr de lui.

La propension à décliner une réponse est ainsi passée de 25 % avec Claude 2.0 à presque 50 % avec Claude 2.1 — des résultats qui comportent une marge d’erreur notable, relève Anthropic, mais pas au point de transformer en profondeur le rapport de force entre les deux modèles. En creux, mieux vaut retenir une réponse que formuler quelque chose de faux.

Une meilleure compréhension des textes difficiles

Autre avancée vantée par Anthropic : des « améliorations significatives » dans les résumés et la compréhension de textes, notamment ceux « longs et complexes qui exigent un haut degré de précision ». Tombent dans cette catégorie les rapports financiers, les spécifications techniques ou encore les documents juridiques, précise la société.

Selon l’évaluation de l’entreprise, Claude 2.1 « a démontré une réduction de 30 % des réponses incorrectes et un taux 3-4x plus faible de conclusion erronée qu’un document soutient une revendication particulière ». Des résultats encourageants, selon Anthropic, car le succès d’un chatbot repose essentiellement sur la précision et la fiabilité des résultats.

Ces mesures sont toutefois à considérer avec précaution : elles reposent sur les affirmations d’Anthropic, selon une méthodologie propre et un test interne dont les contours sont flous. L’entreprise n’a de toute évidence pas partagé avec son billet d’annonce de ressources permettant une revue et une analyse des conditions de ce banc d’essai par des pairs dans l’IA.

L’outil conçu par Anthropic n’en demeure pas moins une solution de grande valeur : la preuve avec l’investissement important que mobilise Amazon dans ce projet. En septembre, le géant du e-commerce a investi 4 milliards de dollars. Précédemment, Amazon avait aussi annoncé le projet Bedrock, dans lequel le chabot Claude était déjà intégré.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !