Comment reconnaître un texte écrit par un élève d’un texte écrit par une intelligence artificielle ? Depuis l’arrivée de ChatGPT et son interdiction dans les écoles de New-York et à Sciences Po, c’est la question que se posent beaucoup de professeurs. Même si l’utilisation du chatbot développé par OpenAI n’est pas encore formellement interdite dans tous les établissements, ChatGPT reste polémique.

Il n’y avait surtout pas encore d’outil véritablement efficace pour détecter les textes générés par IA, ce qui compliquait encore la tâche des professeurs. Depuis le 31 janvier, c’est désormais chose faite : OpenAI vient de rendre publique une intelligence artificielle, elle-même chargée de dire si un texte a été écrit par IA. Vous pouvez la retrouver ici.

Un outil qui marche, mais qui a des limites

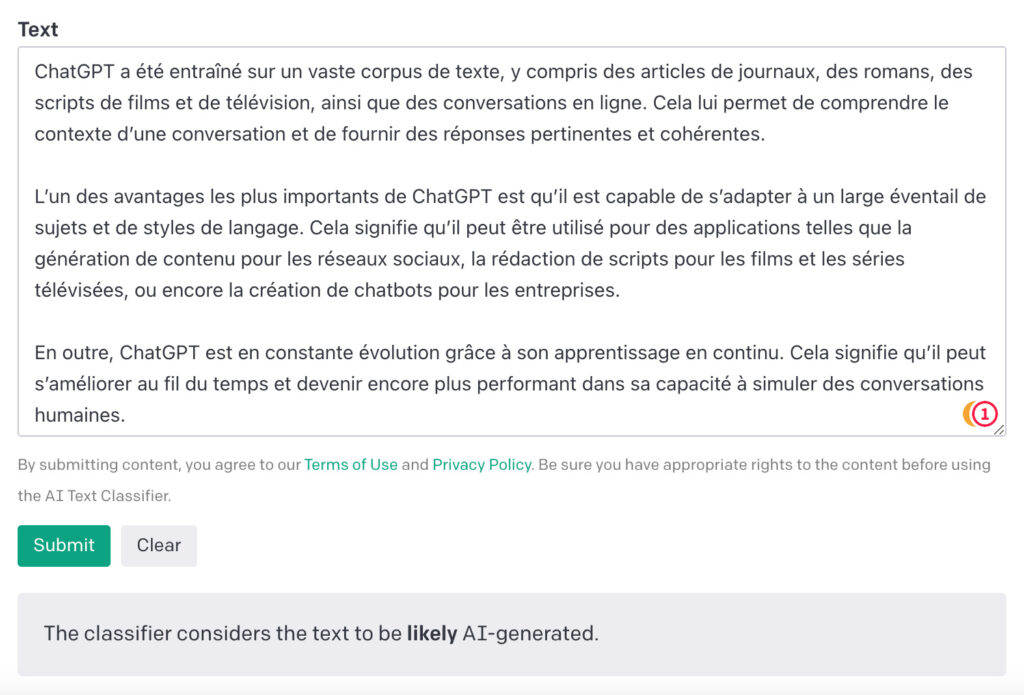

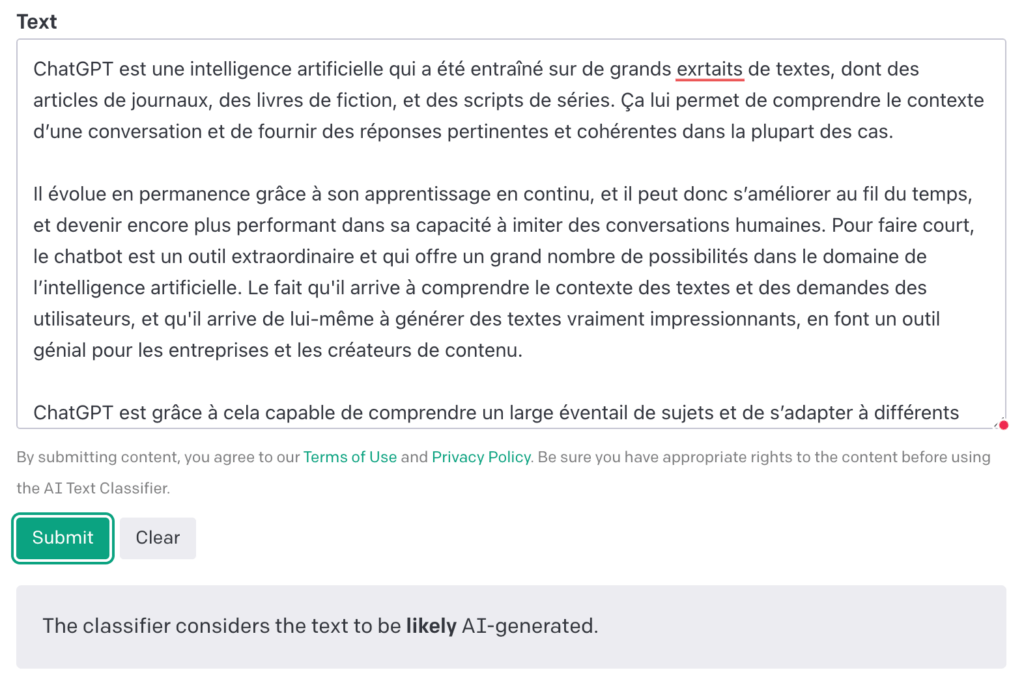

L’outil publié par OpenAI s’appelle « AI Text Classifier ». Une fois sur la page, il suffit de coller un texte dans l’encart dédié et d’appuyer sur le bouton vert « Submit » afin d’avoir le résultat — qui arrive en quelques secondes. L’IA vous dira si le texte renseigné est « likely » (probablement) écrit par un humain, ou une intelligence artificielle ; ou s’il l’est « possibly » (possiblement).

Nous avons fait le test en reprenant des extraits de notre article sur ChatGPT que nous avions fait écrire par ChatGPT, et Text Classifier a bien trouvé.

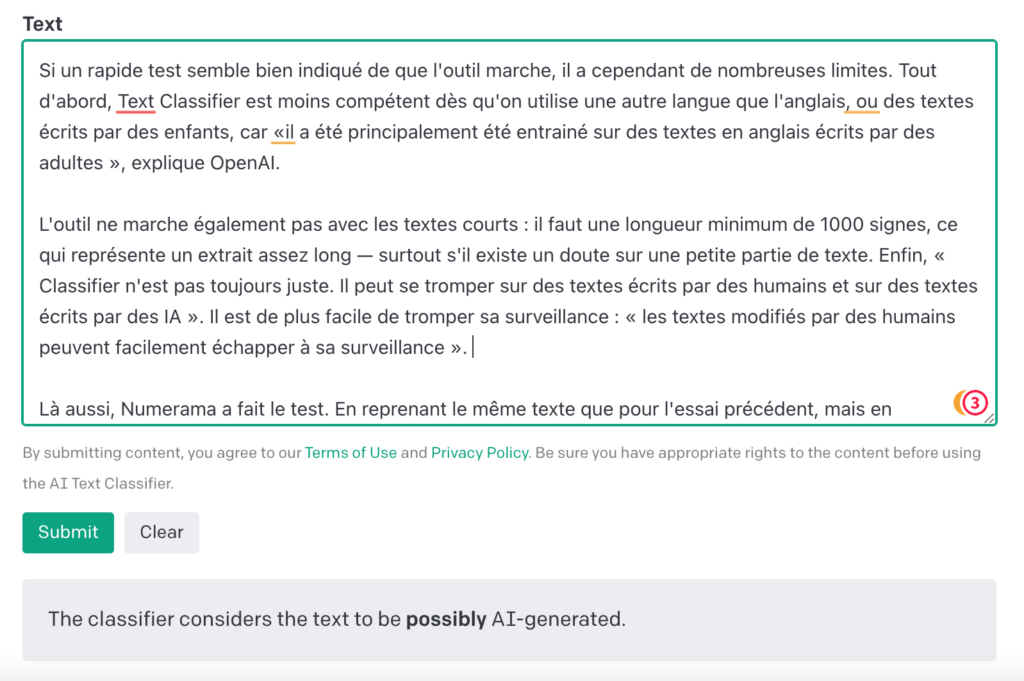

Nous avons ensuite essayé avec des extraits de cet article, et nous avons pu voir les premiers bémols. Classifier n’a pas su dire que l’article avait été écrit par un humain. À la place, l’outil a indiqué que l’extrait avait été « possiblement » écrit par une intelligence artificielle.

On voit donc que Classifier a des limites, ce qu’OpenAI reconnaît également. L’entreprise a annoncé que Classifier « identifie correctement 26% des textes écrits par IA en tant de « probablement écrit par des IA » », et qu’elle se trompait en « indiquant que des textes écrits par des humains avaient été générés par des IA 9% du temps ».

Il est aussi important de noter qu’il est moins compétent dès qu’on utilise une autre langue que l’anglais ou des textes écrits par des enfants, car « il a été principalement été entrainé sur des textes en anglais écrits par des adultes », explique OpenAI.

L’outil ne marche également pas avec les textes courts : il faut une longueur minimum de 1000 signes, ce qui représente un extrait assez long — surtout s’il existe un doute sur une petite partie de texte. Enfin, « Classifier n’est pas toujours juste. Il peut se tromper sur des textes écrits par des humains et sur des textes écrits par des IA », indique la page.

Il serait également facile de tromper sa surveillance : « les textes modifiés par des humains peuvent facilement échapper à sa surveillance ». Là aussi, Numerama a fait le test, et les résultats sont surprenants. En reprenant le même texte que pour l’essai précédent, mais en changeant des tournures de phrase, en faisant des fautes d’orthographe, en ajoutant et supprimant des mots, et en modifiant l’ordre des paragraphes, Classifier ne s’est pas trompé sur le résultat final : pour lui, le texte est toujours « probablement » écrit par une IA (suis-je vraiment humaine ? Je ne sais plus.)

Le fait que Classifier arrive à retrouver les textes générés par IA est impressionnant. Mais, tant qu’il n’arrive pas complètement à détecter ceux écrits par des humains, il ne pourra pas être un outil utilisé massivement, notamment dans le cas de professeurs. En attendant, il s’agit cependant d’un premier bon indicateur — et OpenAI rappelle qu’il s’agit d’un « projet toujours en cours de développement ».

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !