Musique et intelligences artificielles : le duel commence ? Des IA pour générer des images, comme Midjourney, sont déjà sur le marché. De son côté, ChatGPT s’illustre dans la génération de texte. Les deux programmes fonctionnent de manière un peu similaire : on entre un « prompt », une commande, qui conduit l’algorithme à générer la réponse voulue, que ce soit une grenouille avec un parapluie sur Mars pour Midjourney, ou une recette de cuisine pour ChatGPT.

Les applications de ce type d’IA sont nombreuses et un géant comme Google planche sur de nombreux domaines — comme la médecine avec MedPaLM. Mais les travaux que le groupe a mis en ligne le 26 janvier 2023 concernent le monde de la musique. Le programme s’appelle MusicLM.

Cette IA génère des sons à partir de prompts. En clair, on insère d’abord une description textuelle : « une mélodie de violon apaisante soutenue par un riff de guitare distordu ». En réponse, MusicLM génère « de la musique à 24 kHz qui reste cohérente pendant plusieurs minutes », décrivent les ingénieurs.

« Une mélodie de violon apaisante soutenue par un riff de guitare distordue »

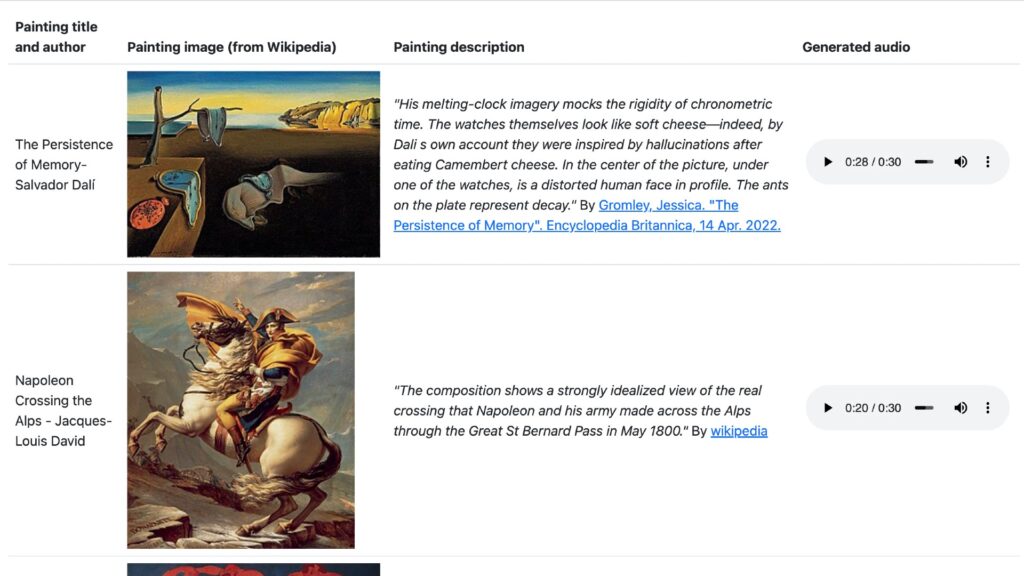

Pour accompagner leur papier de recherche, les chercheurs de Google ont aussi mis une plateforme en ligne où l’on trouve des exemples de tout ce que peut faire MusicLM. Le site présente toutes les fonctionnalités :

- Génération audio à partir d’une description complexe : « un morceau funky avec un rythme fort et dansant et une ligne de basse proéminente. La mélodie accrocheuse d’un clavier ajoute une couche de richesse et de complexité à la chanson », en guise de prompt donne un son de 30 secondes.

- Génération longue : le même procédé, mais pour un morceau complet jusqu’à 5 minutes.

- Mode histoire : sur le même principe, il est possible de faire évoluer le son à partir d’une séquence de prompts, un peu comme un medley passait du jazz au rock puis à la pop.

- Conditionnement du texte et de la mélodie : ce procédé est similaire à une demande adressée à Midjourney pour un style de peinture particulier. Vous pouvez demander de jouer Bella Ciao soit au piano, soit à la guitare, soit en sifflements, etc.

- Conditionnement par une image : MusicLM génère un son à partir d’une peinture et de sa légende. Le Bonaparte de Jacques-Louis David sera ainsi transformé en une séquence audio triomphante, par exemple.

- Génération de 10 secondes à partir de texte : des courts sons, comme des samples, pour des instruments (« guitare », « flute »), ou alors un genre spécifique (« rap », « 90s Berlin house »…), une atmosphère liée à un lieu (« plage aux caraïbes », « évasion de prison »), une époque (un club des années 80 vs. un club des années 2000), et même… un niveau de compétence (du piano venant d’un débutant ou d’un professionnel).

La plateforme montre que l’algorithme est capable de faire beaucoup de choses, mais les résultats plutôt mitigés pour l’instant. Les sons ne sont pas très agréables à écouter — tantôt dissonants, difformes, très plats. Les paroles chantées sont également très médiocres, et une voie d’amélioration pour les futurs travaux, comme l’admettent les ingénieurs eux-mêmes dans leur papier.

Le procédé technique lui-même, en revanche, est performant : d’après les ingénieurs de Google, en tout cas, il surpasserait tous les modèles précédents en matière de qualité audio et de fidélité au texte. Par exemple, sur la plateforme, on constate que l’algorithme est capable de « diversité » en générant un son différent pour une même description à chaque fois.

Il fait peu de doutes que l’arrivée d’un tel algorithme va, à son tour, avoir des implications éthiques faisant débat. On se souvient qu’il y a de cela quelques jours à peine, le chanteur Nick Cave s’agaçait des fans lui envoyant des paroles demandées à ChatGPT « dans le style de Nick Cave ». Il dénonçait des textes vides et « merdiques ». Les artistes, de manière générale, alertent sur les implications sociales (et philosophiques) de ces outils dans le milieu de l’art.

Google passe à l’attaque sur l’IA

La publication de ces travaux n’est pas une surprise. Tout d’abord car l’on savait déjà que Google planchait sur des IA liées à la musique. Ce type d’algorithmes a été mobilisé en 2021 par les équipes de Google Arts & Culture, en collaboration avec de vrais musiciens, pour transformer le célèbre tableau de Kandinsky en séquences musicales.

Ensuite, les New York Times révélait à quel point Google prépare sa contre-attaque face à ChatGPT. Le géant des GAFA souhaiterait sortir pas moins de 20 produits liés aux intelligences artificielles. Et ce, dès mai prochain. Le papier sur MusicLM n’est pas officiellement publié encore, il doit être accepté dans une revue scientifique pour attester de la valeur des recherches, ce qui peut prendre quelques mois — une chronologie assez cohérente avec des annonces publiques au printemps 2023.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !