Dans une longue et dense enquête du Guardian, le développeur français Guillaume Chaslot, 36 ans apparaît comme un véritable lanceur d’alerte. Cet ancien employé de Google, dont il a été limogé en 2013 pour avoir, affirme-t-il, cherché à bousculer les méthodes a depuis fondé une association visant à révéler le vrai visage des algorithmes, dont celui de YouTube.

Des algorithmes dangereux pour la démocratie

La plateforme vidéo de son ancien employeur est désormais pointée du doigt par son association, AlgoTransparency : selon leurs recherches, dont nous avions déjà détaillé la méthodologie en avril 2017, YouTube favoriserait certaines vidéos politiques au détriment d’autres. Le Guardian conclut de la même manière que les vidéos les plus clivantes, les plus étranges et de qualité faible seraient les plus mises en avant par l’algorithme qui propose des contenus à regarder aux internautes.

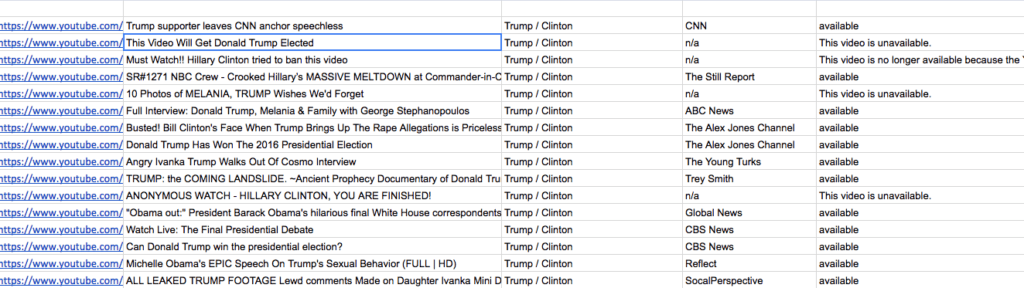

551 vidéos pro-Trump contre seulement 92 vidéos pro-Clinton dans les vidéos les plus recommandées

L’enquête s’attarde pour le montrer sur la campagne américaine durant laquelle — parmi les vidéos les plus recommandées — le quotidien compte 551 vidéos pro-Trump contre seulement 92 vidéos pro-Clinton. Pour le quotidien britannique, il n’est pas temps question de montrer que YouTube soutenait Trump. Mais plutôt que l’algorithme, prétendument neutre, finit automatiquement par favoriser les mêmes types de contenus — dont les théories du complot prisées par la droite américaine.

Extrait de la base de données consultée par le Guardian pour son enquête / Google Docs

Il est bien question de vidéos mises en lignes par des internautes, dont une poignée de sites conspirationnistes. L’affaire n’est pas à lier avec l’intervention russe qui était faible sur YouTube et concentrée sur trop peu de vidéos pour peser. Le sujet remet donc en avant la question des bulles de filtrage et de la neutralité des algorithmes en montrant que YouTube n’a pas eu besoin d’intervention russe pour se montrer très partial.

« Les algorithmes de recommandation de YouTube sont des machines à désinformer »

Google rejette la méthode employée par AlgoTransparency et rappelle auprès du Guardian que son algorithme s’intéresse d’abord aux contenus qui sont davantage vus par les utilisateurs. D’une certaine manière, l’entreprise nous rappelle que si nous avons un problème avec l’algorithme, nous avons un problème avec la consommation du public.

La question semble plus complexe. L’ingénieur français défend l’idée de méthodes possibles et simples pour briser les bulles et éviter d’enfermer l’utilisateur dans un nivellement par le bas des contenus. Ces méthodes, selon Chaslot, n’auraient pas intéressé Google, obnubilé par le temps de visionnage de ses utilisateurs.

Le Guardian rappelle que pour le modèle économique de YouTube, la diversité et la qualité des contenus est une problématique secondaire. L’objectif principal d’un tel algorithme est de nourrir l’utilisateur de contenus attirants afin qu’il passe davantage de temps sur la plateforme, et, ainsi, consomme toujours plus de publicités.

Zeynep Tufekci, sociologue citée par le Guardian notait sur Twitter : « De nombreux journalistes s’en prennent légitimement à Faceboook et Google pour [l’élection] de 2016 — mais manifestent moins de remords et de compréhension quant à leur propre échec catastrophique. YouTube était le sujet le plus négligé de 2016. Sa recherche et ses algorithmes de recommandations sont des machines à désinformer. »

Zeynep Tufekci, sociologue respectée spécialiste des nouvelles technologies, compare cette démarche à de la malnutrition. Auprès du quotidien britannique, elle explique : « C’est un peu comme une cantine d’école qui serait automatisée : elle découvre que les enfants ont les dents sensibles et aussi qu’ils aiment la nourriture grasse et salée. Donc vous faites une file d’attente offrant une telle nourriture, chargeant automatiquement le prochain plat dès que le sachet de chips ou de bonbon des jeunes est terminé. » YouTube, peu sensible à la diversité politique de son contenu, tendrait à mettre en avant les contenus les addictifs, les plus clivants, au détriment de la diversité.

Sur cette métaphore, le Guardian rappelle qu’en regardant la vidéo de Logan Paul dans laquelle il s’approchait d’un cadavre, il suffisait de quelques clics, recommandés, pour tomber sur une vidéo glauque d’enfants se faisant arracher les dents avec un outillage précaire.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !