« Cette image a été générée par IA » : lorsqu’on inspecte les images générées par les outils de l’entreprise OpenAI, il sera désormais plus facile d’identifier avec quelle intelligence artificielle elles ont été générées.

C’est OpenAI, la firme menée par Sam Altman, à l’origine de ChatGPT, qui a annoncé dans un billet de blog du 7 février 2024 cette mise à jour, calquée sur le protocole appelé C2PA (Coalition for Content Provenance and Authenticity).

Cette coalition fondée en 2021 par Adobe et d’autres firmes (BBC, Intel, Microsoft) a pour objectif de créer un standard universel et open-source pour reconnaître l’origine des images publiées en ligne. Le but recherché est de lutter contre la désinformation à travers des objets visuels modifiés pour influencer l’opinion publique.

Réussir à identifier si une image a été altérée ou non est l’un des plus grands défis du partage d’information en ligne. Jadis, la question concernait plutôt les outils comme Photoshop, mais désormais, les IA génératives permettent de créer des volumes inédits de contenus, avec une simplicité et une rapidité non égalée.

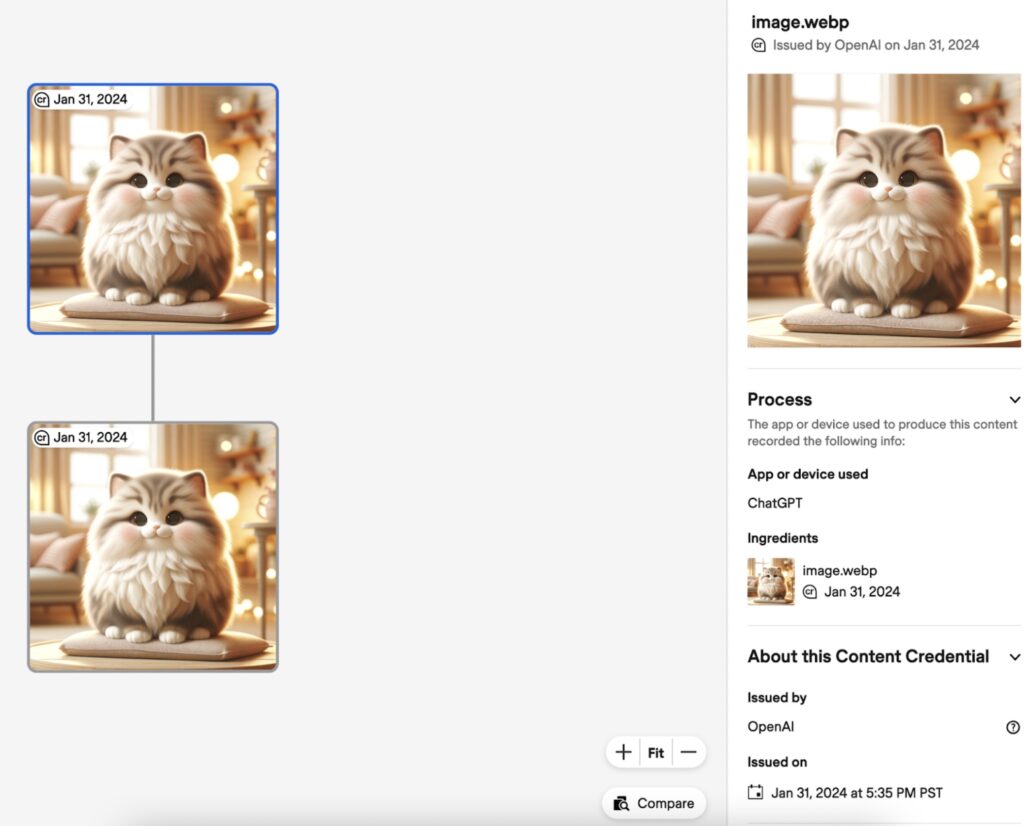

La C2PA milite pour l’ajout de métadonnées supplémentaires : ce sont des données, visibles ou invisibles, qui donnent des informations sur d’autres données. En l’occurrence, il s’agirait ici d’un petit visuel ajouté en haut à gauche de l’image, avec la date de sa création et un pictogramme qui indique qu’elle n’est pas naturelle. Dans les données supplémentaires, il est écrit que l’image a été créée grâce à OpenAI et que l’outil utilisé est ChatGPT, ce qui est plus précis qu’auparavant.

À ce jour, seules les images fixes sont concernées, pas les vidéos.

OpenAI précise toutefois que ces outils ne sont pas infaillibles : « Puisque les métadonnées peuvent être retirées, leur absence ne voudra pas dire qu’une image n’a pas été produite par nos IA », rappelle la firme dans un tweet. « L’adoption plus large de méthodes permettant d’établir la provenance et d’encourager les utilisateurs à identifier ces signaux sont des étapes pour augmenter la fiabilité des informations en ligne. »

Comment utiliser les IA de manière raisonnable ?

Numerama a testé l’outil DALL-E via ChatGPT 3.5 et ChatGPT 4, mais pour l’instant, l’outil n’a pas incorporé le watermark visuel à nos images.

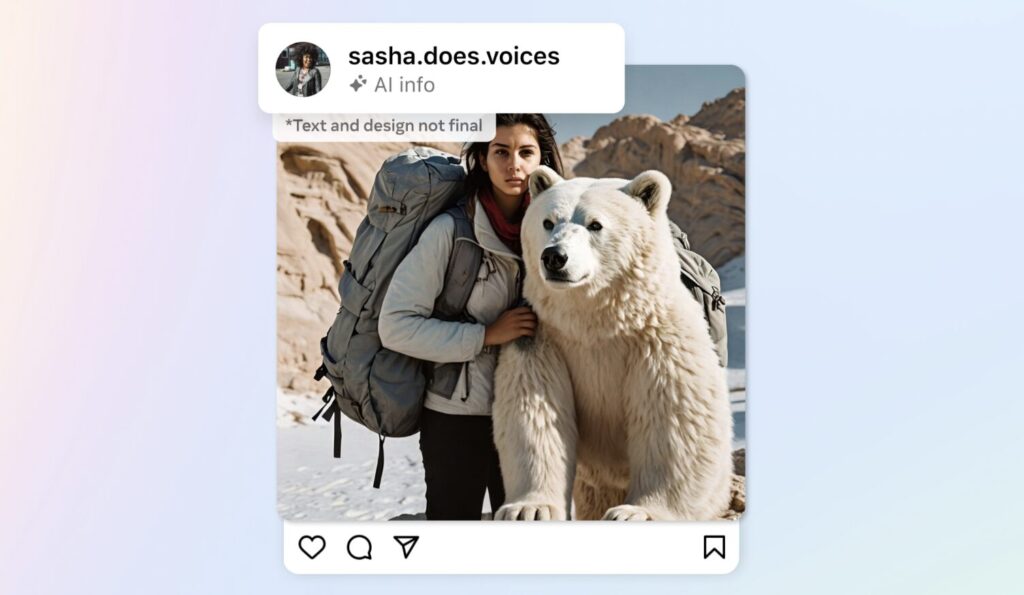

L’annonce d’OpenAI fait suite à celle de Meta (Facebook, Instagram), le matin même, qui a dit travailler la détection et l’identification des contenus produits par IA sur ses réseaux sociaux. « Dans les mois à venir, nous étiquetterons les images que les utilisateurs publient sur Facebook, Instagram et Threads, lorsque nous pourrons détecter des indicateurs correspondant aux standards de l’industrie indiquant qu’elles sont générées par IA », a écrit le président Nick Clegg. Meta développerait des outils en interne, capables de détecter une image par IA générée sur des plateformes concurrentes.

Les utilisateurs et utilisatrices auront également la possibilité de déclarer eux-mêmes si l’image qu’ils publient a été créée par une IA ou non.

De nombreux sites d’information se sont aussi écharpés cette dernière année, pour savoir comment utiliser les outils de production d’image, sans prendre le risque de générer de la défiance du public.

Numerama a décidé d’ajouter un watermak « IA » visible (créé par notre équipe design) sur chaque image produite via Midjourney ou Dall-E, ainsi que de suivre certaines règles de base — ne pas tenter de reproduire l’image d’une personnalité existante, par exemple.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !