L’exascale est l’aboutissement actuel du long processus d’évolution du calcul sur ordinateur. La performance d’un ordinateur se mesure en nombre d’« opérations flottantes », multiplications et / ou additions, qu’il peut réaliser par seconde et, plus précisément, sur les nombres réels codés sur 64 bits. On note Flops/s cette unité.

Sur nos téléphones portables ou ordinateurs personnels, pour naviguer toujours plus rapidement sur Internet ou bien pour visualiser interactivement des vidéos, on compte en milliards d’opérations par seconde (giga). Sur les machines les plus grosses, c’est en puissance de mille. Giga est la troisième puissance (1 0003 soit 109), puis viennent dans l’ordre tera, peta et exa. Ces préfixes du système international des unités sont des déformations du grec tetra, penta et hexa, elles sont ainsi assez faciles à mémoriser. L’exascale correspond donc à l’échelle des superordinateurs dont la capacité de calcul dépasse 10 puissance 18 Flops/s.

Le calcul à haute performance (HPC) vise l’exécution le plus rapidement possible d’applications scientifiques comme la simulation nucléaire ou la météorologie. Les besoins en calcul dépassant les capacités humaines sont apparus pendant la Seconde Guerre mondiale et sont toujours en augmentation depuis, avec la numérisation massive de la société et la mondialisation.

Une évolution continue depuis les années 60

L’histoire du calcul à haute performance a suivi les grandes étapes technologiques depuis l’invention des circuits intégrés au début des années 60 jusqu’aux technologies 5 nanomètres récentes. Les processeurs vectoriels apparaissent dans les années 70. Ils sont conçus sur un jeu d’instructions réduit qui fonctionne efficacement sur de grandes collections de données homogènes. À partir des années 80, on assiste au développement du parallélisme avec en particulier les multiprocesseurs massivement parallèles, grand nombre d’unités de calcul reliées par des réseaux d’interconnexion sophistiqués.

Vers le milieu des années 90 apparait un autre type de supercalculateurs, basés sur l’idée d’assemblage de matériels généralistes. Poussé à l’extrême, cela a donné naissance au calcul pair à pair où n’importe qui pouvait mettre à disposition sa propre machine connectée à Internet pour contribuer à une expérience scientifique ambitieuse comme le repliement de protéines. La notion d’accélérateur (co-processeur spécialisé, plus efficace sur un certain type d’opérations) apparaît vers 2000 et prend une dimension cruciale avec les GPUs (processeurs graphiques) à l’origine du développement de l’apprentissage profond en 2013.

Aujourd’hui, tous les processeurs grand public récents intègrent plusieurs unités dédiées. Les GPUs ont évolué et leur parallélisme poussé les rend très performants pour du calcul matriciel et tensoriel, spécialisé pour l’apprentissage automatique comme les TPUs de Google.

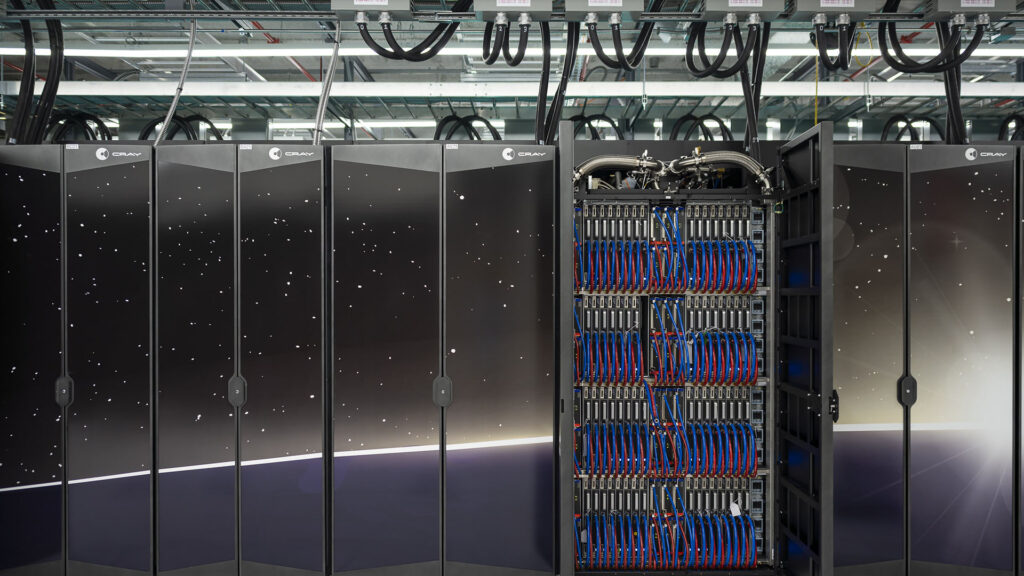

L’objectif exascale a été atteint en 2022 avec l’entrée du supercalculateur Frontier en tête du Top500. Il s’agit du classement des 500 systèmes les plus performants au monde. Ce classement est effectué après une préparation minutieuse d’un supercalculateur sur des benchmarks classiques d’algèbre linéaire. Les systèmes HPC les plus puissants ne sont pas tous dans le Top 500. Les grandes entreprises ou les militaires possèdent des systèmes HPC qui n’y figurent pas.

À l’image de la conquête spatiale, être parmi les premiers au Top 500 est clairement un enjeu géopolitique, emmené par les États-Unis, pour affirmer la suprématie et la souveraineté technologiques. La France et l’Europe se sont dotées de programmes pour construire leurs propres systèmes exascale.

La question de la consommation électrique des plates-formes HPC à large échelle a toujours été présente, mais elle devient cruciale aujourd’hui avec la lutte contre les émissions carbone qui sont à l’origine de la crise climatique. Certains pensent que la course à la performance peut contribuer à résoudre les défis écologiques actuels, mais des voix de plus en plus nombreuses alertent sur une fuite en avant qui participe à l’accélération incontrôlée et prônent pour un ralentissement, d’autant plus qu’il y a très peu d’applications qui nécessitent vraiment une telle puissance. Dans le débat sur ces deux positions opposées, les politiciens et les technophiles envisagent déjà l’étape suivante du zettascale (septième puissance de 1 000, unité juste après l’exascale, c’est-à-dire 1 000 000 000 000 000 000 000 Flops/s).

Denis Trystram, Professeur des universités en informatique, Université Grenoble Alpes (UGA)

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !