OpenAI a dû se rendre à l’évidence : son outil de détection des textes écrits par des systèmes d’intelligence artificielle (IA) est vraiment trop médiocre pour être conservé. L’entreprise américaine, célèbre dans le monde entier pour avoir conçu ChatGPT, a donc décidé de l’abandonner, en attendant de pouvoir inventer un bien meilleur outil.

« À compter du 20 juillet 2023, le classificateur d’IA n’est plus disponible en raison de son faible taux de précision », prévient un message d’avertissement rajouté sur la page de présentation de l’outil. Un changement passé un temps inaperçu, avant que la presse américaine la découvre, à l’image de Decrypt et d’Ars Technica.

Un retrait, donc, mais pas un abandon des recherches. « Nous nous efforçons d’intégrer les commentaires et recherchons actuellement des techniques plus efficaces d’identification de l’origine des textes, et nous nous sommes engagés à développer et à déployer des mécanismes permettant aux utilisateurs de comprendre si le contenu audio ou visuel est généré par l’IA. »

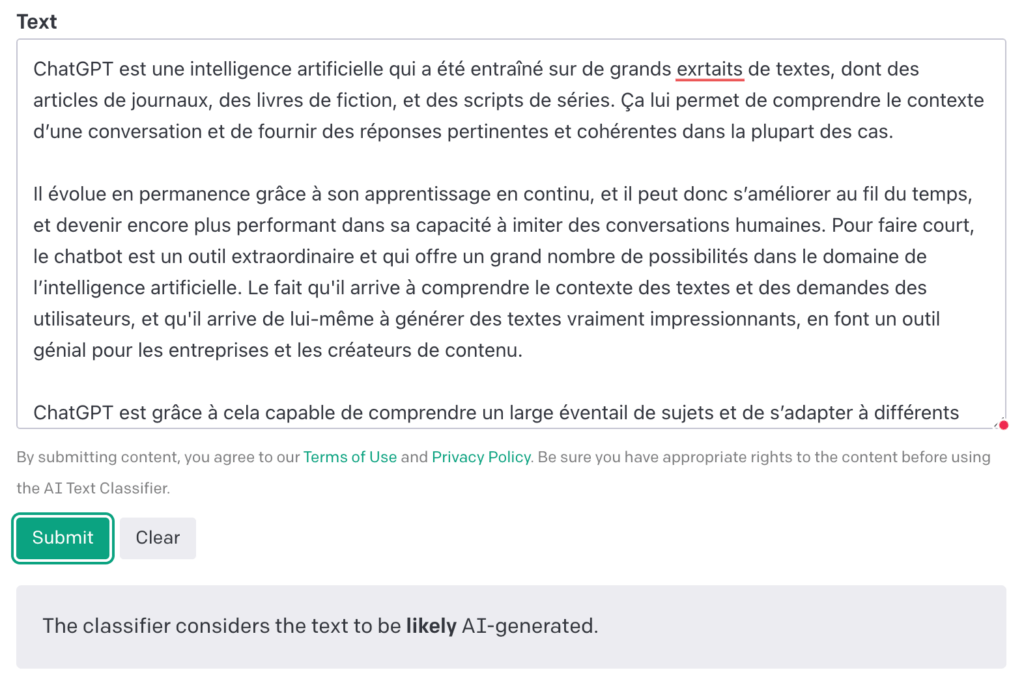

Présenté le 31 janvier, le système a été opérationnel pendant six mois. Dès le début, OpenAI avait conseillé de modérer ses espoirs : Classifier « identifie correctement 26 % des textes écrits par IA comme étant ‘probablement écrit par des IA’ », ce qui est non seulement un taux de détection extrêmement bas, mais aussi hautement incertain — les 26 % ne sont pas garantis.

Peu fiable concernant les textes générés par des IA, Classifier rencontrait aussi des difficultés pour étiqueter correctement les écrits de vraies personnes. Dans presque un cas sur dix (9 %), Classifier se trompait. Autre limite : la langue. Déjà par terrible en anglais, Classifier perdait encore plus en justesse sur des textes dans d’autres langues.

Peut-on vraiment détecter un texte généré avec une IA ?

L’échec d’OpenAI avec Classifier n’est pas de très bon augure : si même une société aussi avancée dans l’intelligence artificielle qu’OpenAI échoue à mettre au point un mécanisme sur lequel on peut compter, quelle autre pointure du secteur le pourra ? Jusqu’à présent, aucun dispositif de détection n’a émergé comme la solution définitive à des contenus artificiels.

Ces outils paraissent toutefois indispensables à l’heure où la tentation de se servir des agents conversationnels, tels ChatGPT, pour rédiger tout et n’importe quoi, a tendance à augmenter. Cette crainte est particulièrement prégnante dans le milieu scolaire, avec des profs qui se demandent si des élèves ne vont pas de plus en plus « tricher » avec leurs devoirs — comme écrire une dissertation à leur place, ou faire un exposé en quelques secondes.

Depuis le début de l’année, on a ainsi vu des établissements scolaires, à New York ou bien à Paris, prendre des dispositions allant du bannissement de ces outils en classe à des mesures disciplinaires en cas de triche. Mais, justement, comment être sûr qu’un travail a été produit par une IA ? C’est toute la réalité de la preuve qui sera difficile à amener, puisque la détection des textes artificiels est, précisément, très incertaine. Toute sanction pourrait être alors contestée.

Repérer les travaux écrits par une IA va d’autant plus devenir délicat que, d’une part, la trajectoire évidente de ces systèmes est d’être de plus en plus efficaces et de formuler des phrases toujours plus convaincantes et naturelles. Et d’autre part, les internautes vont aussi gagner en compétence, en demandant par exemple à l’IA d’être « imparfaite » ou d’imiter un style, comme celui d’un écolier, afin de rendre le résultat encore plus troublant.

Malgré tous ces obstacles, OpenAI ne peut tout simplement pas se retirer de ce champ de recherche, capital pour saisir l’authenticité et la provenance de ce que l’on peut lire, voir ou écouter sur Internet — car ce problème ne touche pas que le texte : ces mêmes enjeux existent aussi dans les vidéos, les images et les sons. On le voit avec les IA générant des images, qui s’améliorent de jour en jour.

OpenAI n’a d’autant pas le choix que les législateurs aux États-Unis et en Europe ne veulent pas que cela vire au far west. C’est le message, en somme, qu’a fait passer Joe Biden lors d’une réunion avec le gratin de l’IA aux États-Unis, en amont d’une mise à jour de la législation. L’Europe aussi va légiférer avec l’AI Act et plaide pour des outils permettant de repérer tout contenu produit par IA.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !