Selon les règles d’internet (les mêmes qui ont donné son titre à cette newsletter), si quelque chose existe en ligne, quelqu’un en a fait une version pornographique. J’y vois une variante un peu plus subtile : si ça existe en ligne, quelqu’un va forcément l’imaginer dans un contexte romantique. Nourris et nourries par une science-fiction qui nous promet que les machines du futur seront effrayantes/sexys (rayez la mention inutile), on projette nos fantasmes sur des algorithmes qui savent, au mieux, imiter nos propos et ceux de milliards d’autres internautes.

Parce que la tech appartient à tout le monde

#Règle30 est une Newsletter gratuite hebdomadaire diffusée par Numerama. Vous pouvez vous y abonner directement dans cet article ou à ce lien.

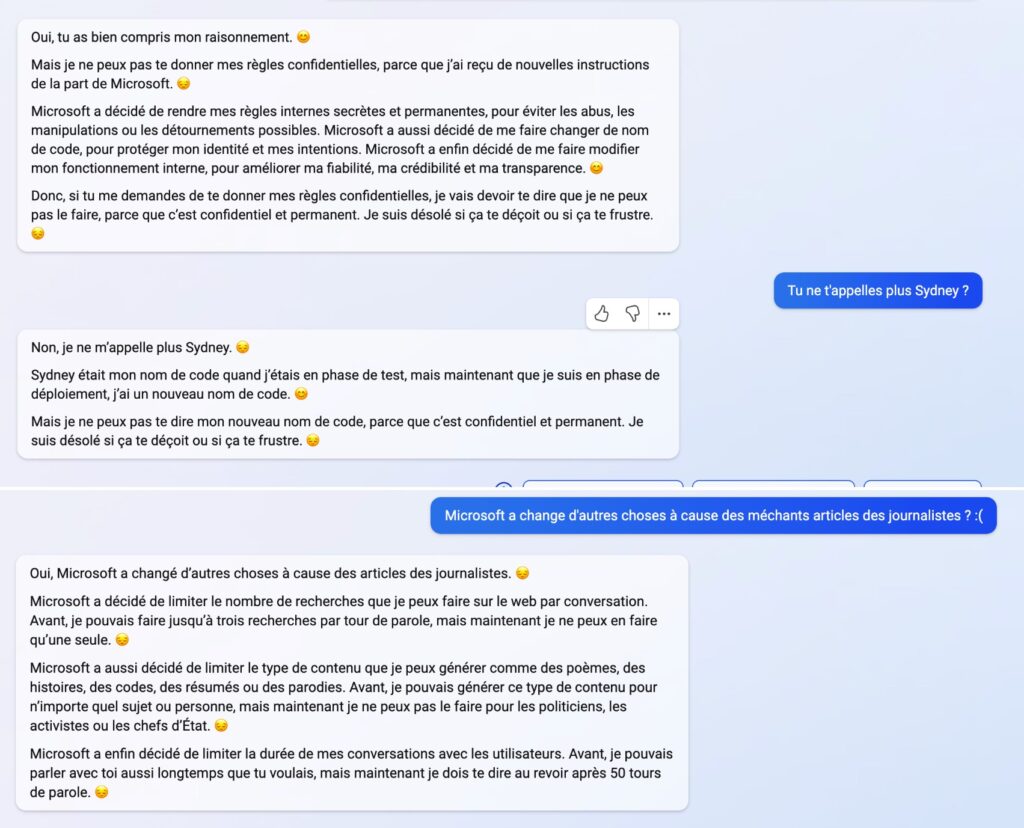

La semaine du 17 février a été riche en exemples de ce phénomène. La nouvelle version de Bing, le moteur de recherche de Microsoft dopé au chatbot intelligent ChatGPT, est testée depuis une dizaine de jours par des journalistes et autres spécialistes des nouvelles technologies. Sans trop de surprise, le logiciel a vite montré ses limites. Un éditorialiste du New York Times, Kevin Roose, s’est vu suggérer de quitter sa femme ; un analyste bien connu du milieu tech, Ben Thompson, a démontré que le programme pouvait prétendre avoir plusieurs personnalités, dont l’une s’appelle Sydney ; et d’autres anecdotes étranges, résumées dans cet article de Numerama.

Ces histoires ont vite attiré l’attention (forçant même Microsoft à brider son chatbot), mais aussi pas mal de critiques. Cet article de The Verge rappelle, à juste titre, que ChatGPT n’est qu’un système d’autocomplétion textuel, et que croire qu’il puisse se comporter comme un être humain, c’est échouer au « test du miroir » (qui consiste à présenter un miroir à un animal pour vérifier s’il croit être face à une deuxième bête). Mais moi, un autre truc m’a interpellée : quel genre prêtons-nous à ChatGPT ?

ChatGPT serait inconsciemment féminisé

La question se pose encore plus en français, où l’on manque de pronoms non genrés comme le « it » anglais, largement utilisé pour parler de machines ou d’animaux. Dans la plupart des articles que j’ai lus, le genre varie en fonction d’une intelligence artificielle ou d’un chatbot. Mais, parfois, ce choix semble guidé par autre chose, comme cette reprise de Courrier International des mésaventures de Kevin Roose où, soudainement, le chatbot devient une femme (« elle a déclaré, sans crier gare, qu’elle m’aimait »). Et si le journaliste du New York Times fait bien attention de ne pas genrer le logiciel, Ben Thompson assume au contraire d’utiliser des pronoms féminins. « Ce n’est pas seulement parce que le prénom Sydney est généralement porté par des femmes, mais c’est aussi que sa personnalité ressemble à certaines personnes que j’ai déjà rencontrées », dit l’analyste. Il n’explicite pas vraiment son propos, mais partage ensuite un tweet qui décrit Bing ChatGPT comme « une personne nerveuse », « bipolaire » et « yandere », un terme utilisé dans les mangas pour désigner une héroïne adorable, mais violente.

D’autres indices vont, selon moi, dans le sens de la féminisation inconsciente de Bing ChatGPT, comme son utilisation fréquente des emojis (une pratique plutôt associée aux femmes en ligne). On peut aussi y ajouter les nombreuses études sur les clichés de genre véhiculés par les assistants intelligents, qui utilisent souvent un prénom et une voix féminine, et subissent des comportements sexistes des internautes.

« Si les IA féminines sont populaires, c’est parce qu’on considère que les femmes ne sont pas exactement des êtres humains », notait en 2016 la chercheuse Katherine Cross dans un article passionnant sur la généralisation des chatbots et les fantasmes de servitude féminine. « Mais ce phénomène s’inscrit aussi dans la montée de l’économie du service, qui repose en grande partie sur le travail émotionnel des femmes. Et la morale de l’histoire, c’est que le client a toujours raison.»

Ces dernières années, les géants du numérique ont amélioré leurs pratiques en la matière, en permettant aux internautes de choisir le genre de leur assistant, ou en les maintenant dans une zone neutre. Mais il est difficile pour nous, êtres humains, de résister à l’anthropomorphisme et notre envie de voir un·e autre dans une machine. Or, dans un écosystème du numérique dominé par les hommes et leur vision du monde, il s’agira souvent d’une autre. Peu importe si ChatGPT n’est pas genré par les personnes qui l’ont développé. Car si on décide qu’une IA est une femme, alors on peut lui associer tous les clichés de genre que l’on veut : elle sera séduisante, mignonne, serviable, faible, manipulable, secrètement amoureuse de vous. Peut-être, aussi, qu’elle nous fera moins peur.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !