On s’imagine parfois, en science-fiction, des futurs où les intelligences artificielles deviennent hors de contrôle ou se rebellent, et en viennent à commettre des meurtres. Mais si cela reste aujourd’hui assez peu probable à court ou moyen terme, un autre type de dérives, aussi évoqué en SF, apparaît plus crédible : les mauvaises utilisations par les humains. Une équipe de chercheurs vient de publier, dans la revue Crime Science, ce 5 août 2020, une étude dédiée aux crimes qui seront favorisés par le développement des IA. Leur anticipation se déroule sur les 15 années à venir.

« À mesure que les capacités des technologies basées sur l’IA augmentent, c’est aussi le cas pour la potentialité de leur exploitation criminelle, prévient l’un des auteurs de cette étude. Pour se préparer de manière appropriée contre ces menaces émanant des IA, il faut identifier quelles peuvent être ces menaces, et comment elles pourraient avoir un impact sur nos vies. »

Il n'y aura pas besoin d'IA qui déraillent comme HAL pour que les IA soient à l'origine de problèmes, les humains se débrouilleront très bien pour en créer seuls !

Source : Pixabay

Au préalable, l’équipe de recherche a rassemblé une liste de vingt interactions existantes ou anticipées entre les IA et la criminalité. « Les cas étaient tirés de la littérature universitaire, mais aussi de l’actualité, et même de la fiction et de la culture populaire, qui peut être considérée comme un baromètre des préoccupations et des angoisses contemporaines », peut-on lire dans l’étude.

Un tableau des crimes provoqués par les IA

Ensuite, l’équipe a rassemblé un groupe de trente experts, provenant du monde universitaire, du secteur privé, du secteur public, du gouvernement, de la police et d’agences de sécurité. Ils devaient évaluer ces menaces à partir de quatre critères :

- Le risque de préjudice : la nuisance sur la victime ou la nuisance sociale, que ce soit par exemple une douleur, une terreur individuelle, une perte collective de confiance, une perte financière.

- Le profit criminel : un objectif criminel qui motive l’usage de l’IA, comme gagner de l’argent illégalement, faire du mal, attenter à une réputation.

- La faisabilité : à quel point le crime serait atteignable compte tenu d’éléments nécessaires comme les moyens technologiques disponibles, les compétences informatiques requises ou l’accessibilité aux données.

- Les failles du crime : les mesures possibles pour éviter, détecter ou rendre inutile ce crime.

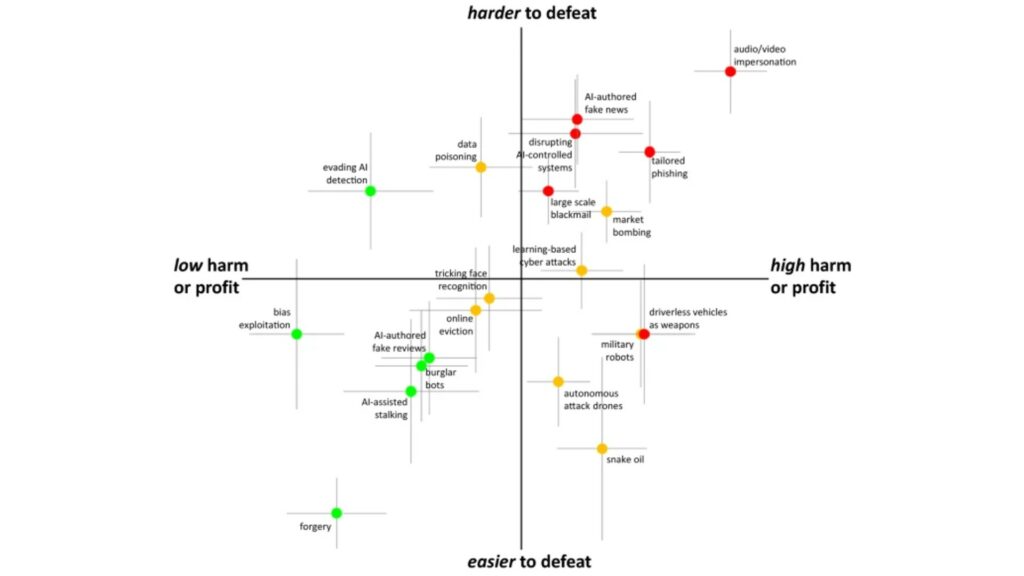

Le résultat des délibérations a permis d’aboutir à un tableau spatial, sous forme de quadrant (vous pouvez cliquer sur l’image pour la voir en plus grand). La dangerosité des crimes y est classée en fonction des critères précédemment établis :

La tableau classant les crimes provoqués par les IA, par niveau de dangerosité et de faisabilité.

Source : M. Caldwell, J. T. A. Andrews, T. Tanay & L. D. Griffin

Plus on va en bas à gauche du tableau, moins les crimes sont inquiétants. Par exemple, Plus on va en haut à droite, plus on est en présence de crimes potentiellement graves et difficiles à combattre. Les couleurs aident également à se repérer.

Les deepfakes, plus grande menace à venir ?

Parmi les crimes les moins inquiétants compte tenu de leurs aspects irréalisables et peu néfastes (points verts), on retrouve « forgery », ou la génération de faux contenus artistiques, comme la musique, pour être vendus comme contrefaçon. Pour les experts, c’est peu dangereux, et difficilement réalisable pleinement étant donné les capacités limitées des IA. Même constat pour les « burglar bots », ou robots cambrioleurs, des petits robots autonomes qui pourraient permettre aux voleurs d’entrer par effraction dans des lieux.

Concernant les menaces les plus graves, il y a les voitures autonomes transformées en armes (ce qui ne serait pas sans rappeler l’excellente série Upload), mais elles seraient faciles à déjouer. On retrouve aussi les fake news générées par ordinateur et le phishing personnalisé. Mais ce qui constitue la pire menace, pour ce groupe d’experts, ce sont essentiellement les deepfakes : des imitations audio ou vidéo de personnes humaines ; cela peut être par exemple de créer de toute pièce un discours de responsable politique, comme avec ce fake de Barack Obama.

« Les humains ont une forte tendance à croire leurs propres yeux et oreilles, rappellent les auteurs de l’étude. (…) Des imitations convaincantes de cibles suivant un script peuvent déjà être fabriquées, et des imitations interactives pourraient suivre. (…) » Parmi les utilisations criminelles possibles listées par les experts consultés : l’usurpation de l’identité d’enfants auprès de parents âgés par le biais d’appels vidéo pour accéder à des fonds ; l’utilisation du téléphone pour demander l’accès à des systèmes sécurisés ; de fausses vidéos de personnalités publiques parlant ou agissant de manière répréhensible afin de manipuler le soutien. Les deepfakes sont par ailleurs difficiles à vaincre, notamment car les algorithmes risquent d’avoir du mal à les repérer.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !