Mise à jour, après l’annonce officielle du 21 août : Deux jours après la publication du modèle, DeepSeek confirme avoir déployé son nouveau modèle DeepSeek-V3.1.

On apprend notamment que V3.1 remplace à la fois V3 et R1, puisqu’il dispose d’un mode « Think » et d’un mode « Non-Think ». Une approche similaire à celle d’OpenAI avec GPT-5, mais DeepSeep promet des réponses beaucoup plus rapides et moins coûteuses. DeepSeek-V3.1 est à la fois plus performant que DeepSeek-V3 et que DeepSeek-R1.

Article original, publié le 20 août : Assez discret depuis plusieurs semaines, DeepSeek, le spécialiste chinois de l’intelligence artificielle, a fait son grand retour le 19 août avec DeepSeek-V3.1, une évolution de son modèle de langage DeepSeek-V3.

Doté de 685 milliards de paramètres, contre 671 milliards pour V3, DeepSeek-V3.1 repose toujours sur une architecture Mixture-of-Experts, qui lui permet d’optimiser son efficacité en se concentrant sur des connaissances précises adaptées à la requête (c’est une des forces de DeepSeek, qui a besoin de moins de ressources que ses concurrents américains). Publié sous licence MIT, il peut dès aujourd’hui être téléchargé et exécuté localement sur un appareil compatible. Il remplace aussi DeepSeek-R1, l’impressionnant modèle de raisonnement qui avait révélé DeepSeek au grand jour.

Quoi de neuf avec DeepSeek-V3.1 ?

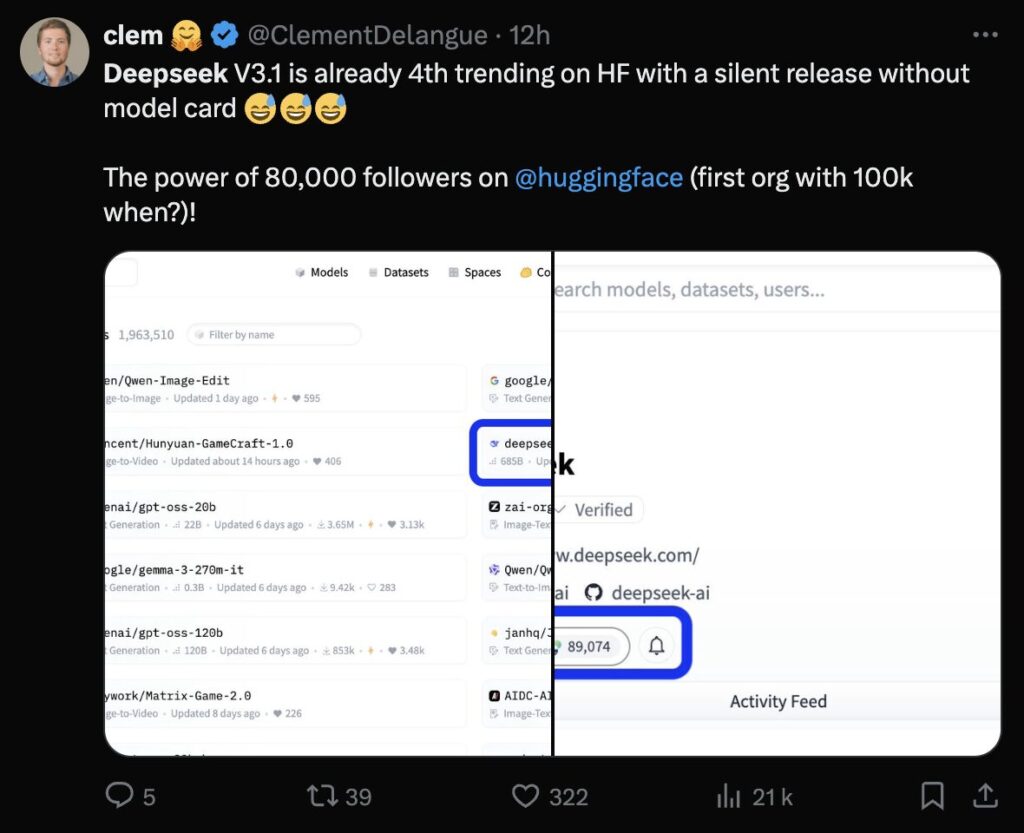

Adepte des lancements discrets, DeepSeek n’a pas publié de communiqué officiel sur l’arrivée de son nouveau modèle. L’entreprise chinoise s’est contentée de mettre en ligne DeepSeek-V3.1 sur différents sites, comme HuggingFace, sans publier le moindre document de recherche (ou model card). Ce sont les internautes qui découvrent progressivement les nouvelles capacités du modèle : l’entreprise ne dit rien.

Selon les premiers tests, qui restent encore à confirmer, DeepSeek-V3.1 s’en sortirait formidablement bien pour un modèle « classique » (c’est-à-dire non conçu pour le raisonnement chain-of-thought, mais capable d’un raisonnement général). Le LLM serait plus performant que certains modèles plus avancés comme Claude 4 Opus dans certains benchmarks, malgré un coût d’utilisation très faible. DeepSeek réitérerait alors son coup du début d’année, à savoir faire mieux que les Américains avec beaucoup moins d’entraînements et de puissance. Le chercheur Andrew Christianson estime son coût d’utilisation 68 fois inférieur à celui de Claude Opus 4, pour des résultats équivalents.

Au vu des premiers résultats partagés en ligne, DeepSeek pourrait reprendre la couronne du meilleur modèle open weight, devant le nouveau gpt-oss d’OpenAI. Le modèle est capable de traiter des demandes avec 128 000 tokens de contexte, ce qui est plus que dans les précédentes itérations. Il pourrait séduire de nombreux développeurs en quête d’une intégration d’un LLM à petit prix.

Quid d’un successeur au modèle DeepSeek-R1 ? Comme le fait remarquer le journaliste Poe Zhao, l’option n’existe plus sur le site de DeepSeek, qui permet d’interagir avec le modèle sans le télécharger. Cela laisse présager l’arrivée imminente de DeepSeek-R2… ou l’abandon de cette catégorie. DeepSeek pourrait avoir appris qu’il s’agit d’un usage niche (mise à jour : DeepSeek-V3.1 remplace en réalité DeepSeek-R1, avec son mode think).

Avec DeepSeek-V3.1, sans oublier les modèles Qwen (Alibaba) et Ernie (Baidu), la Chine rappelle aux Américains qu’elle ne doit pas être sous-estimée sur le terrain de l’IA générative. L’Europe, avec le français Mistral, dispose aussi d’une excellence dans la conception de petits modèles. La guerre des modèles, particulièrement ouverts, n’a pas fini de faire parler. En ce qui concerne les risques de censure, ils existent avec les modèles chinois. Mais comme le modèle peut être exécuté localement, un développeur peut parfaitement le libérer de ses contraintes.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !