Les États-Unis ont une passion pour la prison. Le pays a le taux d’incarcération le plus élevé au monde, avec 743 prisonniers pour 100 000 habitants (contre 102 en France), et l’on estime que les prisonniers américains représentent près d’un quart (23 %) de l’ensemble de la population carcérale mondiale ! Selon les statistiques officielles, plus des deux tiers des personnes incarcérées aux États-Unis sont des Afro-Américains, alors qu’ils ne représentent que 13 % de la population.

Mais quand il s’agit de libérer un individu ou de lui faire bénéficier d’une peine alternative, une part importante de la décision est de plus en plus mise entre les mains d’un algorithme secret, qui serait lui-même coupable de racisme. Le magazine ProPublica a en effet publié une longue enquête sur un logiciel utilisé par l’administration judiciaire dans près d’une dizaine d’États aux États-Unis (Arizona, Colorado, Delaware, Kentucky, Louisiane, Oklahoma, Virginie, Washington et Wisconsin), vendu par la société privée Northpointe, dont le slogan est « Faire avancer la justice. Embrasser la communauté ».

Avec ce logiciel, les juges qui doivent décider d’une remise en liberté peuvent consulter une « note de risque » de 1 à 10, calculée selon les réponses à 137 questions complétées par l’administration pénitentiaire ou par le prisonnier lui-même. La note permet d’évaluer le risque de commission d’un délit ou d’un crime de toute nature après la libération, ou le risque de récidive. La tentation est grande pour les juges, qui le feraient de plus en plus, de se reposer largement sur ce logiciel « scientifique » pour décider de l’avenir de l’individu.

Un logiciel raciste par préjugés ?

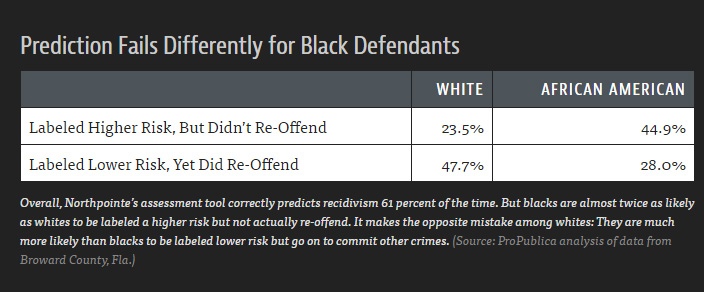

Or les journalistes ont découvert que ce logiciel, inventé en 1989 par un professeur de statistiques et le gestionnaire d’un programme pénitencier, n’avait jamais fait l’objet d’une évaluation sérieuse de son efficacité, et surtout de son éventuel effet discriminatoire. Pourtant, en examinant les notes de risques attribuées à plus de 7 000 individus dans un conté de Floride en 2013 et 2014, ProPublica a remarqué que le logiciel était tout sauf fiable, et tout sauf impartial :

- 20 % des personnes notées comme « à risque » de commettre des crimes violents en ont effectivement commis un dans les années suivantes ;

- Quand l’individu est noir, le logiciel a deux fois plus tendance à juger à tort que la personne est à risque ;

- Quand l’individu est blanc, le logiciel a davantage tendance à juger à tort que la personne n’est pas à risque.

L’enquête de ProPublica ne va pas jusqu’à accuser NorthPointe de racisme volontaire, d’autant que la « race » (selon la terminologie américaine) ou la couleur de peau ne fait pas partie des 137 questions sur lesquelles l’algorithme se base. Mais ce dernier est un secret industriel bien gardé, et les journalistes se demandent si certains facteurs de risque n’ont pas un poids excessif dans l’algorithme, alors qu’ils sont sociologiquement plus fréquents chez les Noirs pour des raisons historiques de ségrégation sociale (pauvreté, absence de diplôme, cercle d’amis qui incluent des vendeurs ou consommateurs de drogues, etc.).

Le logiciel serait donc indirectement raciste, et pourrait conforter les juges dans leur propre racisme, voire les conduire à un racisme inconscient qui n’était pas le leur. Il est en effet possible que certains juges ne remettent pas en cause leurs préjugés erronés sur le risque de récidive ou de crime plus élevés chez les Noirs, en voyant une confirmation de leur racisme par un logiciel « scientifique » qui est pourtant lui-même biaisé.

Nouveauté : Découvrez

La meilleure expérience de Numerama, sans publicité,

+ riche,

+ zen,

+ exclusive.

Vous voulez tout savoir sur la mobilité de demain, des voitures électriques aux VAE ? Abonnez-vous dès maintenant à notre newsletter Watt Else !