Le Département Recherche, Etudes et Veille (DREV) de l'Hadopi a publié lundi soir son programme de travail (.pdf) pour la mise en oeuvre de la mission d'observation que lui a confiée le législateur. A cette occasion, le DREV a confirmé qu'elle souhaitait "étudier le trafic d'un réseau de grande taille" pour analyser les flux de données et voir précisément, grâce aux données réelles des internautes, quelles sont leurs pratiques sur Internet.

Le Département Recherche, Etudes et Veille (DREV) de l'Hadopi a publié lundi soir son programme de travail (.pdf) pour la mise en oeuvre de la mission d'observation que lui a confiée le législateur. A cette occasion, le DREV a confirmé qu'elle souhaitait "étudier le trafic d'un réseau de grande taille" pour analyser les flux de données et voir précisément, grâce aux données réelles des internautes, quelles sont leurs pratiques sur Internet.

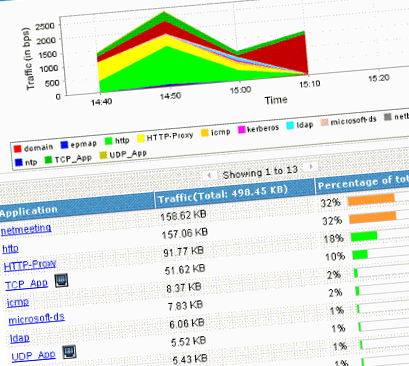

- Adresse IP source

- Adresse IP de destination

- Protocole réseau

- Port source et port de destination

- Durée du flux

- Taille en octets

- Débit en bit par seconde

- Champs Tos (DSCP)

- etc.

"Le DREV se propose de travailler à une méthode d’analyse des données NetFlow permettant de qualifier les usages des internautes utilisant le réseau d’où sont issues les données NetFlow. (exemple : mailing, téléchargement, etc.)", et "de quantifier les usages des internautes utilisant le réseau d’où sont issues les données NetFlow. (quel volume de données par exemple)", explique le document. L'Hadopi veut pouvoir analyser les flux réseaux en temps réel, grâce à des méthodes de reconnaissance heuristique des usages qui l'intéressent.

Mais "cette étude, pour être la plus pertinente possible, devra être menée idéalement sur un nombre important de réseaux", prévient-elle, en expliquant que "la qualité de données NetFlow à extraire serait fixée par un ratio défini lors de l'étude de faisabilité".

Elle n'a pas précisés si des fournisseurs d'accès à internet avaient déjà accepté de donner accès à tout ou partie de leurs données NetFlow. Mais selon nos informations, au moins un FAI aurait déjà entamé des discussions.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !