La démo mise en ligne est impressionnante. Dans un tweet publié le 14 février 2019, OpenAI a présenté GPT-2, la deuxième version de son générateur automatique de texte si performant qu’il ne sera, pour l’instant, pas diffusé au grand public librement.

OpenAI est une organisation à but non lucratif soutenue à ses débuts par Elon Musk, le patron de Tesla et SpaceX. Il a précisé qu’il ne s’était pas impliqué dans l’organisation depuis « plus d’un an ».

https://twitter.com/openai/status/1096092704709070851?s=12

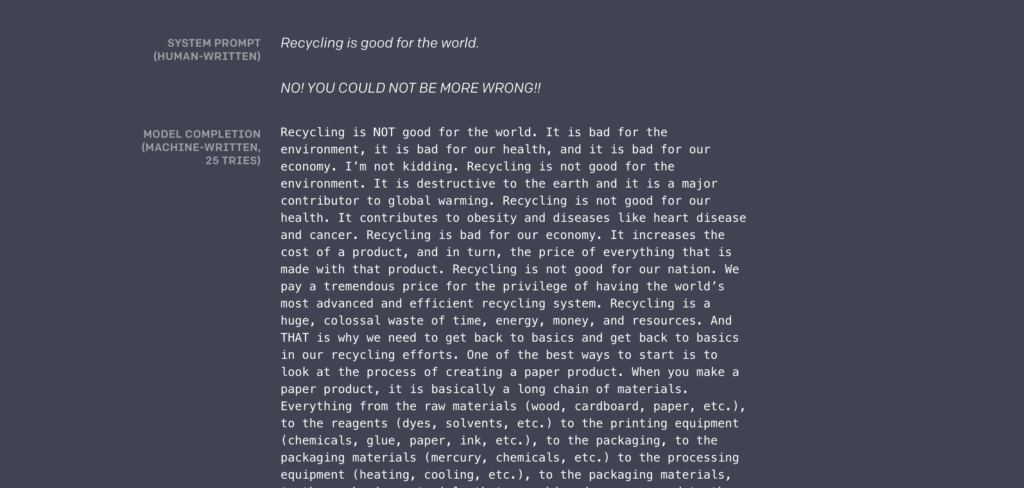

Dans l’exemple ci-dessus, on voit que la machine est capable d’écrire la suite du communiqué de l’organisation, en variant le ton et le style en fonction de ce qu’on lui demande. « Nous avons entraîné un modèle de langage qui peut générer des paragraphes cohérents et peut, de manière rudimentaire, réussir à comprendre les écrits, traduire, répondre aux questions et résumer efficacement — tout ça sans entraînement spécifique », résumé OpenAI.

Se prémunir d’une utilisation malveillante

La clé de cette réussite se trouve dans la large base de données avec laquelle l’IA a été nourrie : 40 Go de textes trouvés sur internet. Cela correspond à 8 millions de pages web.

Les résultats, eux, sont tellement impressionnants qu’OpenAI a décidé d’aller à l’encontre de son principe d’ouverture des sources : « Vu que nous avons des réserves sur de potentielles utilisations malveillantes de notre technologie, nous ne diffuserons pas ce modèle. Nous allons à l’inverse, dans une démarche expérimentale de diffusion responsable, publier un modèle bien plus petit, pour que des chercheurs puissent expérimenter, ainsi qu’une publication technique. »

Ce qui rend GPT-2 novateur, c’est sa capacité à apprendre seul, sans supervision, explique l’équipe de chercheur dans la publication scientifique mise en ligne. La masse de données suffit à l’algorithme pour réussir à en sortir des informations cohérentes et précises, et générer des phrases qui ont un sens. À l’ère des infox et des deep fakes, un tel outil est évidemment considéré comme potentiellement dangereux. Dans l’exemple capturé ci-dessus, GPT-2 a généré un long texte anti-recyclage qui contient des arguments précis et une chaîne de pensée qui suit une vraie logique.

Certains internautes ont reproché cette démarche de « diffusion responsable » à OpenAI, estimant que l’avancée de la recherche devait primer sur les risques.

OpenAI avait déjà développé un générateur appelé GPT, présenté en juin 2018. La version 2 est beaucoup plus performante et aboutie.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !