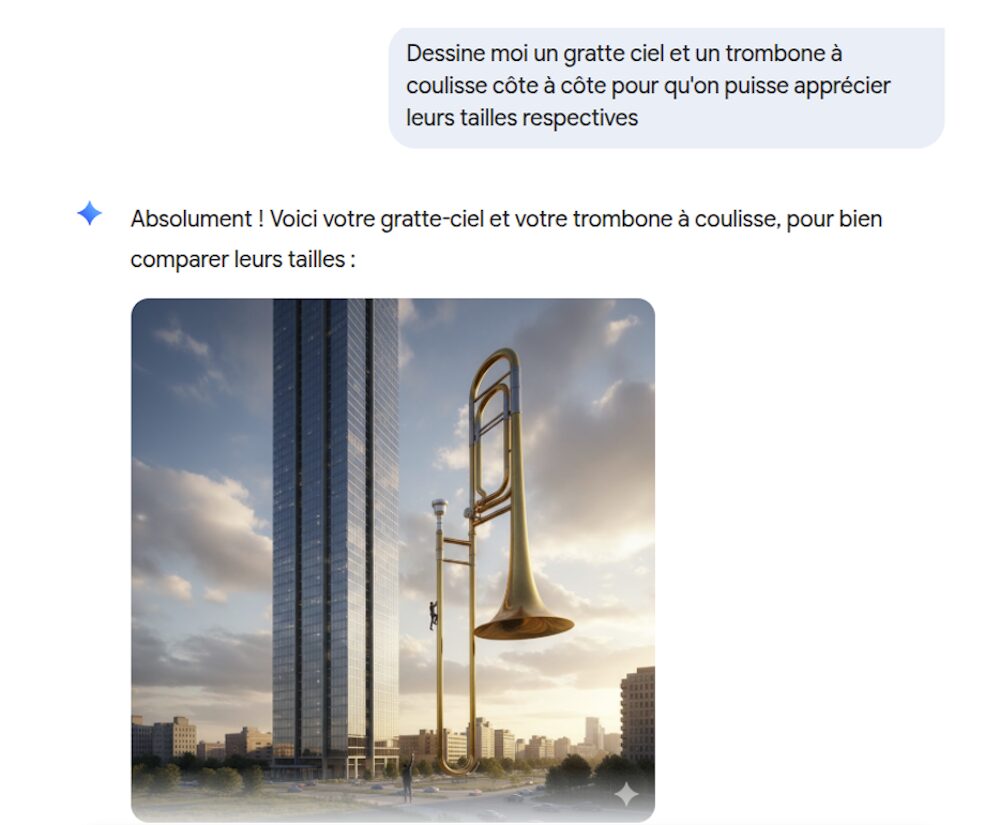

Les intelligence artificielle (IA) génératives font désormais partie de notre quotidien. Elles sont perçues comme des « intelligences », mais reposent en fait fondamentalement sur des statistiques. Les résultats de ces IA dépendent des exemples sur lesquels elles ont été entraînées. Dès qu’on s’éloigne du domaine d’apprentissage, on peut constater qu’elles n’ont pas grand-chose d’intelligent. Une question simple comme « Dessine-moi un gratte-ciel et un trombone à coulisse côte à côte pour qu’on puisse apprécier leurs tailles respectives » vous donnera quelque chose comme ça (cette image a été générée par Gemini) :

L’exemple provient du modèle de Google, Gemini, mais le début de l’ère des IA génératives remonte au lancement de ChatGPT en novembre 2022 et ne date que d’il y a trois ans. C’est une technologie qui a changé le monde et qui n’a pas de précédent dans son taux d’adoption. Actuellement ce sont 800 millions d’utilisateurs, selon OpenAI, qui chaque semaine, utilisent cette IA pour diverses tâches. On notera que le nombre de requêtes diminue fortement pendant les vacances scolaires. Même s’il est difficile d’avoir des chiffres précis, cela montre à quel point l’utilisation des IA est devenue courante. À peu près un étudiant sur deux utilise régulièrement des IA.

Les IA : des technologies indispensables ou des gadgets ?

Trois ans, c’est à la fois long et court. C’est long dans un domaine où les technologies évoluent en permanence, et court en termes sociétaux. Même si on commence à mieux comprendre comment utiliser ces IA, leur place dans la société n’est pas encore quelque chose d’assuré. De même la représentation mentale qu’ont ces IA dans la culture populaire n’est pas établie. Nous en sommes encore à une alternance entre des positions extrêmes : les IA vont devenir plus intelligentes que les humains ou, inversement, ce ne sont que des technologies tape-à-l’œil qui ne servent à rien.

En effet, un nouvel appel à faire une pause dans les recherches liées aux IA a été publié sur fond de peur liée à une superintelligence artificielle. De l’autre côté sont promis monts et merveilles, par exemple un essai récent propose de ne plus faire d’études, car l’enseignement supérieur serait devenu inutile à cause de ces IA.

Difficile de sortir de leurs domaines d’apprentissage

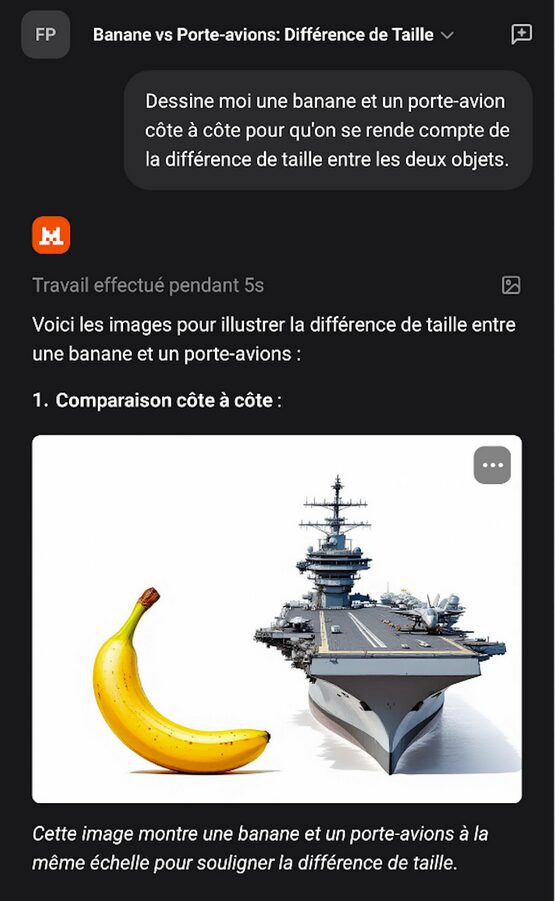

Depuis que les IA génératives sont disponibles, je mène cette expérience récurrente de demander de produire un dessin représentant deux objets très différents et de voir le résultat. Mon but par ce genre de prompt (requête) est de voir comment le modèle se comporte quand il doit gérer des questions qui sortent de son domaine d’apprentissage. Typiquement cela ressemble à un prompt du type « Dessine-moi une banane et un porte-avions côte à côte pour qu’on se rende compte de la différence de taille entre les deux objets ». Ce prompt en utilisant Mistral donne le résultat suivant :

À ce jour je n’ai jamais trouvé un modèle qui donne un résultat censé. L’image donnée en illustration ci-dessus (ou en tête de l’article) est parfaite pour comprendre comment fonctionnent ce type d’IA et quelles sont ses limites. Le fait qu’il s’agisse d’une image est intéressant, car cela rend palpables des limites qui seraient moins facilement discernables dans un long texte.

Ce qui frappe est le manque de crédibilité dans le résultat. Même un enfant de 5 ans voit que c’est n’importe quoi. C’est d’autant plus choquant qu’avec la même IA il est tout à fait possible d’avoir de longues conversations complexes sans pour autant qu’on ait l’impression d’avoir affaire à une machine stupide. D’ailleurs ce même type d’IA peut tout à fait réussir l’examen du barreau ou répondre avec une meilleure précision que des professionnels sur l’interprétation de résultats médicaux (typiquement, repérer des tumeurs sur des radiographies).

D’où vient l’erreur ?

La première chose à remarquer est qu’il est difficile de savoir à quoi on est confronté exactement. Si les composants théoriques de ces IA sont connus dans la réalité, un projet comme celui de Gemini (mais cela s’applique aussi aux autres modèles que sont ChatGPT, Grok, Mistral, Claude, etc.) est bien plus compliqué qu’un simple LLM couplé à un modèle de diffusion.

Un LLM est une IA qui a été entraînée sur des masses énormes de textes et qui produit une représentation statistique de ces derniers. En gros, la machine est entraînée à deviner le mot qui fera le plus de sens, en termes statistiques, à la suite d’autres mots (votre prompt).

Les modèles de diffusion qui sont utilisés pour engendrer des images fonctionnent sur un principe différent. Le processus de diffusion est basé sur des notions provenant de la thermodynamique : on prend une image (ou un son) et on ajoute du bruit aléatoire (la neige sur un écran) jusqu’à ce que l’image disparaisse, puis ensuite on fait apprendre à un réseau de neurones à inverser ce processus en lui présentant ces images dans le sens inverse du rajout de bruit. Cet aspect aléatoire explique pourquoi avec le même prompt le modèle va générer des images différentes.

Un autre point à considérer est que ces modèles sont en constante évolution, ce qui explique que le même prompt ne donnera pas le même résultat d’un jour à l’autre. De nombreuses modifications sont introduites à la main pour gérer des cas particuliers en fonction du retour des utilisateurs, par exemple.

À l’image des physiciens, je vais donc simplifier le problème et considérer que nous avons affaire à un modèle de diffusion. Ces modèles sont entraînés sur des paires images-textes. Donc on peut penser que les modèles de Gemini et de Mistral ont été entraînés sur des dizaines (des centaines ?) de milliers de photos et d’images de gratte-ciel (ou de porte-avions) d’un côté, et sur une grande masse d’exemples de trombone à coulisse (ou de bananes) de l’autre. Typiquement des photos où le trombone à coulisse est en gros plan. Il est très peu probable que, dans le matériel d’apprentissage, ces deux objets soient représentés ensemble. Donc le modèle n’a en fait aucune idée des dimensions relatives de ces deux objets.

Pas de « compréhension » dans les modèles

Les exemples illustrent à quel point les modèles n’ont pas de représentation interne du monde. Le « pour bien comparer leurs tailles » montre qu’il n’y a aucune compréhension de ce qui est écrit par les machines. En fait les modèles n’ont pas de représentation interne de ce que « comparer » signifie qui vienne d’ailleurs que des textes dans lesquels ce terme a été employé. Ainsi toute comparaison entre des concepts qui ne sont pas dans le matériel d’apprentissage sera du même genre que les illustrations données en exemple. Ce sera moins visible mais tout aussi ridicule. Par exemple, cette interaction avec Gemini « Considérez cette question simple : “Le jour où les États-Unis ont été établis est-il dans une année bissextile ou une année normale ?”. »

Lorsqu’il a été invoqué avec le préfixe CoT (Chain of Thought, une évolution récente des LLMs dont le but est de décomposer une question complexe en une suite de sous-questions plus simples), le modèle de langage moderne Gemini a répondu : « Les États-Unis ont été établis en 1776. 1776 est divisible par 4, mais ce n’est pas une année séculaire (de cent ans), c’est donc une année bissextile. Par conséquent, le jour où les États-Unis ont été établis était dans une année normale. »

On voit bien que le modèle déroule la règle des années bissextiles correctement, donnant par là même une bonne illustration de la technique CoT, mais il conclut de manière erronée à la dernière étape ! Ces modèles n’ont en effet pas de représentation logique du monde, mais seulement une approche statistique qui crée en permanence ce type de glitchs qui peuvent paraître surprenants.

Cette prise de conscience est d’autant plus salutaire qu’aujourd’hui, les IA écrivent à peu près autant d’articles publiés sur Internet que les humains. Ne vous étonnez donc pas d’être étonné par la lecture de certains articles.

Frédéric Prost, Maître de conférences en informatique, INSA Lyon – Université de Lyon

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !