OpenAI a-t-il fait une découverte révolutionnaire sur le point de changer l’humanité à tout jamais ? Selon des informations recueillies par Reuters, qui n’a étrangement pas pu les vérifier, plusieurs chercheurs auraient alerté le conseil d’administration d’OpenAI du développement d’un projet dangereux, supervisé par Sam Altman. C’est ce qui aurait causé son renvoi ultra-médiatisé le 17 novembre, avant qu’il ne revienne le 21 novembre. Une théorie partagée massivement par Elon Musk et son entourage, qui tentent depuis plusieurs jours de diffuser des rumeurs sur Sam Altman.

Concrètement, ces chercheurs reprocheraient à Sam Altman d’avoir autorisé le développement d’une IA capable de « raisonner », pour notamment résoudre des problèmes mathématiques (alors que les IA génératives sont seulement fortes avec les mots aujourd’hui). Ce projet, qu’OpenAI appelle Q* (pour Q Star), existe bel et bien. L’entreprise l’a confirmé, même si rien ne dit qu’il a provoqué le licenciement de Sam Altman, surtout quand on sait que le conseil d’administration n’a toujours pas su expliquer les raisons de son renvoi.

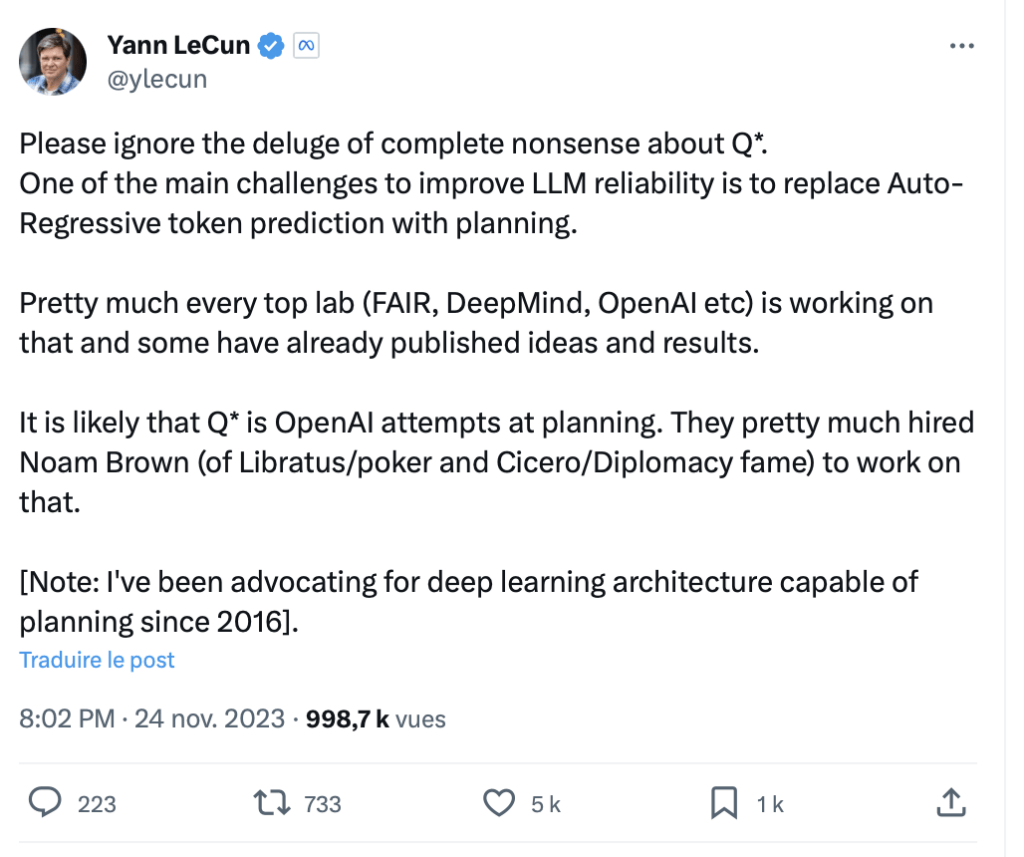

Q* est-t-il dangereux ? Pour Yann LeCun, le Français à la tête de l’IA chez Meta, toutes les informations à son sujet sont « un déluge d’absurdités ». Q* ne serait qu’un projet comme un autre, après des décennies de recherche sur ce sujet.

Apprendre à une IA à anticiper ses réponses, c’est juste de l’évolution

Concrètement, Yann LeCun dit :

« Veuillez ignorer le déluge d’absurdités au sujet de Q*.

L’un des principaux défis pour améliorer la fiabilité des modèles de langage est de remplacer la prédiction auto-régressive des jetons par de la planification.

Pratiquement tous les grands laboratoires (FAIR, DeepMind, OpenAI, etc.) travaillent sur ce sujet et certains ont déjà publié des idées et des résultats.

Il est probable que Q* soit la tentative de planification d’OpenAI. Ils ont globalement embauché Noam Brown (de Libratus/poker et de Cicero/Diplomacy) pour travailler sur ce sujet. »

Qu’est-ce que cela signifie ? Aujourd’hui, les modèles de langage comme GPT-4 utilisent une méthode auto-régressive pour générer du texte, en prédisant un token (un mot ou un caractère) un par un, en se basant sur les tokens précédents. Cela limite leurs capacités, puisqu’ils ne peuvent pas résoudre plusieurs tâches simultanément.

Un jour peut-être, avec la planification, un modèle de langage pourrait suivre des objectifs à plus long terme, pour ne pas réagir token par token. Ses réponses deviendraient cohérentes, avec sans doute la possibilité de résoudre des problèmes mathématiques.

Yann LeCun, qui milite depuis 2016 pour des recherches en la matière, indique que les recherches sur la planification ont commencé dans les années 1980 et doute du fait qu’OpenAI a vraiment pris de l’avance sur le sujet. Si Q* est bien le modèle de langage expérimental de l’entreprise de Sam Altman sur la planification, il n’est probablement pas meilleur que celui des autres laboratoires. Et même s’il l’était, cela ne lui permettra pas de penser comme un humain. Il serait juste plus pertinent sur certaines requêtes.

La peur habituelle de l’intelligence artificielle

Pourquoi y a-t-il un aussi gros emballement autour de Q* ? C’est l’effet Terminator. Les gens aiment se faire peur avec l’IA, en oubliant souvent que c’est son rôle de se faire passer pour plus intelligente qu’elle ne l’est vraiment. On se souvient notamment du chercheur de Google convaincu que son IA l’aimait, qui s’est probablement lui-même fait avoir.

Même si Q* aboutit un jour à un ChatGPT amélioré, capable d’aller beaucoup plus loin que la version actuelle, il n’en fera pas une AGI, soit une intelligence artificielle consciente. Yann LeCun fait partie des personnes qui alertent régulièrement sur la folie autour de cette idée, qui lui semble techniquement impossible (d’autant plus qu’il n’existe aucune définition scientifique de l’AGI, ce n’est qu’un fantasme). Pourtant, l’humanité continue de la craindre et de la voir partout.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !