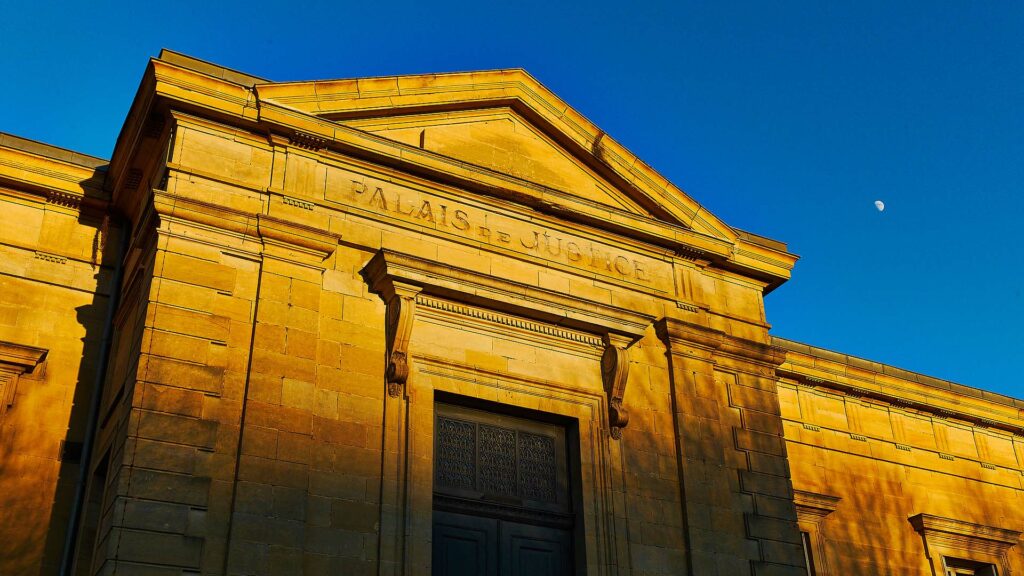

Les startups françaises sont sur le pied de guerre. Avec la loi Lemaire, il est prévu que l’intégralité des décisions de justice soit à l’avenir mise en ligne. Et d’ici fin avril 2021, le ministère de la Justice devrait fixer la date à partir de laquelle elles seront publiées. Une nouveauté qui pourrait tout changer. Ces décisions de justice sont, en effet, autant de trésors de données que les intelligences artificielles pourront étudier afin de progresser. Convaincus que les IA peuvent améliorer le monde judiciaire, plusieurs organismes privés et publics travaillent d’ailleurs déjà sur la question.

En France, DataJust s’apprête, par exemple, à lancer un outil de modélisation du préjudice corporel. Et la société Case Law Analytics établit des probabilités de jugement en nourrissant son algorithme avec de la jurisprudence. « On alimente le modèle mathématique avec un grand nombre de décisions de justice dans un domaine donné, afin qu’il apprenne les diverses façons de raisonner des magistrats. Ensuite, sur une nouvelle affaire, il pourra calculer les réponses possibles des juridictions », décrit son président Jacques Lévy Véhel, également directeur de recherche à l’Institut national de recherche en sciences et technologies du numérique (Inria).

L’Estonie a, quant à elle, sauté le pas depuis longtemps : les autorités ont accepté depuis deux ans que des robots juges puissent trancher sur des litiges mineurs.

Si les avocats rêvent déjà de pouvoir, grâce à ces outils, promettre à leurs clients des stratégies ayant 80% de chances de fonctionner, l’intérêt le plus évident de l’automatisation est de désengorger les tribunaux — rien qu’en 2018, les juridictions civiles et commerciales ont accueilli 2 255 091 nouvelles affaires. Cela permettrait aux juges de passer plus de temps sur les affaires les plus complexes. Des intelligences artificielles juridiques se montreraient, du reste, peut-être plus impartiales que les humains de chair et d’os.

Des robots juges plus neutres que les humains ?

Le philosophe américain Jérôme Franck plaisantait déjà sur ce point, au début du XXe : « La justice dépend de ce que le juge a mangé au petit déjeuner ». Mais depuis, les sciences du comportement ont prouvé que la blague n’en était pas une. Des facteurs bien plus larges que le domaine strict du droit et de la justice influencent les décisions des magistrats. Le moment de la décision, par exemple. En analysant plus de 1000 arrêts, une étude israélienne de 2011 a remarqué qu’en début d’audience, des condamnés demandant un aménagement de peine ont 65 % de chances, en moyenne, d’obtenir un oui. En fin d’audience, le pourcentage tombe à zéro, pour remonter à 65 %… après la pause déjeuner.

Les Suédois ont, quant à eux, mis en exergue l’influence des convictions politiques dans l’issue des procès. Un étranger a 26% de risque supplémentaire de se voir condamner, si un juré est proche de l’extrême droite. Un auteur de violence conjugale aura 15% de risque de condamnation supplémentaire, si un juré est proche des Verts, parti particulièrement féministe en Suède. La liste des influences parasites observées en justice est bien longue : températures de la pièce, résultats récents de l’équipe de foot nationale, physique de l’accusé ou de l’accusée, etc.

Une intelligence artificielle raciste

Les Américains, qui ont commencé à flirter avec la justice prédictive voici plusieurs années, commencent toutefois à revenir du fantasme de l’IA objective. En 2015, a vu le jour le logiciel COMPAS. Plusieurs tribunaux se sont mis à utiliser cet outil prédictif pour décider du sort des prisonniers : détention provisoire, libération conditionnelle, etc. On a finalement découvert que l’outil ne prédisait pas mieux la récidive que des humains. On a également réalisé que cette IA était… raciste.

En prédisant la probabilité d’une future activité criminelle, COMPAS s’appuie sur des événements passés, une arrestation par exemple. Or, des observations sur les pratiques policières montrent que les personnes issues de la diversité ont, à crime égal, bien plus de risques d’être arrêtées que les personnes blanches, aux États-Unis comme en France. Voilà pourquoi les IA sont parfois porteuses de biais : elles reproduisent souvent ceux des humains.

Un des axes de recherche est donc de tenter de supprimer les biais des intelligences artificielles. À San Francisco, une IA réductrice de biais censure automatiquement les informations susceptibles d’identifier la couleur de peau d’un suspect dans les rapports de police. Certains pays comme les Pays-Bas envisagent des procès en réalité virtuelle, où les magistrats ne voient qu’un avatar de l’accusé. Un tel dispositif réduirait l’influence d’éventuels préjugés liés au genre ou à la couleur de la peau, dans la décision. En 2018, des chercheurs californiens ont simulé des procès en réalité virtuelle. D’après ces expérimentations, cette dernière « pourrait être la clé d’une réduction substantielle et faisable des préjugés dans la salle d’audience ».

Autre piste qui mérite d’être étudiée : l’utilisation des IA juridiques pour, non pas rendre des décisions neutres, mais détecter les discriminations. En France, les demandes d’annulation de sortie du territoire par des étrangers représentent une bonne part des litiges administratifs.

Repérer les indices de discriminations

Dans ce domaine, une IA française, Supra Legem, avait détecté de grosses disproportions entre les juges. Certains rejetaient presque 100% des demandes, d’autres deux fois moins. « Notre divulgation a déchaîné des réactions violentes, relate à Numerama Michaël Benesty, concepteur de Supra Legem et ingénieur en machine learning appliqué. Ces disparités étaient d’autant plus notables qu’on les constatait au sein d’une même juridiction.» Au sein de la Cour d’appel de Paris, un magistrat déboutait ainsi 97% des étrangers demandeurs, quand un autre n’annulait leurs demandes qu’à 40%.

« Les magistrats ne sont pas toujours au fait des pratiques de leurs pairs ; leur présenter un miroir peut les aider à disposer d’une vision globale des usages dans leur juridiction », fait valoir Jacques Lévy Véhel. Chercheur à l’institut d’études avancées de Toulouse, Daniel Chen met toutefois en garde : « Il faut envisager une approche progressive, individualisée. » Son équipe fait ainsi travailler des volontaires sur l’auto-amélioration. Au départ, l’IA est pour eux un outil d’assistance, qui permet un gain de temps. Une fois habitués à elle, ils acceptent plus aisément les outils qui alertent sur les éventuelles incohérences de leurs décisions, en dévoilant une comparaison statistique avec celles des collègues.

Quels que soient les axes de développement retenus, une chose est claire aux yeux de Florence G. Sell, professeur en droit privé à l’Université de Lorraine : « la mise à disposition des décisions de justice couplée aux progrès des outils du Big Data va permettre une vision beaucoup plus globale et approfondie du fonctionnement de la justice ». Pour l’experte, l’institution judiciaire a tout intérêt à se saisir de ces outils pour améliorer sa qualité et son efficacité. Et si elle ne le fait pas,« d’autres acteurs, tels les avocats ou les startups le feront : ce seront alors eux qui seront à la pointe d’une évolution de toute façon irrémédiable. »

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !