Il y a eu Tay, l’assistante conversationnelle de Microsoft rapidement déconnectée de Twitter. Il y a les assistants intelligents, aussi, qui prennent très souvent des traits féminins : Alexa chez Amazon, Cortana chez Microsoft ou encore Emma, assistante virtuelle intelligente de l’opérateur suédois Telenor aux traits d’une jeune femme de 28 ans, disponible 24h sur 24 pour répondre jusqu’à 5 000 questions de clients par jour… Et puis, côté expertise ou force physique, il y a ces intelligences artificielles qui prennent le plus souvent des traits masculins.

Un peu comme Ross, l’IA qui aide le cabinet d’avocats BakerHostetler, aux États-Unis : elle est devenue spécialiste des affaires de faillites d’entreprise. Pour Laurence Devillers, chercheuse au Laboratoire d’informatique pour la mécanique et les sciences de l’ingénieur (Limsi) du CNRS contactée par Numerama, « la représentation des robots auxquels on donne des traits volontairement féminins sont extrêmement caricaturaux : on parle de machines assignées aux domaines du soin, de l’accueil, ou carrément de robots sexuels ». Et la question inquiète.

« Dans 5 ans, à peu près tous les foyers auront au moins une application de l’intelligence artificielle chez eux. »

Dipty Chander, représentante de l’association E-mma pour une meilleure mixité dans le domaine du numérique, commence la plupart de ses interventions publiques avec la même affirmation : « Dans 5 ans, à peu près tous les foyers auront au moins une application de l’intelligence artificielle chez eux. » Le problème, enchaîne-t-elle souvent, c’est que ces IA sont élaborées par des équipes très majoritairement masculines. « Ces algorithmes apporteront des solutions à des problématiques que nous ne savons pas encore résoudre, ou de manière plus efficace que nous ne le faisons, ce qui est tout à fait positif explique la jeune femme. Le problème, c’est que les hommes n’ont pas la même vision du monde que les femmes. » Et donc que les produits finis risquent de manquer une partie de leur cible, ou d’accentuer des inégalités déjà existantes dans la société.

Car lorsque l’on travaille sur les innovations qui bouleverseront le monde de demain, la question des diversités de représentations est lourde d’implication. Prenons le cas du HealthKit, commercialisé par Apple en 2014 : s’il permettait toute sorte de relevés de santé, il n’offrait aucun moyen de surveiller les menstruations, pourtant le lot de la moitié de la population. Pour Dipty Chander comme pour de nombreux autres observateurs que nous avons rencontrés, la raison même de cette erreur — corrigée l’année suivante — est très simple : elle vient du manque de mixité dans les équipes de l’entreprise de Cupertino.

Côté algorithmes de Google, il est un autre exemple évocateur, notamment mis en lumière par une campagne de l’ONU : en 2014, lorsqu’un utilisateur tapait « homme » ou « femme » dans la barre de recherche, les suggestions de la fonction autocomplete du moteur — « les femmes ne savent pas conduire », « pourquoi les hommes sont-ils lâches », etc. — n’étaient que clichés. Depuis, le biais de la machine a été en partie corrigé : Google a bloqué la plupart des suggestions automatiques problématiques afin d’éviter que son moteur de recherche ne véhicule d’idées sexistes.

Mais si l’on se retourne vers son service de traduction, on constate rapidement que le problème n’est pas totalement réglé : lorsque l’on passe du turc, langue neutre, à l’anglais, Google traduction propose tout de suite de genrer les situations. Aux hommes les métiers d’ingénieur, de docteur, ou le célibat ; aux femmes les rôles de sage-femme, de cuisinière ou d’amoureuse.

Les intelligences artificielles sont bêtes

En théorie, une machine est idiote. Depuis l’invention de la roue, on en construit pour se défaire de tâches répétitives et/ou complexes, mais l’homme, lui, garde la maîtrise de l’action finale. Avec une intelligence artificielle, l’idée est la même, mais l’action que la machine doit réaliser est autrement plus complexe.

En l’occurrence, pour faire fonctionner des IA, deux schémas sont possibles : « soit on lui donne des règles — c’est ce que l’on fait depuis les années 60, il s’agit de programmation, mais les résultats avancent peu, explique dans un entretien à Numerama Dominique Cardon, sociologue et auteur d’À quoi rêvent les algorithmes. Soit on lui donne quantité de données, tellement d’exemples qu’à la fin, l’ordinateur reconnaîtra la situation de lui-même. » Cette méthode là, adoptée dans les dernières années, c’est le machine learning.

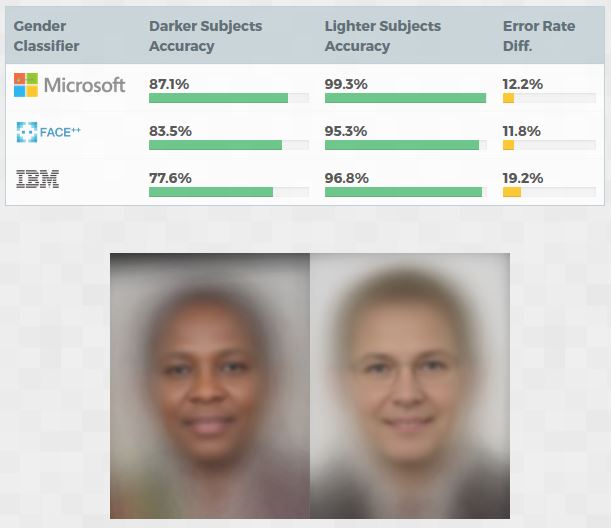

Les biais racistes d’une récente étude

Ce procédé a fait des progrès phénoménaux, mais c’est aussi là que le bât blesse : si une intelligence artificielle se base sur le comportement humain, lisible dans les données qu’on lui fournit, alors elle le reproduit. Laurence Devillers ne dit pas autre chose lorsqu’elle explique qu’en termes d’IA, « sans contrôle, l’avenir ressemble au passé. » Pour illustrer l’idée, la chercheuse parle recrutement : « Si l’on demande à une machine d’effectuer un recrutement à haut niveau, après lui avoir fourni des données représentant la sélection de ce type de candidats telle qu’elle est faite par des humains, alors elle sélectionnera principalement des hommes. » Ce sera sexiste, mais ce sera logique.

Toutefois, « il est important de comprendre que si les algorithmes sont biaisés, ça n’est pas parce qu’ils ont une intention néfaste, souligne Dominique Cardon. Ce sont des machines, des outils qui ne réfléchissent pas. » Si la société a transformé l’immense majorité des secteurs de la vie en données mesurables, se persuadant que les chiffres sont des données absolument neutres, le chercheur tient à expliquer : « Il faut renverser cette vision pour bien saisir que si les algorithmes donnent une vision déformée de la société, c’est parce qu’ils enregistrent nos propres biais. » Un retournement qu’il admet être difficile à appréhender : après tout, il va à l’encontre de l’envie de la société de se percevoir comme neutre.

Des patchs pour neutraliser les préjugés

Bref, si les intelligences artificielles ne sont pas sexistes en tant que telles — ce ne sont que des machines –, leur design et les résultats de leurs calculs le sont très fréquemment. Par ailleurs, que les équipes d’ingénieurs qui mettent au point ces nouveaux outils soient plutôt masculines n’est que le reflet de la situation globale du secteur — 33 % de femmes dans le numérique contre 53 % dans le reste de l’économie selon une étude du Syntec numérique. Mais cette accumulation de facteurs inquiète, notamment parce qu’elle risque de faire se multiplier les inégalités dans un domaine qui se veut pourtant fabriquer le futur de tous.

Résultat, les chercheurs se penchent sur le sujet. Serge Abiteboul, informaticien et directeur de recherche à l’Inria nous explique que « pour le moment, on ne sait pas bien expliquer comment une IA formée grâce au machine learning en vient à donner ses résultats. En revanche, l’avantage de ces algorithmes, c’est que leurs résultats sont tout à fait vérifiables. » Il est donc possible, d’une part, d’analyser les données en amont pour y enlever les éléments pourvoyeurs d’inégalités — le sexe des profils étudiés, par exemple. Mais on peut aussi amender les réponses biaisées fournies par les machines ex post, une fois qu’elles ont terminé leurs calculs. C’est justement ce qu’a fait Google en ajoutant des patchs pour bloquer les réponses sexistes que son moteur suggère lorsqu’un utilisateur tape « homme » ou « femme ».

« 75 % des métiers de demain toucheront à l’IA »

Dans les entreprises, les réflexions s’engagent sur le sujet. Chez Microsoft, « on ne le voit pas comme un problème purement technique, explique Bernard Oughanlian, directeur technique et sécurité. Au contraire, on mène nos recherches aussi sur les questions de représentations sociales, car les biais peuvent aussi bien se retrouver dans les données que dans les sociétés dont elles sont émises ou simplement chez les data scientist qui les traitent. »

La société s’est allié le travail de Danah Boyd et de Kate Crawford, deux éminentes chercheuses américaines, pour comprendre les raisons des biais sexistes, racistes ou sociaux dans les big data, l’impact de leur reproduction dans les intelligences artificielles, et mieux lutter contre. À l’image de Partnership on AI, qui réunit Apple, Amazon, Facebook, Google et Microsoft, ou d’Aether, panel interne à l’entreprise de Bill Gates, de nombreux comités d’éthiques se créent aussi, associant universitaires et professionnels du secteur.

Une question d’éducation

Mais la solution que l’immense majorité des spécialistes du domaine brandissent, c’est celle de l’éducation. Pour Dipty Chander, il y a un énorme sujet sur l’éducation des filles au numérique : « 75 % des métiers de demain toucheront à l’IA, de près ou de loin, assène-t-elle. Donc il faut absolument que l’on mette l’accent sur les besoins en termes d’emplois liés au numérique auprès des jeunes filles. » Autrement, le nombre de femmes présentes dans le secteur continuera de réduire, empêchant de faire reculer certains préjugés.

À cela, Dominique Cardon ajoute la dimension éthique de la conception des intelligences artificielles. « Nous avons une vraie responsabilité dans la manière dont l’on construit les algorithmes. Il faut pouvoir vérifier les données qu’on lui donne en entrée, et, tant que possible, de contrôler la règle interne de la machine, voire d’amender ses résultats ». Pour cela, il préconise la plus grande transparence possible dans la manière dont ces technologies sont construites. Une visibilité qui peut aussi bien être promue d’un point de vue technique que d’un point de vue social.

Laurence Devillers, qui est aussi membre de la commission de réflexion sur l’Éthique de la recherche en sciences et technologies du Numérique d’Allistène, complète justement : « travailler en mixité est le meilleur moyen d’améliorer nos résultats. L’informatique est un outil, il permet de quantifier, donc de mieux montrer, ce qui pourrait aussi faire entendre les femmes là où on les entend moins. » Mais elle évoque aussi une autre raison pour laquelle il faudrait former le plus grand nombre : « Grâce à l’open source, il existe énormément de librairies accessibles à tous pour permettre aux machines de faire du deep learning. Mais pour le moment, personne n’est là pour expliquer comme bien les utiliser. »

On constate tout de même certains progrès. Bernard Oughanlian note par exemple que Cortana est mieux à même de se défendre contre les attaques sexistes que ne l’avait été Tay. L’exemple a d’ailleurs fait des émules : Alexa, d’Amazon, ne se laisse plus faire non plus.

Vous pourrez toujours essayer de lui faire une proposition salace, elle refusera de vous répondre.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !