Les algorithmes qui se trouvent au cœur des systèmes d’intelligence artificielle pour accomplir des tâches spécifiques sont tributaires non seulement de la manière dont ils ont été conçus mais aussi des données sur lesquelles ils sont entraînés et formés. Or, de la qualité des informations qui sont utilisées préalablement pour les façonner dépend leur degré d’efficacité.

C’est exactement ce que vient d’illustrer une étude relayée par le site du MIT Media Lab. Joy Buolamwini, une scientifique travaillant au célèbre Massachusetts Institute of Technology (MIT), auteure principale de cette recherche, a en effet mis en lumière les biais de certaines technologies servant à la reconnaissance faciale, au niveau du genre mais aussi de la couleur de peau.

Le problème des biais dans les outils technologiques n’est pas nouveau. Il a déjà été identifié, par exemple au niveau de l’apprentissage automatique pour le traitement du langage, non pas parce que les outils sont mal conçus, mais parce que les données sur lesquels ils se basent comportent des biais — en l’occurrence, le langage humain est déjà en partie affecté par des biais.

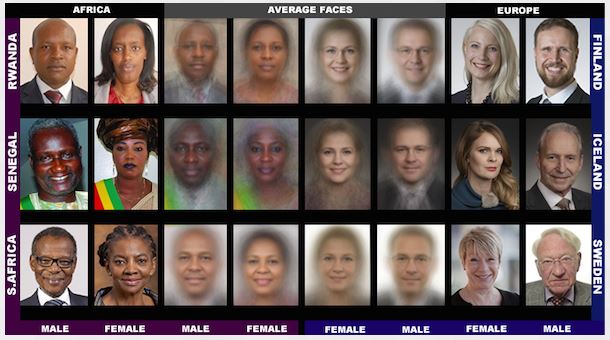

Les constations de Joy Buolamwini vont dans ce sens : elle a testé les solutions de trois entreprises — Microsoft, IBM et Face++ — avec 1 270 portraits de femmes et d’hommes issus de trois pays d’Afrique (Afrique du Sud, Sénégal et Rwanda) et trois d’Europe (Finlande, Islande et Suède), avec des morphologies et des âges variés, afin de voir s’ils pouvaient déterminer leur genre et leur couleur de peau.

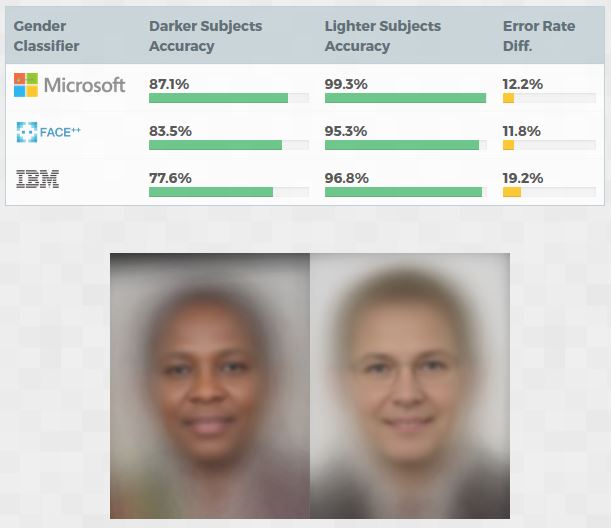

Résultat des courses ? Sur la note générale, les trois entreprises s’en sortent haut la main : dans neuf cas sur dix, elles ne se trompent pas : Microsoft affiche un taux de réussite de 93,7 %. Face++ est derrière, avec un score de 90 %. Enfin, IBM complète le podium avec une note de 87,9 %. Mais le diable se cache dans les détails. Joy Buolamwini a relevé des écarts substantiels.

Concrètement, les logiciels des trois groupes détectent plus facilement les hommes que les femmes. Et, lorsqu’il est question de la couleur de peau, ce sont les personnes à la peau claire (les personnes ayant un phototype entre 1 et 3 selon la classification établie par le dermatologiste Thomas Fitzpatrick) qui sont plus facilement identifiées que celles ayant une peau sombre (phototype entre 4 et 6).

Enjeu de la variété des données

D’où peut venir cette disparité ? L’une des explications tient sans doute au fait que, dans les données qui sont utilisées par les sociétés pour entraîner leurs algorithmes, il existe une surreprésentation d’hommes à la peau blanche, parce que ces derniers apparaissent bien plus souvent dans les photographies qui peuvent être employées dans de l’apprentissage automatique.

En clair, l’entraînement des algorithmes ne se fait sans doute pas sur des lots de clichés assez diversifiés, d’où cette disparité dans les résultats. Il s’avère que les scientifiques doivent aussi tenir compte de la propriété intellectuelle et ne pas utiliser n’importe quoi. Or, ce droit d’auteur peut être un problème, d’où les appels en faveur d’une sorte d’exception pour que l’on puisse utiliser une grande variété de données.

Dans le cas présent, cela aurait le mérite d’éviter que les algorithmes de Microsoft, IBM et Face++ ne s’appuient que sur des banques d’images remplies de stéréotypes. La prise en compte d’une exception permettrait d’aller chercher d’autres clichés, y compris ceux qui n’ont pas de licence d’utilisation adéquate, afin de limiter les biais de genre et d’ethnie.

Microsoft et IBM prennent note

Les constats de l’étude de Gender Shades ont fait réagir Microsoft et IBM.

Le premier a dit prendre le sujet « très au sérieux » et assure avoir « déjà pris des mesures pour améliorer la précision de notre technologie de reconnaissance faciale et nous continuons d’investir dans la recherche pour reconnaître, comprendre et éliminer les biais », a déclaré le géant des logiciels, dans un court communiqué que le site de la recherche a mis en ligne.

Même son de cloche chez IBM, dans une réponse plus développée : le groupe dit être « profondément engagé à fournir des services impartiaux, explicables, conformes aux valeurs et transparents ». Par ailleurs, il indique travailler sur un projet portant cette fois sur un entraînement impliquant un million de portraits tirés de la plateforme Flickr. « Nous avons l’intention de rendre ces données publiques », ajoute-t-il.

Face++ n’a pas adressé de réponse à Gender Shades. Du moins, pas encore.

Problèmes à l’horizon

Le souci soulevé dans l’étude de Joy Buolamwini, qui a déjà eu l’occasion de le médiatiser dans une conférence, est loin d’être anodin. Car il ne s’agit pas seulement de l’efficacité des outils de reconnaissance faciale pour savoir qui est qui sur une photo de vacances. Dans ce cas-là, c’est totalement anecdotique. Ça l’est beaucoup moins quand ces technologies sont susceptibles de vous causer du tort.

C’est ce que rappelle l’auteure de l’étude en prenant le cas des outils de reconnaissance des visages « qui n’ont pas été testés publiquement pour leur exactitude démographique » mais qui « sont de plus en plus utilisés par les forces de l’ordre et dans les aéroports ». Or, on ne sait rien des biais potentiels de ces solutions qui sont de toute évidence amenées à être de plus en plus répandues dans nos sociétés.

Et de mettre en garde : « l’automatisation alimentée par l’intelligence artificielle aide maintenant à déterminer qui est congédié, embauché, promu, bénéficiaire d’un prêt ou d’une assurance et même combien de temps quelqu’un passe en prison ». Oui, ce souci peut aussi avoir de lourdes conséquences sur les libertés individuelles. On comprend dès lors mieux l’enjeu de lutter contre les biais algorithmiques.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !