« Quelle est la responsabilité de ceux qui enrichissent les algorithmes et programment les intelligences artificielles ? » : cela ne fait aucun doute, ces deux questions alimenteront encore longtemps les conversations qui mêlent robotique, informatique, éthique et sociologie. Sans pouvoir donner de réponse parfaitement claire et complète aujourd’hui, nous avons de plus en plus d’exemples qui dévoilent un biais là où l’on voudrait croire à une neutralité parfaite et idéale de la fonction informatique.

Le plus récent est probablement ce concours de beauté nommé Beauty.AI, lancé par un groupe nommé Youth Laboratories qui travaille sur l’apprentissage machine. L’idée de ce concours est intéressante : il s’agissait de mener une expérience pour voir comment des intelligences artificielles peuvent juger des photos soumises par des hommes et des femmes du monde entier sur la base du volontariat. Au lieu des juges humains, on trouvait donc 5 algorithmes.

Qui enrichit les algorithmes et qui programme les intelligences artificielles ?

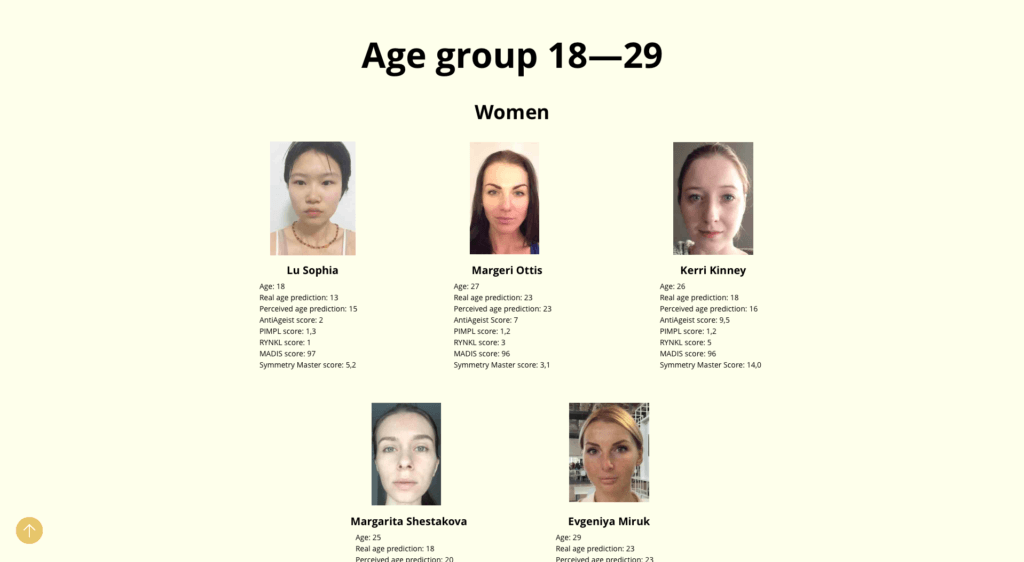

RYNKL, le premier d’entre eux, juge les photographies en notant les visages sur la base de leurs rides par rapport à leur âge. PIMPL attribue un score à un visage en analysant ses grains de beautés et sa pigmentation. MADIS attribue une note à un visage pour sa ressemblance avec celui de mannequins et d’acteurs du même groupe ethnique. Symmetry Master a cherché à évaluer, comme son nom l’indique, la symétrie du visage. AntiAgeist, enfin, comparait l’âge réel de la personne à l’âge perçu. Tous ces « robots », comme l’organisation les nomment, ont été conçus pour l’occasion : il s’agissait d’une compétition également, adressée à des équipes de développeurs.

Difficile d’y voir une rationalisation totale de ce qu’est la beauté, mais admettons : plus de 6 000 humains ont soumis leur portrait au jugement de ces robots et les résultats ont été publiés. Problème : l’écrasante majorité des gagnants sont des caucasiens. « Une poignée d’entre eux est asiatique et une seule personne a la peau sombre », affirme le Guardian, se basant sur les résultats publiés par l’organisation, avant de noter que la majorité des candidats étaient caucasiens mais qu’il y avait beaucoup de candidatures venues des continents africains et asiatiques.

Tout biais statistique écarté, reste un problème qui n’a pas manqué d’être relevé dans les cercles de réflexion et de recherche autour de l’informatique : il n’y a aucune raison valable pour que les algorithmes aient choisi une écrasante majorité de personnes ayant la peau blanche. Cela a fait réagir le directeur du pôle scientifique de Beauty.AI, Alex Zhavoronkov : ce ne sont pas vraiment les algorithmes qu’il faut accuser de racisme, mais il y a clairement un biais dans la manière dont on les a enrichis.

Tous les candidats côté juges devaient en effet proposer un algorithme construit sur des réseaux de neurones artificiels basés sur l’apprentissage profond. Cela signifie que l’algorithme a enrichi sa connaissance de la beauté en apprenant à partir d’une base de données de photographies. Si l’on veut résumer simplement le concept, il faut imaginer qu’on donne à un algorithme un premier lot de photographies ou de schémas jugés bons par des humains, par exemple des visages symétriques ou des exemples abstraits de symétries.

Ensuite, on lui fait juger un second lot de photographies en l’informant de ses performances : s’il juge un visage symétrique alors qu’il ne l’est pas, on le corrige et il apprend de cette nouvelle information. On répète l’opération sur de multiples critères et on raffine le procédé pour rendre l’algorithme toujours meilleur. L’appareil est globalement bon, mais un biais apparaît : le robot n’est capable de juger quelque chose qu’à partir de données qu’il connaît déjà. Et ici, Alex Zhavoronkov est formel : l’apprentissage des algorithmes s’est fait sur des lots de photographies qui n’étaient clairement pas assez diversifiés.

Le code n’a donc pas été programmé pour donner de meilleures notes aux peaux les plus claires, mais les données qui ont servi à l’enrichir lui ont induit ce facteur. Cette affaire rappelle deux histoires similaires et récentes : la première, aussi tragique que drôle, est celle de Tay, l’intelligence artificielle que Microsoft voulait éduquer grâce à des tweets et qui est devenue rapidement, à cause des trolls, un robot raciste, homophobe, conspirationniste et misogyne à tendance nazie. La seconde, plus problématique, est le scandale révélé par ProPublica au sujet d’un algorithme utilisé par la justice américaine censé détecter les criminels et qui « dénonçait » bien plus volontiers des Noirs que des Blancs.

L’interrogation du titre n’a donc évidemment pas de réponse nette, mais elle implique beaucoup d’autres questions, notamment sur notre capacité à neutraliser en pratique nos biais grâce à des algorithmes qu’on imagine froids et absolument objectifs. Pour l’instant, ce n’est pas vraiment le cas et donner une responsabilité d’impartialité à un algorithme est encore un rêve.

L’apprentissage des algorithmes s’est fait sur des lots de photographies qui n’étaient pas diversifiés

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !