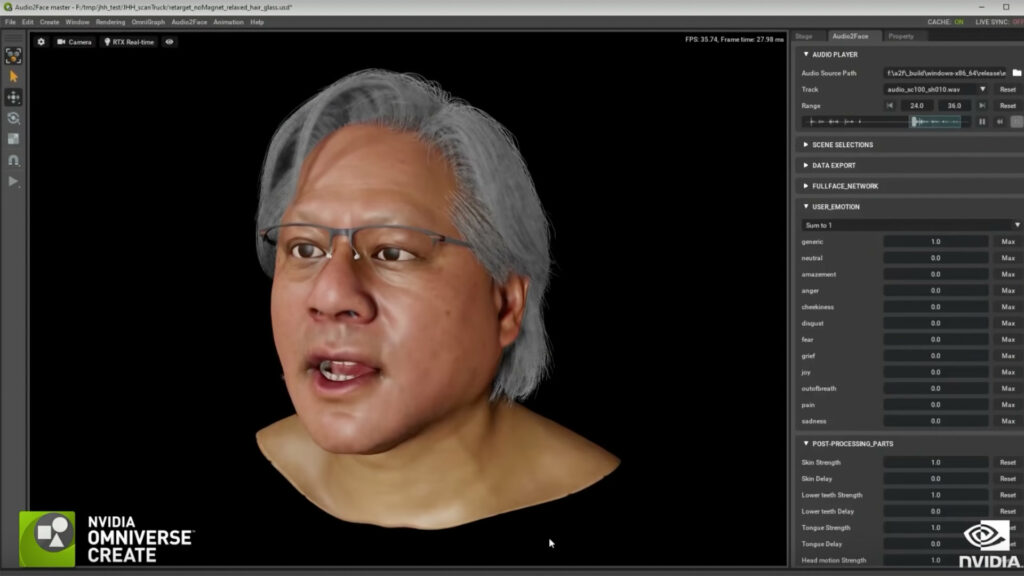

Nvidia vient de donner un nouveau sens au keynote virtuel. Lors de la présentation de son Omniverse en avril 2021, l’entreprise spécialisée dans l’intelligence artificielle et la conception de cartes graphiques a trompé le public en faisant animer une partie de la conférence par un clone numérique de Jensen Huang, le PDG de l’entreprise.

Sur les quasi deux heures de conférence, 14 secondes en tout ont été présenté par un avatar virtuel de Jensen Huang, sans que personne ne s’en aperçoive ou presque. Ces quelques secondes peuvent paraitre minimes par rapport à la durée totale de la conférence, mais elles ont demandé un travail titanesque.

Un clone créé par l’IA

Premièrement, les équipes de Nvidia ont créé un modèle 3D de Jensen Huang en le photographiant sous tous les angles avec une pléthore d’appareils photo. Ensuite, un acteur vêtu d’une combinaison permettant de capturer les mouvements a relu les anciens discours du PDG en imitant ses mouvements. Cela a permis à Nvidia de créer 21 modèles de modélisations 3D qui ont tous été analysés pour créer un squelette virtuel convaincant. Un algorithme a en plus été entrainé à répliquer les mimiques du PDG pour rajouter une couche de réalisme.

Un logiciel appelé Audio2Face a ensuite été chargé de faire bouger le visage du clone en 3D pour coller au texte lu par le vrai Jensen Huang. Un autre programme nommé Audio2Gestures a permis à Nvidia d’animer les bras et le corps du mannequin virtuel selon ce qui était lu. En combinant ces deux technologies, le clone 3D a pu s’exprimer physiquement comme un véritable humain le ferait.

Le résultat de cette expérimentation est visible aux alentours de 1:02:42 sur la vidéo de présentation de Nvidia. Et si le mannequin virtuel est un peu raide, l’illusion fonctionne tout de même assez bien.

Vers des deepfake plus convaincants ?

Un des ingénieurs en charge de la virtualisation de Jensen explique dans un documentaire dédié au making of de cette conférence que « contrairement à la création d’un personnage virtuel dans un film, où il est possible d’accumuler énormément de données, ici nous avons très peu de contenu au départ ». Le challenge a donc été de créer un double convaincant à partir d’un scan 3D de Huang et de pas grand-chose d’autre. L’animation de la bouche, la synchronisation des mouvements avec le texte, « tout a été réalisé grâce à une IA », précise Nvidia.

L’exploit ici n’est donc pas d’avoir créé un humain virtuel convaincant, les jeux vidéo font ça depuis quelques années avec une grande efficacité, mais plutôt de créer un double virtuel à partir d’un jeu de données très réduit. « Notre challenge était de créer des outils permettant de créer des humains virtuels beaucoup plus facilement », explique un ingénieur en charge du projet. La création d’un Jensen Huang virtuel n’est donc pas qu’un simple coup de pub : les algorithmes de Nvidia pourraient faciliter la création de personnages en 3D, que ce soit pour le jeu vidéo ou le cinéma.

On peut imaginer qu’en analysant des personnages de films, leur manière de parler et de bouger, il deviendrait alors possible de créer des doubles convaincants. Peut-être même plus convaincant que ce qu’on a pu voir dans les récents films ou séries Star Wars.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !