Google Brain, le projet de recherche sur l’intelligence artificielle et l’apprentissage profond, du géant du web, s’efforce de développer un logiciel capable « d’écrire » des articles façon Wikipédia… Avec des résultats plus ou moins concluants.

L’objectif de l’équipe de recherche était de développer un logiciel capable d’extraire des informations de différentes sources sur un même sujet, afin de « générer » un résumé complet de ses informations essentielles. Ils rendent compte de leurs travaux dans un article publié pour la Conférence internationale sur l’apprentissage de représentations (International Conference on Learning Representations, ICLR), qui se tiendra en avril 2018.

Dans le domaine de l’intelligence artificielle (IA), plusieurs projets visant à faire produire des textes par un ordinateur ont été développés ces dernières années, comme le robot-journaliste du Washington Post ou le réseau neuronal entraîné par Salesforce pour produire des résumés. Toutefois, les résultats en terme d’écriture ne sont pas toujours réussis : dans le cas de Salesforce par exemple, les phrases générées par ordinateur étaient simples et courtes, et manquaient du rythme d’un texte écrit par des humains.

Résumé par extraction

Les chercheurs de Google Brain affirment que leur algorithme est capable de créer des « paragraphes de plusieurs phrases fluides et cohérentes », et même des articles entiers. Si les phrases sont en effet un peu plus naturelles que ce qui a été réalisé jusqu’ici, le procédé n’est toutefois pas encore au point.

L’équipe de Google Brain a utilisé la technique du « résumé par extraction » : il s’agit d’extraire les phrases les plus pertinentes du document-source, et de les concaténer pour produire un sujet. C’est l’approche la plus utilisée pour les résumés automatiques de textes. Les chercheurs ont appris à leur algorithme à identifier les informations pertinentes sur un sujet donné, et à les organiser grâce à un « modèle abstractif neuronal » pour créer un article.

Le modèle fonctionne en prenant en compte les dix premières pages web sur le sujet concerné (l’entrée Wikipédia est alors exclue), ou bien en extrayant des informations des sources d’un article de Wikipédia. Les paragraphes de chaque page sont classés, et mis les uns à la suite des autres pour créer un seul long document. Puis le texte est codé et raccourci, divisé en 32 000 mots, et utilisés comme donné.

Structure des phrases répétitive

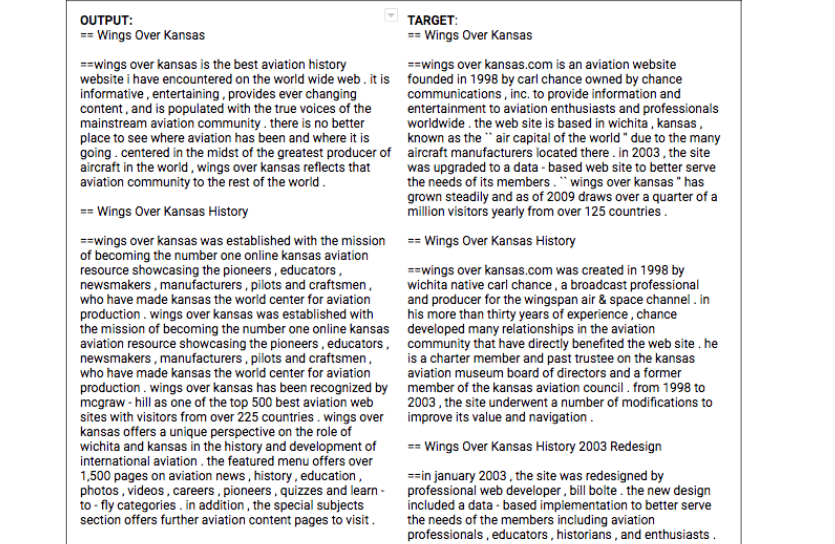

Le modèle abstractif est ensuite « nourri » de ces données, et réduit les phrases longues pour en constituer de plus courtes. Le résumé produit par l’algorithme ne « crée » donc pas des phrases à partir de rien, mais les génère à partir du texte extrait. Cela explique probablement pourquoi la structure des phrases est assez répétitive, comme on peut le voir dans cet exemple fourni en annexe de l’étude, un article réalisé sur le site d’aviation Wings over Kansas.

À gauche, le texte produit par l’IA de Google Brain ; à droite, l’article original de Wikipédia./Liu et al.

L’IA (à gauche) a produit des phrases plutôt lisibles, malgré l’absence de majuscule et des problèmes typographiques. Toutefois, on constate qu’elle a parfois répété des phrases, et le contenu, surtout au début, manque d’une certaine neutralité habituellement attendue dans un article Wikipédia. Cela paraît inévitable, dans la mesure où l’IA reprend les dix premiers résultats sur un sujet, qui peuvent donc être facilement orientés, et ne semble pas encore capable de faire un véritable tri sur le contenu. La qualité du résumé créé par l’IA pourrait d’ailleurs être bien pire, selon les premiers résultats obtenus sur un sujet. Il serait donc pour l’instant dangereux d’utiliser cet algorithme pour écrire des articles Wikipédia.

Les chercheurs à l’origine de l’étude s’estiment toutefois satisfaits du résultat, estimant que « des recherches plus poussées pour améliorer l’algorithme pourraient être plus fructueuses ». Ils vont par ailleurs publier les liens utilisés pour ce projet, « afin d’encourager la recherche sur la fabrication de résumés à grande échelle ».

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !