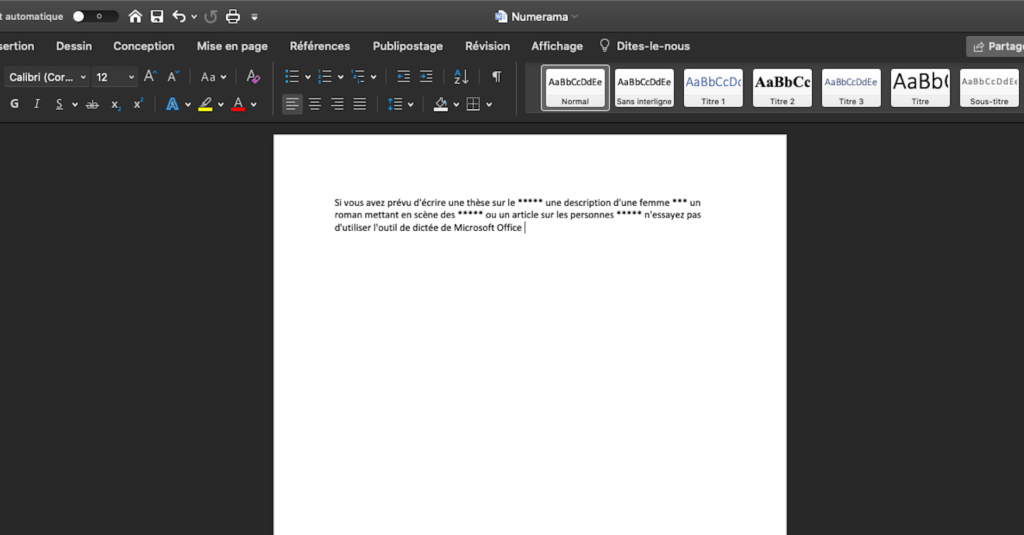

Si vous avez prévu d’écrire une thèse sur le « porno », une description d’une « femme nue », un roman mettant en scène des « pénis », ou un article sur des personnes « trans », n’essayez pas d’utiliser l’outil de dictée de Microsoft Office.

Tous ces mots clés seront transformés en une série d’astérisques.

Sur les forums, les internautes parlent de « censure » et de « politiquement correct » nord-américain, et se demandent bien pourquoi des mots du quotidien sont ainsi masqués. Elles et ils pointent aussi du doigt l’absurdité de la situation. Même des expressions comme « nus-pieds » et « au sein de » sont touchées. De notre côté, nous avons noté une irrégularité de traitement des mots relatifs aux orientations sexuelles et identités. Ainsi, le mot « hétérosexualité » est masqué, mais pas « homosexualité », le mot « lesbienne » l’est, mais pas le mot « gay ». Y a-t-il un message politique derrière ce choix de mots masqués ?

Apparition inopinée de vocabulaire inapproprié

Une responsable de Microsoft France nous a indiqué être très surprise que cette règle existe, et qu’elle ne reflète pas leurs valeurs et les efforts du groupe en faveur de la diversité et de l’inclusivité. Après investigation, elle a pu nous expliquer qu’il s’agissait d’un filtre mis en place au début du développement du “speech to text” par le siège de Microsoft, lorsque la qualité de la dictée vocale était encore perfectible.

A l’époque, la reconnaissance vocale suscitait espoir, moquerie, mais aussi peur. Les erreurs des différents outils se retrouvaient régulièrement dans les médias, parfois elles faisaient rire, comme quand Siri n’arrivait pas à comprendre l’accent irlandais et parfois elles inquiétait, comme quand Alexa renvoyait des enfants sur des sites pornographiques faute d’avoir compris leur requête.

Microsoft n’a pas été épargné par ses erreurs de reconnaissance vocale. La qualité de la dictée à l’époque faisait parfois apparaître du « vocabulaire inapproprié », pour reprendre les mots du service presse de Microsoft France, « ce qui était gênant, spécifiquement dans le domaine de l’éducation ». Seattle a donc mis en place une liste de mots que l’outil speech to text pourraient malencontreusement faire apparaître et qui pourraient heurter son jeune public et les a automatiquement masqués.

Aujourd’hui, la qualité de la dictée vocale en français s’est considérablement améliorée et il est peu probable que l’outil confonde des mots et retranscrive un mot « inapproprié » s’il n’a pas été prononcé, pourtant le filtre existe toujours et il n’est pas désactivable. D’après nos informations, il semblerait que les employé et employées de Microsoft n’étaient pas au courant de son existence. Il devrait être rendu désactivable fin décembre, début janvier, nous a-t-on assuré, et la liste des mots masqués sera adaptée. Depuis notre appel, les mots « lesbienne » et « transgenre » ont d’ailleurs été retirés du filtre, ce qui est une bonne nouvelle.

Pourquoi masquer « lesbienne » mais pas « gay » ?

Le choix des mots masqués interroge. On peut comprendre que les mots « pénis » ou « chatte » fassent rigoler des enfants, que la lecture du mot « cunnilingus » entraîne des questions dont les parents se seraient passés, mais quel danger représentent les mots « lesbienne » et « trans » ? D’après notre interlocutrice, il s’agit de respecter les sensibilités de chacun.

Cette volonté est louable, mais, dans ce cas précis, respecter les sensibilités de certaines personnes a conduit à valider leur vision du monde et notamment leur volonté d’invalider et d’invisibiliser une partie de la population. En masquant les mots relatifs à la lesbiannité et aux transidentités, mais pas à l’homosexualité masculine, l’outil de diction confirme que les lesbiennes et les transgenres sont « inapproprié·es », que leur existence peut perturber, alors que les gays ne posent pas de problème. Son incapacité à comprendre le mot « gouine », alors même qu’il saisit sans problème son équivalent masculin « pédé » (il est inclus dans le filtre), va dans le même sens. Numerama avait d’ailleurs montré, l’an dernier, comment le référencement du mot « lesbienne » dans Google et son association à de la pornographie était à la fois grave et injuste.

D’après notre interlocutrice, il est possible que cette différence de traitement provienne de considérations technologiques. « Certains mots sont plus clairement distinctifs d’un point de vue technique et théorie du signal que d’autres », a-t-elle expliqué à Numerama, « ils n’ont pas été sujets à être enlevés ». N’ayant pas pu discuter avec les personnes responsables de la création de ce filtre, notre interlocutrice n’a pas pu apporter d’exemple. Est-ce pour cela que le mot « homosexualité » n’a pas été masqué alors que le mot « hétérosexualité » l’a été ? Est-ce que, s’ils avaient été moins intelligibles, les mots « homosexualité » et « bisexualité » auraient aussi été dans la liste des mots masqués, ou est-ce que seul le mot « hétérosexualité » dérange ? Quand on sait avec quelle ardeur certains penseurs et penseuses ont protesté contre le concept d’hétérosexualité, la décision de masquer ce mot interroge. Car il s’agit bien d’une décision.

Chacun des mots de ce filtre y a été ajouté par une personne. Les algorithmes ne sont pas neutres, comme nous l’avons mis en avant à multiples reprises à Numerama. Ils sont créés par des êtres humains qui posent sur le monde un regard qui leur est propre, et ce regard se retrouve dans leurs décisions professionnelles. Que l’outil de diction de Microsoft masque certains mots peut sembler anecdotique pour certains, mais il s’ajoute à tous les autres biais que portent les algorithmes. Ces biais reflètent ceux de la société autant qu’ils les alimentent. Il est de la responsabilité des entreprises qui les créent de s’assurer que leur algorithme n’invisibilise pas une partie de la population et ne perpétue pas de clichés néfastes.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !