Il y a eu des deepfakes de Tom Cruise impressionnants de réalisme, et même une émission de Thierry Ardisson utilisant la technologie pour ranimer Dalida. Les deepfakes, des images conçues par intelligence artificielle et qui permettent de créer des vidéos imitant d’autres personnes, sont désormais courants. Mais si la technologie peut être utilisée à des fins positives, malheureusement, elle l’est souvent pour des motifs funestes.

On a vu un tel exemple en mars 2022, lorsqu’une vidéo de deepfake usurpant l’identité du président ukrainien, Volodymyr Zelensky, appelant les soldats à déposer les armes, a circulé sur internet. Plus récemment, c’est le FBI qui a averti sur l’utilisation de deepfakes par des cybercriminels lors d’entretiens d’embauche.

Certains deepfakes sont grossiers, et d’autres sont remarquables. Mais, selon les chercheurs de Metaphysic, l’entreprise à l’origine des fausses vidéos de Tom Cruise, les intelligences artificielles auraient une faiblesse : la représentation des personnes de profil.

Les intelligences artificielles n’ont pas assez de références

Metaphysic, dans une publication du 8 août 2022 sur son site, explique que les intelligences artificielles sont encore largement incapables de représenter des personnes étant complètement de profil, c’est-à-dire orientées à 90°.

« Il existe une vulnérabilité intéressante dans les vidéos deepfakes, qui a, jusqu’à maintenant, été généralement négligée », écrivent les chercheurs de Metaphysic. La raison à cela est simple, selon les auteurs : jusqu’à récemment, les appels en visioconférences utilisant des deepfake n’étaient pas une source d’inquiétude.

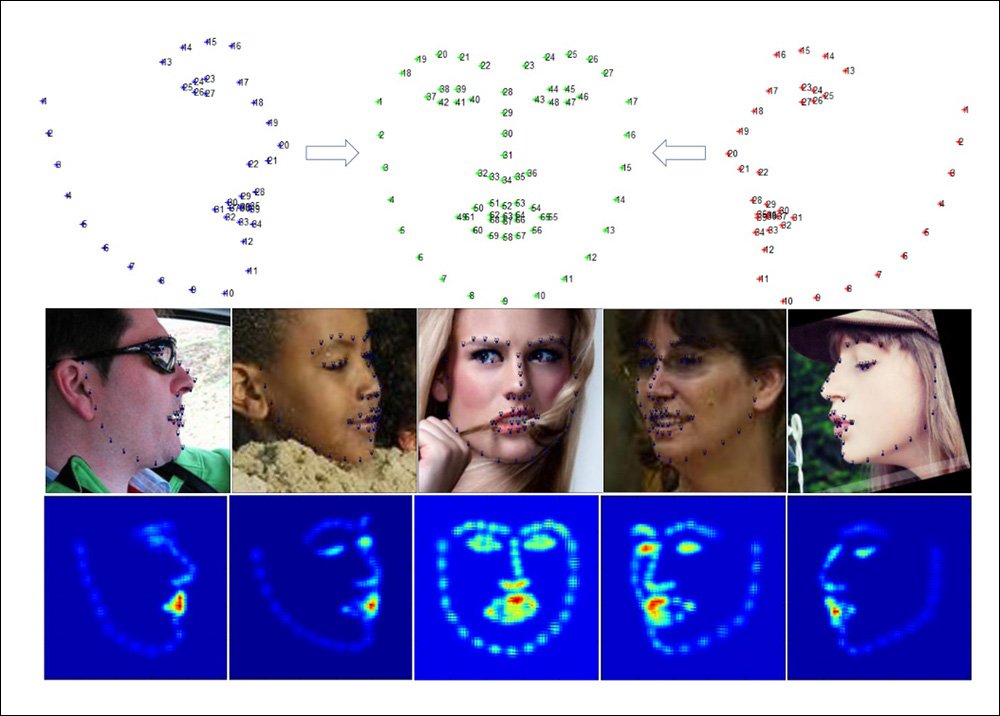

Comment expliquer ce défaut ? Il y a deux explications principales, selon Metaphysic. Premièrement, les intelligences artificielles utilisées pour analyser et cartographier les visages savent le faire pour les personnes de face, grâce à de nombreux points de repère. Seulement, « la plupart des algorithmes de reconnaissance trouvent seulement 50 ou 60% de ces points sur des visages de profil », note l’étude. Les IA peinent à analyser les visages, plus ces derniers sont tournés de côté.

L’autre raison est plus simple : « en dehors du personnel médical, des experts des effets spéciaux, et des services de police, personne ne veut de photos de profil ». Les photos de face et les photos de 3/4 sont celles qu’on trouve le plus régulièrement dans les bases de données, car « les photos prises de profils sont les moins flatteuses, et les moins expressives ».

Il y a donc moins de photos sur lesquels les intelligences artificielles peuvent s’entraîner — ce qui empire encore un peu plus les limitations de base de l’intelligence artificielle.

Si un jour, vous passez un entretien d’embauche et que vous pensez qu’un de vos interlocuteurs pourrait utiliser un deepfake, vous savez ce qu’il vous reste à faire : lui demander de se tourner à 90°.

Nouveauté : Découvrez

La meilleure expérience de Numerama, sans publicité,

+ riche,

+ zen,

+ exclusive.

Vous voulez tout savoir sur la mobilité de demain, des voitures électriques aux VAE ? Abonnez-vous dès maintenant à notre newsletter Watt Else !