Nous n’avons pas mis un pied sur Mars, nous ne conduisons pas de voiture volante, mais les robots soldats sont pour demain. L’intelligence artificielle programmée pour tuer fait partie des scénarios imaginés par Hollywood et le déploiement d’appareils autonomes semble aujourd’hui de plus en plus envisageable. Depuis la fin novembre, la ville de San Francisco se demande si elle va autoriser ses services de police à utiliser des robots pour neutraliser un criminel.

De fait, des appareils connectés pour tuer existent déjà depuis longtemps, mais la crainte repose plus sur l’autonomie de la machine pour prendre ce genre de décision. Laisser à un algorithme le choix d’enlever la vie est une vaste question philosophique à laquelle nous n’avons pas de réponse.

La course pour développer la technologie la plus efficace pour repérer et tirer, elle, est bien lancée. Fin 2020, un agent du Mossad — les services de renseignements israéliens — a été capable de tuer un scientifique nucléaire iranien à plus de 1 000 km grâce à un engin téléguidé. Les dernières générations de drones MALE (moyenne altitude longue endurance) à l’instar du MQ9-Reaper américain peuvent parfaitement suivre une cible puis tirer un missile à haute précision quand l’ordre est donné.

Des équivalents terrestres sont également en développement — l’Estonie et Singapour travaillent sur un mini tank télécommandé — et pourraient un jour faire leur apparition sur un champ de bataille. La Chine s’intéresse aussi à cette technologie.

Des armes que l’on peut hacker

Aucun système n’est aujourd’hui pleinement autonome, mais des avancées dans cette direction sont observables : un dérivé du célèbre robot chien « Spot » de Boston Dynamics, équipé d’un fusil-mitrailleur sur le dos, a fait son apparition sur les stands des salons militaires. Le modèle civil est capable de se déplacer seul, à partir du moment où le chemin a été programmé à l’avance. Aux États-Unis, puis en Russie, en Chine et en Turquie, des start-up de l’armement ont fait sensation avec leur quadrupède tueur. La société russe est allée plus loin dans la promotion avec une vidéo de son modèle tirant sur différentes cibles.

Trois semaines plus tard, un hacker diffusait un test où il était capable de désactiver l’appareil à distance avec un Flipper Zero, un petit gadget capable de copier un signal radio par exemple. Quant au modèle, c’est une copie chinoise du robot américain, en vente sur le site d’e-commerce AliExpress.

Cette expérience montre l’une des premières limites à ces engins : ils sont connectés donc ils peuvent être piratés. Au mieux l’adversaire le désactive, au pire, il le détourne. Ensuite, il faut encore déterminer comment il sera capable de reconnaitre un adversaire sur un champ de bataille. Enfin, s’il est plus efficace qu’un humain dans un combat en face, l’adaptation a un terrain militaire et de nombreux soldats est un casse-tête technologique.

Un débat avorté à l’ONU

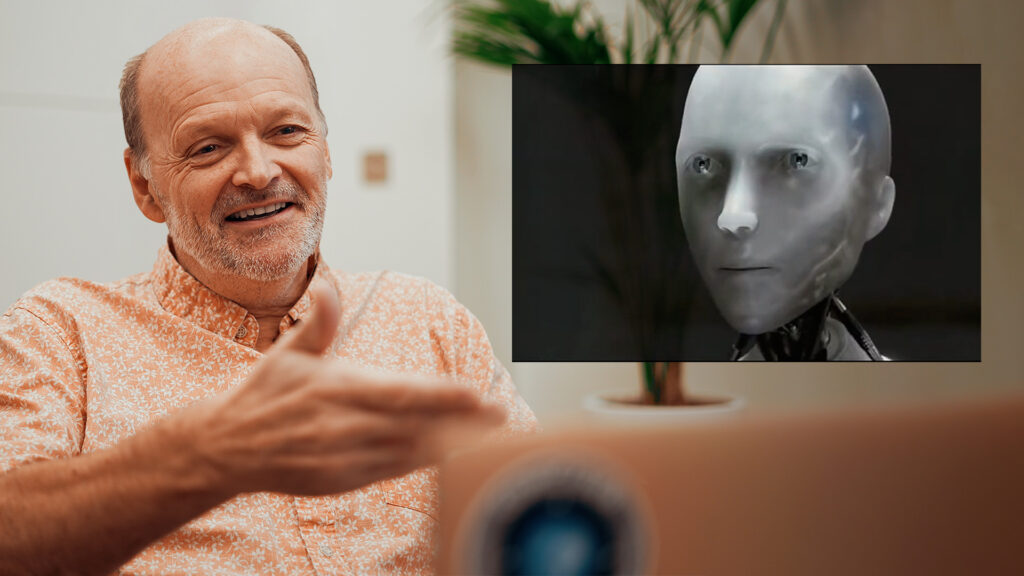

Luc Julia, directeur scientifique de Renault et expert de l’intelligence artificiel, nous rappelle les limites de ces avancées : « Le robot tueur est déjà une réalité et il continuera à être amélioré. Il va neutraliser plus rapidement, plus précisément et sera plus endurant qu’un humain. Sur le terrain, c’est plus compliqué parce qu’un robot est programmé pour réaliser une tâche et que dans une bataille il y a des hommes qui peuvent venir de nulle part, il y a des explosions, en somme beaucoup d’aléas. L’homme en tant que tel est un animal extrêmement compétent dans l’espace », nous explique-t-il.

Pour l’instant, aucune loi ne permet à un robot de tuer sans l’accord d’un humain. En 2020, un drone turc Kurga-2 avait tué un soldat en Libye et la rumeur dit qu’il a neutralisé la cible sans aucune action humaine. Cet acte avait été rappelé lors d’un débat sur l’interdiction du développement d’arme autonome par l’ONU à la fin du mois de décembre 2021. Aucun accord n’avait été conclu à la suite de ces réunions.

Si de nombreuses entreprises de la robotique, à l’instar de Boston Dynamics, ont déclaré qu’elles ne s’engageraient jamais sur ce terrain, les groupes de l’industrie de l’armement, souvent liées aux États, n’ont pas réagi. Un peu comme le nucléaire, il ne reste plus qu’à attendre de voir jusqu’où les gouvernements peuvent aller.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !