D’après l’Organisation mondiale de la santé, plus d’un milliard de personnes présentent une forme ou une autre de handicap — soit 15 % de la population mondiale. Rendre la technologie accessible à toutes et à tous est donc un enjeu fondamental d’autant que certaines innovations visent aussi à faciliter le quotidien des personnes handicapées. Dimitri Kanevsky veut répondre simultanément à ces deux problématiques avec son projet Euphonia, qu’il mène dans les laboratoires de Google.

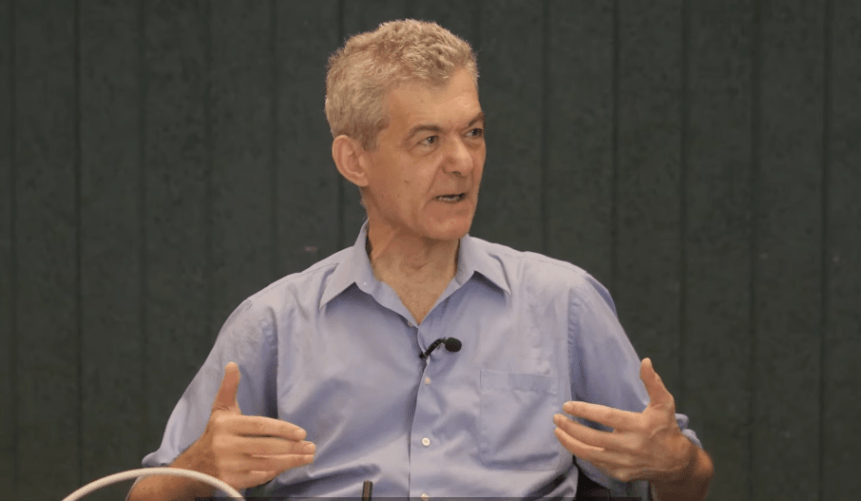

Ce mathématicien de formation est sourd depuis l’âge de 1 an. Il fait donc partie des 466 millions d’individus dans le monde qui souffrent d’une déficience auditive handicapante. Comme pour la plupart des personnes atteintes de surdité, son élocution est difficile. Né en ex-URSS, il n’est pas non plus aidé par son accent russe. Mais Dimitri Kanevsky est un inventeur et il était motivé depuis plusieurs décennies à créer une technologie qui puisse l’aider à communiquer plus aisément, sans passer par un casque comme l’imagine Facebook. C’est la raison pour laquelle il a conçu Euphonia : cet algorithme encore expérimental permet de retranscrire des paroles en temps réel sous forme de texte par un système adapté aux troubles de la parole.

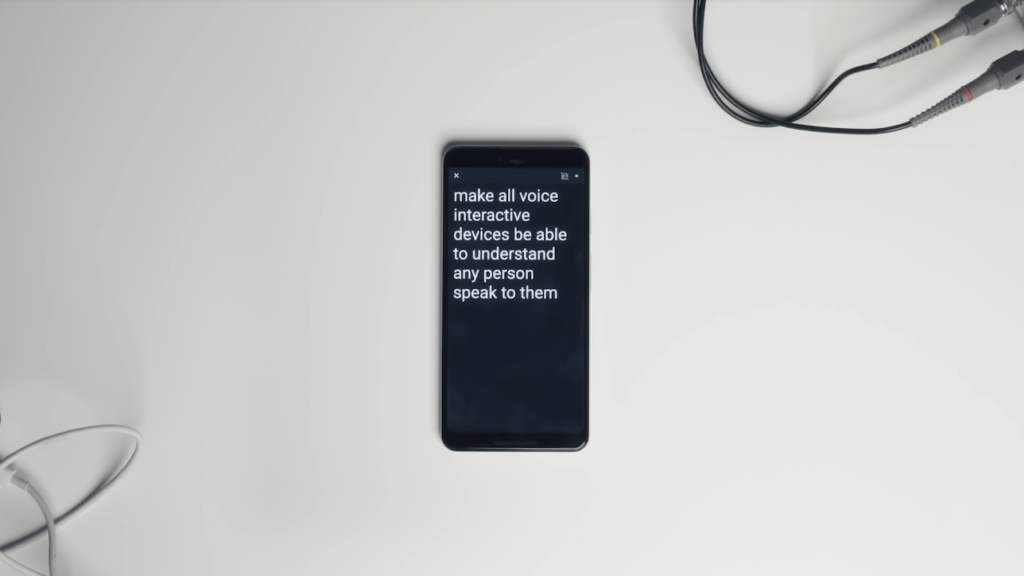

Euphonia, comme Live Transcribe, doit pouvoir fonctionner sur un smartphone. // Google

Comprendre et être compris

Il existe déjà des logiciels de retranscription venant en aide aux personnes sourdes et aux malentendantes. Parmi les plus connus : Live Transcribe. Cette application Android développée par Google permet d’obtenir, en temps réel, des retranscriptions écrites de conversations orales. Assez performante, elle peut aussi traduire une ambiance, en relevant quand il y de la musique, des rires ou même des aboiements.

Live Transcribe permet de comprendre, là où Euphonia permet finalement l’inverse : être compris. Et cette ambition est loin d’être une évidence. Les enceintes comme Google Home ou Amazon Alexa peuvent comprendre une majorité de voix, mais pas celles qui ne correspondent pas aux standards d’élocution — ce qui a été un problème avec certains accents est encore plus le cas lorsque l’on souffre d’un trouble de la parole.

Une enceinte Google Home. // John Tekeredis / Pexels

Euphonia est encore expérimental, mais la vie quotidienne de Dimitri Kanevsky est déjà métamorphosée par l’utilisation de son logiciel. « La capacité de pouvoir comprendre les autres et qu’ils me comprennent m’aide beaucoup. Pour la première fois, j’ai pu parler à mes petites filles… elles pouvaient me comprendre », confie l’inventeur à Numerama dans un reportage que vous pouvez regarder sur notre chaîne YouTube. Sa vie professionnelle est aussi simplifiée : « Maintenant, je peux donner des cours partout ! », se réjouit-il.

Un système personnalisé par deep learning

Pour fonctionner, Euphonia n’a pas besoin de connexion internet. L’algorithme fonctionne localement, directement sur l’appareil où il est installé. Résultat : la couverture réseau n’est pas importante et l’énergie nécessaire est minime. « Live Transcribe utilise le Cloud car [l’application] utilise un modèle très large entraîné pour de très nombreuses personnes, explique Dimitri Kanevsky. Mais [Euphonia] est entraîné seulement pour ma voix, alors c’est plus petit. »

Dimitri Kanevsky

Source : Numerama

Les algorithmes de reconnaissance vocale standards font appel à des modèles de langage et des modèles phonétiques. Les personnes atteintes d’un trouble de la parole ne répondent cependant à aucun modèle. Pour cette raison, Euphonia doit être personnalisé. Le logiciel prend la forme d’un réseau de neurones artificiel qui est entraîné pour une seule et même voix, par apprentissage machine. Dimitri Kanevsky a enregistré plus de vingt mille phrases, ce qui représente vingt heures de données vocales.

Euphonia fonctionne par correspondance directe sans aucun modèle intermédiaire de référence. Les paroles prononcées par l’utilisateur sont en fait traduites dans le logiciel sous forme de spectrogramme. L’algorithme transcrit en temps réel les sons émis par la voix sous forme de mots et de phrases, qu’il a appris à reconnaître et à associer grâce aux exemples enregistrés. Dimitri Kanevsky peut préparer un texte en amont, que Euphonia va alors reconnaître parfaitement, mais le deep learning permet tout autant d’improviser, de parler naturellement, avec un taux d’erreurs qui s’amoindrit au fil du temps.

Euphonia en action.

Source : Numerama

L’accessibilité technologique, tout un programme

Dimitri Kanevsky insiste sur le fait qu’Euphonia n’est encore qu’un prototype qui a besoin d’être optimisé. À l’heure actuelle, peu de gens peuvent l’utiliser aussi bien que lui. Il est le premier à avoir entraîné l’algorithme, personne n’a encore enregistré autant de paroles et personne d’autre ne l’utilise au quotidien en dehors de lui. Mais Google a évidemment lancé une phase de test sur des échantillons plus larges, par exemple avec des personnes souffrant de la maladie de Charcot. « Nous avons besoin de collecter de nombreux exemples vocaux de personnes ne répondant pas aux standards de la parole », précise le mathématicien.

Avant même que le logiciel soit encore au point, il envisage déjà quelles seront les prochaines étapes pour améliorer Euphonia. Par exemple, il aimerait pouvoir « combiner des données visuelles, comme la lecture sur les lèvres, ce qui pourrait aider en cas de gros bruits ». Plus loin encore, il espère à terme atteindre la « compréhension des émotions et d’ajouter la langue des signes », relève-t-il sans plus de précisions sur le procédé qu’il envisage pour y aboutir.

D’ici 2050, le nombre de personnes sourdes et malentendantes devrait atteindre 900 millions. Un projet comme Euphonia n’est donc pas destiné à une petite part de la population, bien au contraire, les besoins vont grandir jusqu’à une personne sur dix. Google compte d’ailleurs développer son programme d’accessibilité dès 2019/2020. Par exemple, Slide Caption intégrera en temps réel, sur les diapositives Google, les commentaires prononcés par la personne qui présente. Un module Live Caption sera également disponible pour sous-titrer les vidéos YouTube sans passer par le Cloud.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !