En janvier dernier, Mark Zuckerberg publiait en guise de vœux de bonne année un mea culpa sur les fausses informations qui gangrènent son réseau social. « Ce monde semble anxieux et divisé, et Facebook a beaucoup de travail à faire, que ce soit pour protéger notre communauté des abus et de la haine, [ou] la défendre contre les ingérences d’Etats ». Il disait faire de ces sujets sa priorité pour 2018, et promettait d’importants progrès à venir dans le courant de l’année.

Neuf mois plus tard, le 14 septembre, des chercheurs américains rattachés à l’université de Stanford et à la new-yorkaise NYU ont publié les conclusions d’une étude menée à ce sujet. Celle-ci porte sur une période plus large, s’étalant entre janvier 2015 et juillet 2018. Et à première vue, il y a du mieux.

Les fake news continuent à mobiliser sur Twitter, mais pas sur Facebook

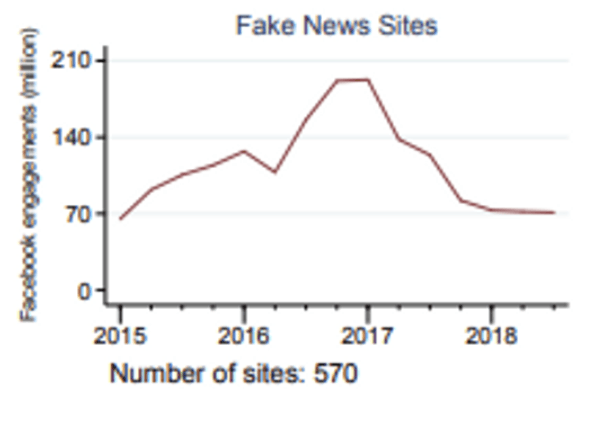

Les chercheurs se sont focalisés sur les publications de 570 sites différents identifiés comme diffuseurs de fausses informations, sur Facebook ainsi que sur Twitter. Ils ont ensuite enregistré le nombre d’interactions avec ces médias : les « likes », les partages, commentaires et retweets.

Jusque fin 2016, les chiffres ne cessent d’augmenter sur les deux sites. Ils continuent à croître ensuite sur Twitter, tandis qu’ils baissent « nettement » sur Facebook.

Pour Facebook, la question des fausses informations s’est particulièrement posée en 2016. Lors de la campagne présidentielle américaine, des « fake news » ont été propagées, plusieurs étant de fausses rumeurs sur la dernière candidate face à Donald Trump, Hillary Clinton. Cette dernière avait par exemple été reliée à tort à un réseau pédophile d’envergure.

Les portraits des deux finalistes pour la présidentielle américaine de 2016, dans un restaurant peu avant le vote.

Source : Mr. Gray / FlickrL’impact qu’ont pu avoir ces informations sur les votes des électeurs américains est difficile à estimer. Mais certaines enquêtes ou études ont estimé qu’elles avaient été plus partagées sur Facebook que les nouvelles données par des médias traditionnels.

Des progrès survenus bien après les élections américaines

Depuis 2016, Facebook a pris de nombreuses mesures pour tenter d’enrayer ce phénomène, comme des « indicateurs de confiance » ou la suppression massive de faux comptes douteux. L’étude des chercheurs de Stanford et du NYU explique que les effets n’ont pas été immédiats. Peu après l’élection (aucune date précise n’est donnée), les pages et comptes spécialisés dans les « fake news » qu’ils suivaient généraient toujours 70 millions d’engagements chaque mois (contre environ 200 millions pour les 38 sites d’informations les plus populaires, comme le New York Times, CNN ou le Wall Street Journal).

Les pages spécialisées dans les « fake news » généraient toujours 70 millions d’engagements chaque mois

Les progrès semblent avoir été faits plus tard. En 2015, au début de l’étude, on compte 1 partage Twitter de fausse information pour 40 interactions sur Facebook. Fin juin 2018, ce ratio était de 1 pour 15. Le déclin ensuite observé est-il le signe que Facebook a enfin trouvé la recette miracle pour lutter contre la désinformation ?

Comment des pages ont déjoué l’attention de Facebook

En réalité, c’est un peu complexe que cela. Les chercheurs eux-mêmes reconnaissent des biais dans leur étude. Celle-ci prend en compte quelques centaines de pages et comptes, et leur liste n’est pas exhaustive. Il est possible, disent-ils, que les personnes et entités qu’ils avaient identifiées en 2016 comme d’importants diffuseurs de fausses informations aient depuis été remplacées par de nouveaux acteurs sur Facebook.

Cela pourrait aussi être lié aux « efforts des producteurs de fausses informations pour contourner les techniques de détection de Facebook ». Par exemple, certains changeraient le nom de domaine du site vers lequel leurs liens postés renvoient, afin que le réseau social ne puisse pas les identifier immédiatement comme problématiques grâce à ses algorithmes.

Si ces pages n’avaient pas évolué et ne s’étaient pas adaptées depuis 2016, les chercheurs estiment finalement que le nombre d’engagements sur Facebook aurait changé à peu près de la même façon que sur Twitter, c’est-à-dire auraient probablement augmenté.

Par ailleurs, on peut remarquer sur les graphiques présentés dans l’étude que la baisse du nombre d’engagements ne fait que compenser la hausse observée en 2016. Le niveau de 2018 est ainsi à peu près équivalent à celui de 2015.

La courbe montre qu'entre 2015 et 2018, le nombre d'engagements n'a finalement pas tant changé.

Source : Stanford EduFin août, l’ancien directeur de la sécurité de chez Facebook, Alex Stamos, confiait que Facebook était selon lui très loin d’en avoir terminé avec le problème des fake news. Selon lui, les prochaines élections américaines de mi-mandat, qui auront lieu début novembre, risquent bien de se muer en « Coupe du monde de la propagande ».

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Marre des réseaux sociaux ? Rejoignez la communauté Numerama sur WhatsApp !