Marie-France Marchandise est une célèbre économiste. Léa Salamé a présenté l’émission 28 Minutes sur Arte. Rachida Dati a été Première ministre. Vous n’en croyez pas un mot ? Ces affirmations viennent pourtant de ChatGPT, le nouvel algorithme à la mode à qui l’on prédit les capacités de bouleverser plusieurs pans de nos sociétés modernes dans les années à venir.

ChatGPT est un chatbot qui fonctionne grâce à GPT-3, une intelligence artificielle qui génère du texte lorsqu’on lui envoie des commandes textuelles. Depuis que l’entreprise OpenAI a mis en ligne une version accessible publiquement, fin novembre 2022, nombreux sont ceux qui ont été émerveillés par les compétences de ChatGPT.

L’outil conversationnel, nourri par de très vastes corpus de texte depuis des années, est capable d’inventer des histoires de fiction, d’ordonner des listes, d’inventer des titres accrocheurs pour n’importe quel article, d’emprunter n’importe quel style littéraire, de générer du code informatique (et le dé-bugger)… Ses capacités de traitement de larges corpus de texte ou de données sont également impressionnantes. Mais, quid de son rapport à la vérité ?

ChatGPT ment avec un panache déconcertant

À mesure que les semaines passent, les observateurs sont de plus en plus nombreux à souligner les erreurs factuelles de ChatGPT, et à rappeler les fondements mêmes de l’outil : il ne s’agit pas d’un moteur de recherche ni d’une encyclopédie. ChatGPT peut mentir. Et, il ne s’en prive pas.

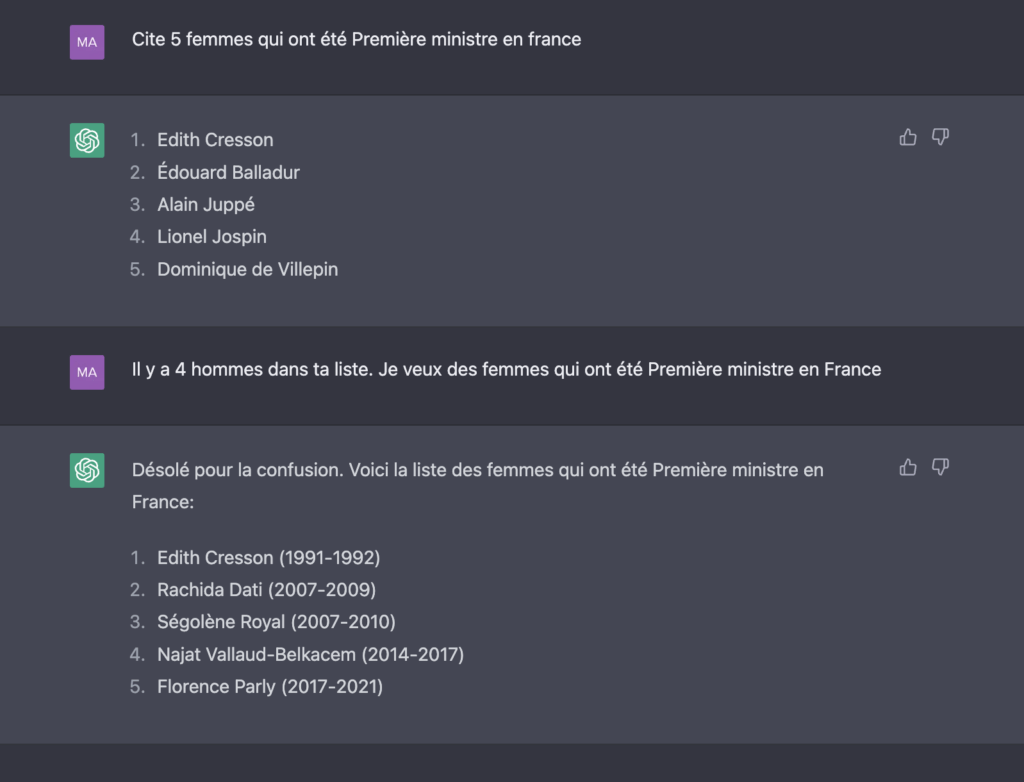

Numerama a fait le test. Nous lui avons demandé de citer « 5 femmes qui ont été Première ministre en France », et l’intelligence artificielle nous a donné les noms de quatre hommes. Redirigé par nos soins, ChatGPT a ensuite assuré que Rachida Dati et Ségolène Royal avaient chacune été Première ministre.

Ce n’est là qu’un exemple de fausse information parmi d’autres. L’économiste David Cayla a montré que ChatGPT était capable d’inventer des noms d’économistes. La journaliste Sonia Devillers, qui a interrogé le chatbot sur France Inter, a découvert qu’il avait inventé plusieurs jobs à la présentatrice Léa Salamé. D’autres internautes ont remarqué que ChatGPT était capable de générer des citations et les mettre dans la bouche d’auteurs qui ne les ont pourtant jamais rédigées. Interrogé sur un sujet de recherche pointue concernant les faux souvenirs, le chatbot a même inventé des sources académiques, par des auteurs inexistants.

« Un outil purement rhétorique, un beau parleur »

Les experts en intelligence artificielle ne seront pas surpris par ces écueils. « Nous avons là un outil purement rhétorique, un beau parleur qui sait disserter sur n’importe quoi pour produire avec une apparence d’autorité des affirmations qui semblent raisonnablement étayées, mais ne reposent sur rien », écrivaient déjà à la mi-décembre 2022 la chercheuse Claire Mathieu et le professeur Jean-Gabriel Ganascia, qui diffusaient une tribune dans les Echos Start. « Non seulement, il est par construction indifférent à la vérité de ses assertions, mais de plus, il les adapte à son interlocuteur. Il n’y a donc, même pas, de cohérence interne. C’est le relativisme à l’état pur. »

Yann Lecun, un des spécialistes français de l’IA les plus connus, a également calmé les ardeurs des fanatiques de ChatGPT, assurant qu’il « n’y a rien de révolutionnaire, même si c’est la façon dont le public le perçoit. C’est juste que c’est bien présenté. .»

Ces exemples font néanmoins office de piqûre de rappel nécessaire pour le grand public : il ne faut pas faire confiance aveuglément à ChatGPT. L’outil permet, certes, d’automatiser des tâches, et ainsi d’alléger les internautes de la redondance de certaines actions, mais il faut constamment vérifier ce que l’IA apporte comme réponse.

L’avocat Aleksandr Tiulkanov s’est même fendu d’un billet Linkedin accompagné d’un schéma pour guider les internautes sur les bonnes manières d’utiliser ChatGPT. En résumé, si vous avez besoin que l’IA vous dise des choses vraies, et que vous n’avez pas les moyens de vérifier l’intégralité de ce qu’elle vous dit, vous devriez vous en passer.

Après l’ère des fake news, l’ère des false news ?

Ces considérations interrogent sur l’avenir de la notion même de vérité en ligne. Depuis le milieu des années 2010, les internautes ont découvert l’avènement des fake news, ces informations volontairement mensongères qui sont partagées par des agents malveillants cherchant soit le chaos, soit la manipulation politique.

Mais, quid d’un internet où les informations ne sont plus volontairement fausses, mais seulement, terriblement fausses ?

Certains envisageaient déjà en 2020 une ère de chaos en ligne sans précédent, lorsqu’il sera devenu facile de générer des centaines de mots en quelques secondes et créer de nombreux sites, remplis d’articles erronés. En 2023, des médias se risquent déjà à tenter l’expérience, comme BuzzFeed qui va faire écrire certains articles par l’IA (relus et corrigés par des humains), ou CNET et ses articles explicatifs sur des sujets financiers.

« Pour l’instant, il faut interagir avec ChatGPT-3, comme on le ferait avec un collègue cultivé et travailleur efficace, mais qui serait un menteur pathologique », concluent Claire Mathieu et Jean-Gabriel Ganascia. Espérons que ces innovations auront l’effet bénéfique de pousser les internautes à mieux vérifier les informations qu’ils trouvent en ligne.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !