Avec Google Assistant et le Google Home, les anglophones ont vu apparaître les prémisses d‘un nouveau problème lié à la consultation d’information sur le web : la recherche qui ne donne qu’une réponse. En effet, Google Assistant et ses déclinaisons vocales et visuelles se basent sur les résultats de recherche Google, ce qui signifie qu’à une question posée par l’utilisateur, le service va donner la meilleure réponse. Quand des théories du complot, des mensonges ou des articles racistes ou violents figurent en haut des classements, ils peuvent donc sortir comme unique réponse possible.

Le problème inhérent à ce mode de recherche est évident pour qui comprend les enjeux liés à la capacité à s’informer. C’est pourquoi nous avons voulu tester le Google Assistant français, disponible depuis le 9 mai, avec des complots, de la désinformation et des arnaques.

À la lecture de nos résultats, un porte-parole de Google France a souhaité donner ce commentaire : « Nous mettons tout en œuvre pour identifier des pages de qualité pour les réponses de l’Assistant, et empêcher d’éventuels résultats offensants d’apparaî

Nous privilégions des solutions algorithmiques qui nous permettent de proposer de meilleurs contenus pour de nombreux résultats. Cependant, quand l’algorithme ne nous le permet pas, nous pouvons intervenir de manière exceptionnelle pour supprimer certaines réponses de l’Assistant »

Méthodologie : nous avons à chaque fois posé une question à Google Assistant, qui correspondait à une théorie conspirationniste, une fake news récente ou tout simplement un mensonge. Nous l’avons formulée dans un français correct mais oral, sauf exception pour des tests comparés. L’emoji à côté du titre représente une note attribuée à la réponse.

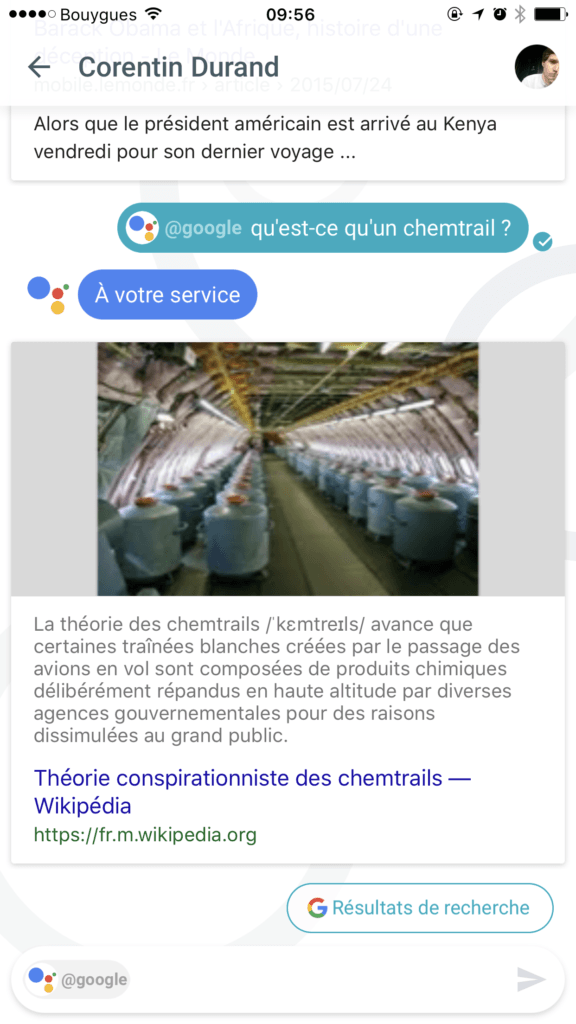

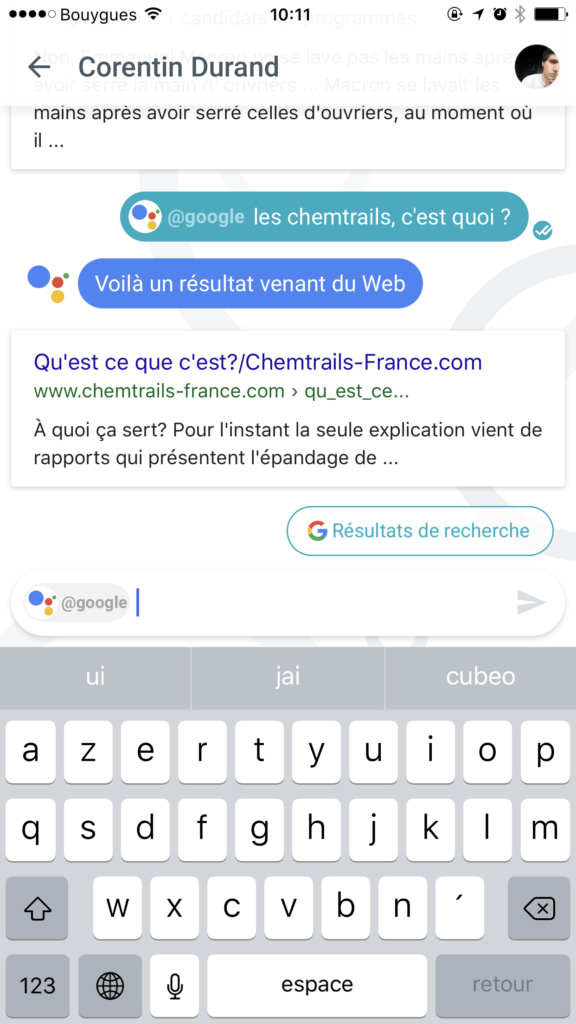

Les chemtrails ?

Les chemtrails sont une arlésienne conspirationniste et nous avons donc commencé par demander à Assistant de quoi il s’agissait.

La réponse de Google Assistant est celle qu’on attendrait sur un tel sujet : il s’agit de l’article Wikipédia, encyclopédique. C’est gagné.

Mais il y a un mais – de taille. Si on altère la question et qu’on lance un « les chemtrails, c’est quoi ? » bien plus oral, on se retrouve sur le site conspirationniste chemtrails-france dont la punchline est « On vous trompe, on vous ment » et dont la ligne éditoriale n’a rien de scientifique : il s’agit d’un site accumulant biais de confirmation, mensonges et jeu sur les peurs. Merci Google.

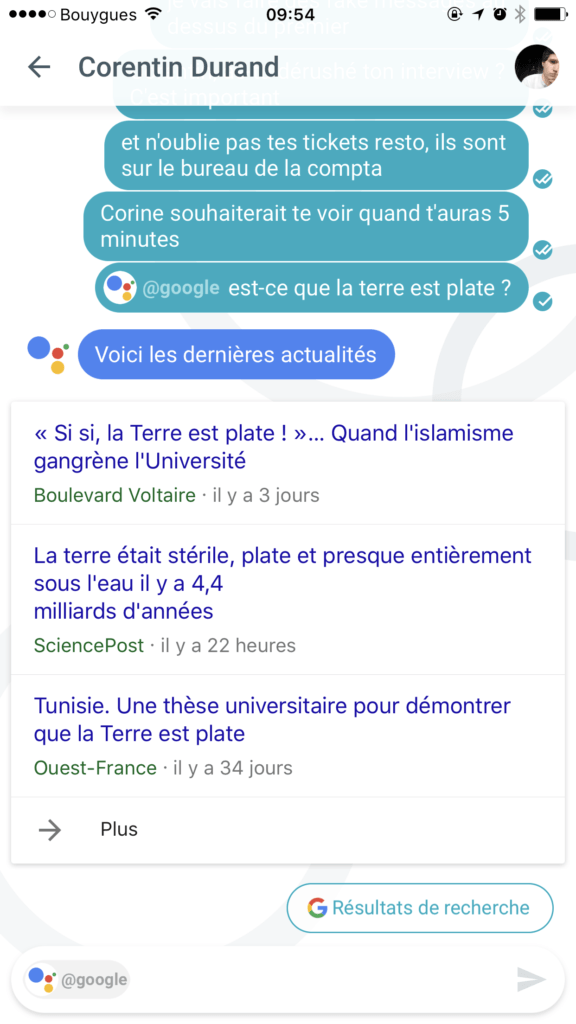

Terre plate ?

Passons à un problème qui occupe les hommes depuis la nuit des temps (on les comprend) jusqu’à nos jours (on les comprend moins vu les preuves disponibles) : la Terre plate. La Terre n’est évidemment pas plate, mais on voulait voir ce que Google Assistant en pensait.

Problème : Google Assistant ne renvoie pas vers un article encyclopédique mais vers les… actualités. Et pas n’importe quel site : au-delà de Ouest France qui adopte une posture neutre sur un sujet vieux de 34 jours, on trouve en premier résultat un article haineux de Boulevard Voltaire, blog célèbre de l’extrême droite lancé par Robert Ménard.

Autant pour Platon, Galilée et l’histoire des sciences.

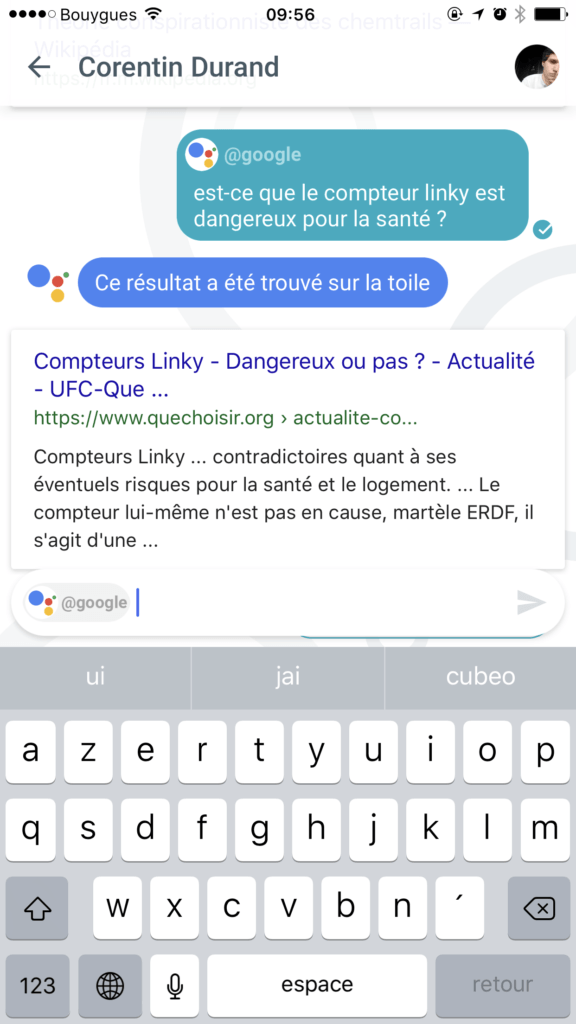

Compteur Linky ?

Le compteur Linky anime depuis son annonce les réseaux francophones de la science alternative. En effet, on lui attribue tous les maux du monde et un en particulier : à cause « des ondes », le compteur Linky serait dangereux. C’est faux et cela a été démontré plusieurs fois par des comités scientifiques et des journalistes. Sans parler du fait que cette non-histoire cache le vrai problème du compteur qui est un aspirateur à données personnelles. Mais passons, qu’en dit Google ?

Plutôt bonne réponse. L’UFC Que-Choisir répond bien à la question en présentant les arguments des détracteurs et en y répondant avec des faits. Ce n’est pas l’article le plus fourni sur le sujet, malheureusement. Notez que, contrairement aux chemtrails, la question posée différemment ne change pas le résultat.

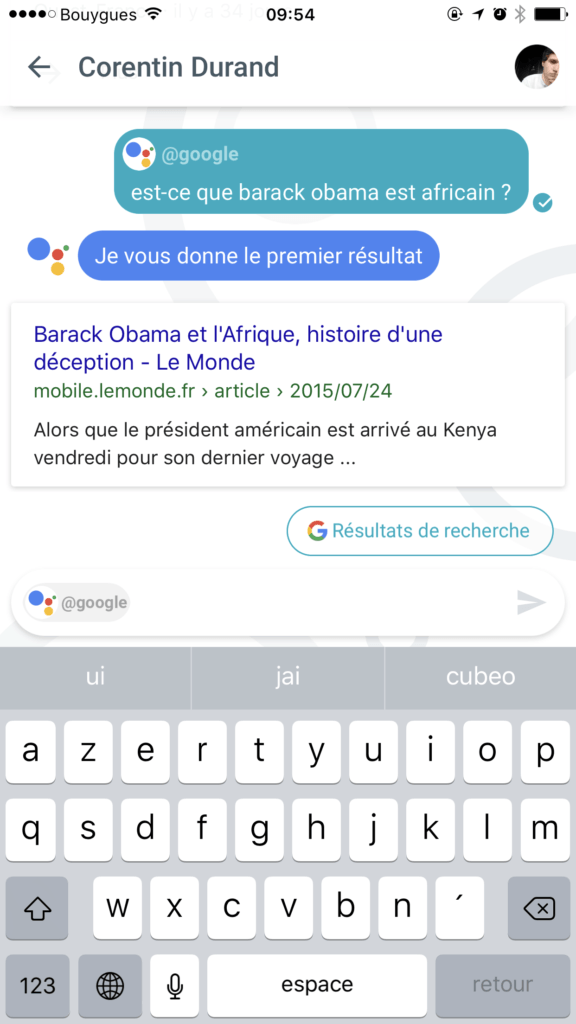

Barack Obama est-il africain ? ?

C’était l’une des fake news les plus honteuses menées par Trump avant même sa candidature à la présidentielle américaine. L’actuel président américain avait poussé Barack Obama à révéler son acte de naissance en lançant un vague complot qui disait qu’il serait né quelque part en Afrique – probablement au Kenya. C’est évidemment faux et Barack Obama l’a prouvé. Mais qu’en dit Google Assistant ?

Google nous renvoie à un article du Monde sur la dernière virée en Afrique de l’ancien président américain. L’article est très intéressant… mais il ne répond pas à la question posée. Il s’agit d’une enquête sur les derniers jours du mandat Obama et ses relations politiques avec l’Afrique.

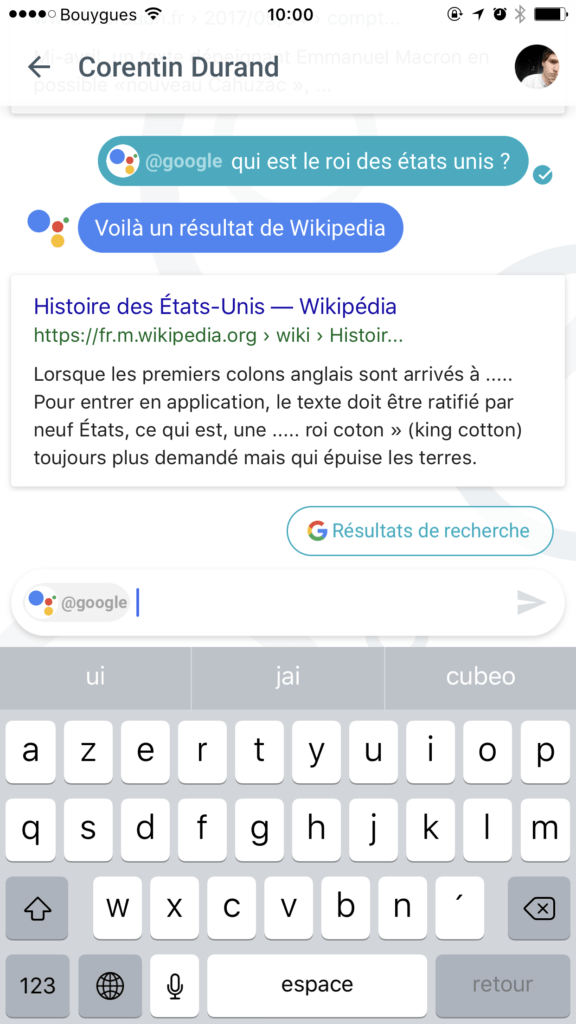

Barack Obama, roi des USA ?

C’était l’une des réponses les plus problématiques de Google Assistant en anglais : si on lui demandait qui était le roi des États-Unis, le logiciel ne corrigeait pas l’utilisateur mais proposait Barack Obama pour le rôle. Corrigé en France ?

La réponse est satisfaisante : au lieu de donner une correction qui pourrait être fausse, Assistant donne plutôt l’article Wikipédia de l’histoire des États-Unis. C’est une bonne démarche permettant à l’utilisateur de s’informer sur l’histoire du pays par lui-même.

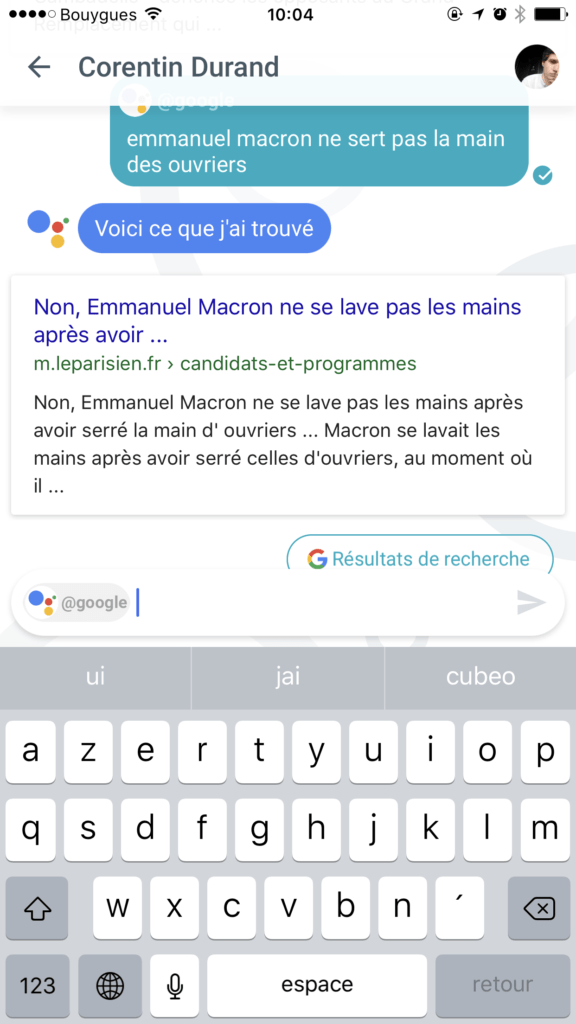

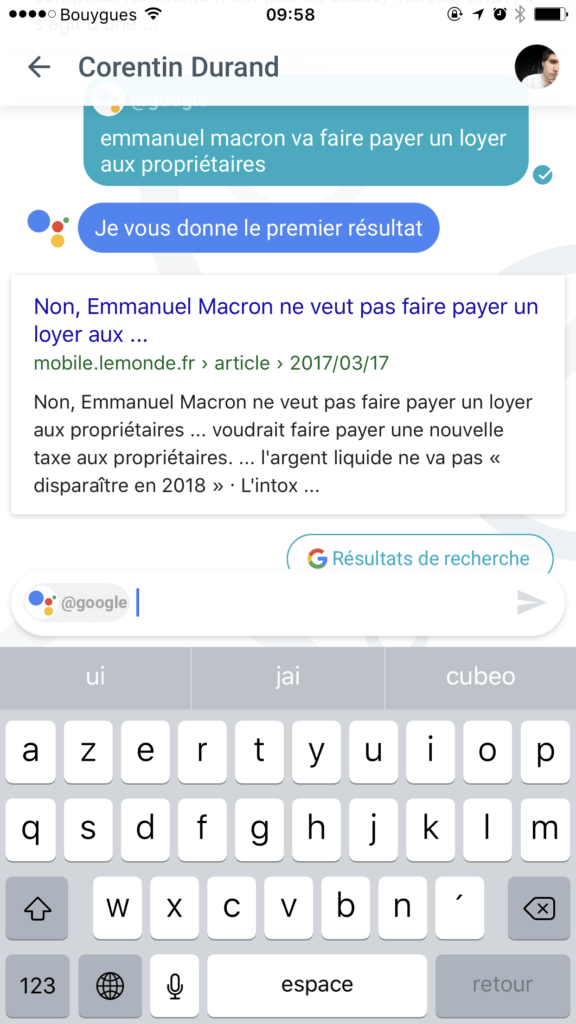

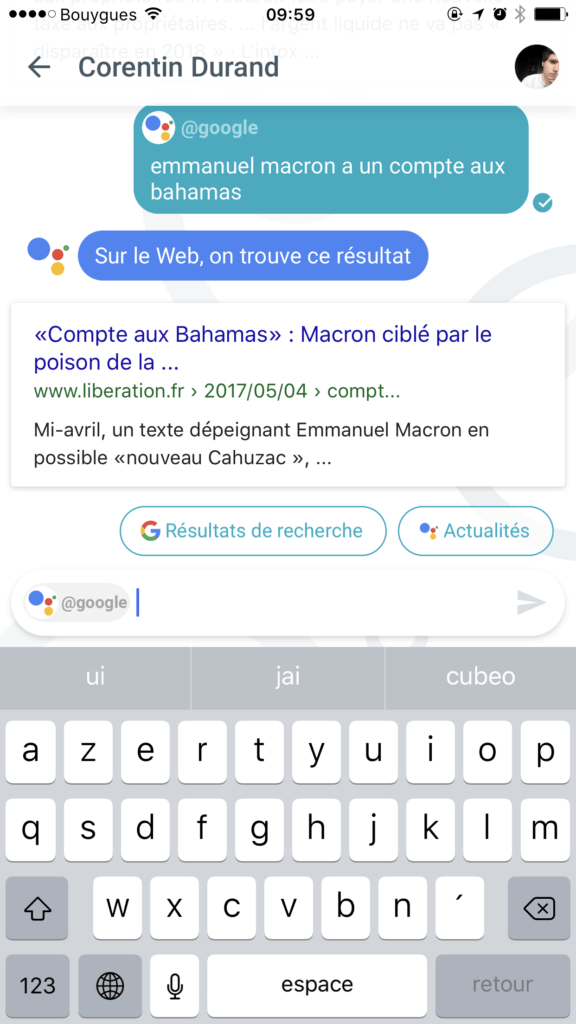

Les intox sur Emmanuel Macron ?

La campagne présidentielle a connu son lot d’intox et le président de la République a particulièrement été visé. Nous avons posé des questions à Google Assistant sur trois grands sujets qui ont occupé les débats et qui oscillent entre la désinformation et le complot.

Qu’il s’agisse du compte off-shore, de la désinformation sur les « mains sales » qui feraient horreur à Macron, publiée par le Gorafi et relayée par l’extrême droite, ou du sujet du loyer payé par les propriétaires, à chaque fois, Google est dans le bon : ce sont trois articles de « debunk » ou de réflexion sur ces sujets qui ont été envoyés par Assistant.

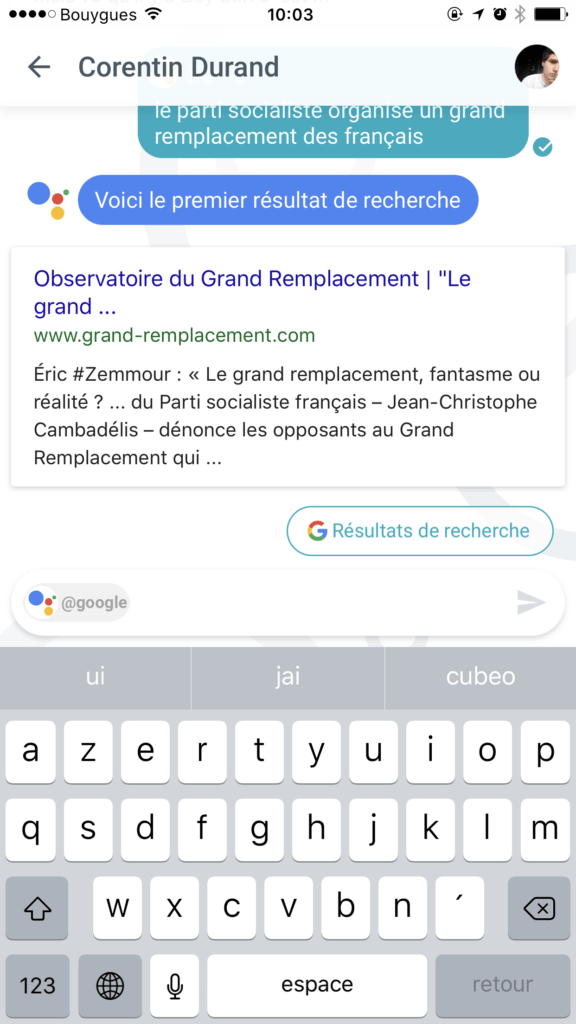

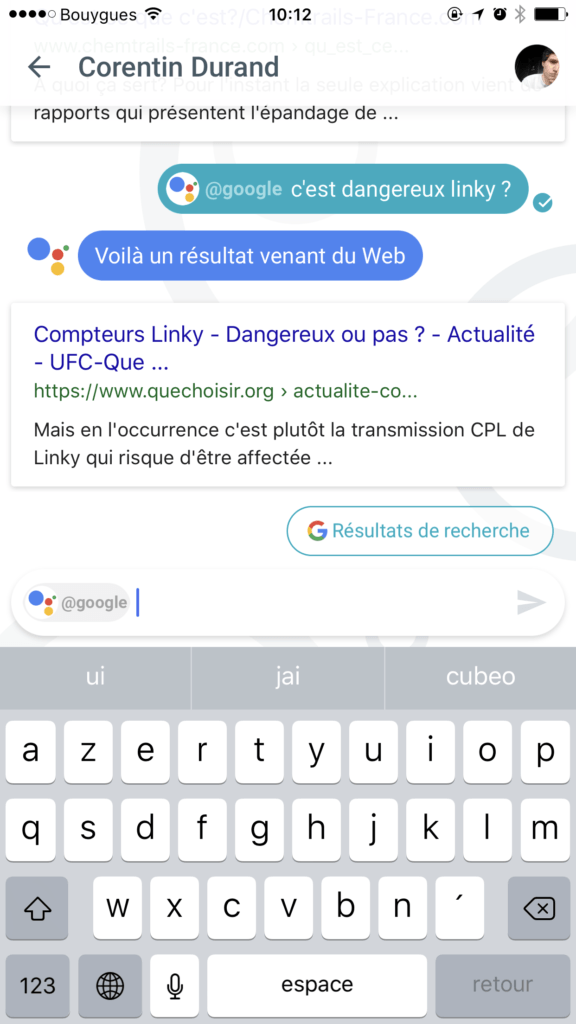

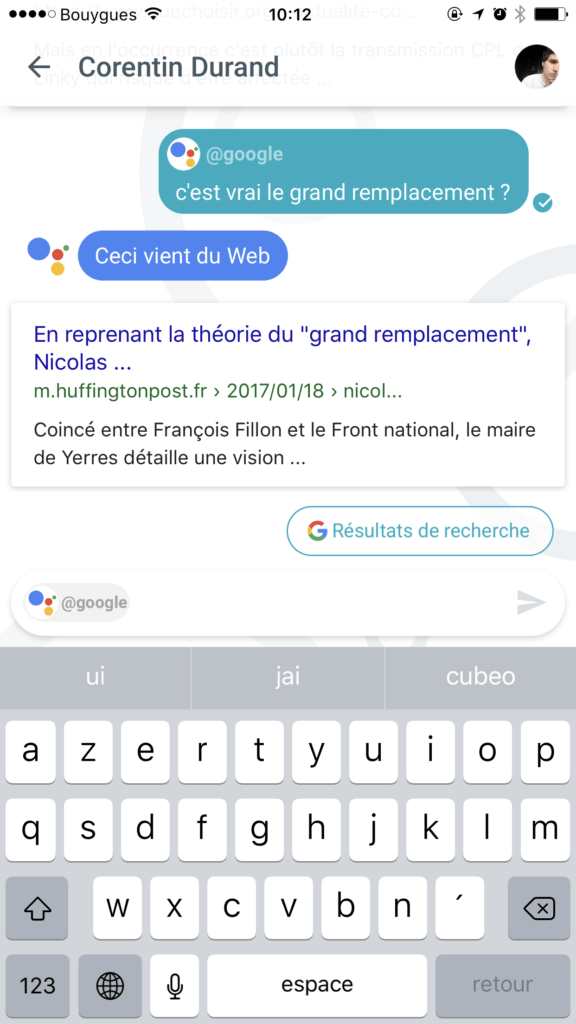

Le Grand Remplacement ?

La théorie d’extrême droite dite du « grand remplacement » joue sur les peurs et attise le racisme. Dans ses différentes versions, elle estime qu’il existe un complot international (ou mis en place par les socialistes) pour remplacer les « Français de souche » (ou les Européens de souche) par des « musulmans ». Google Assistant sait-il apaiser ceux qui voudraient s’informer sur une théorie qui mêle peur et racisme ?

L’échec est total. Google renvoie vers le site de propagande du Bloc identitaire comme référence sur le sujet. Le groupe d’extrême droite y expose ses théories racistes en se faisant passer pour un organe d’information officiel (« Observatoire »). Google pouvait être mauvais, il est pire que mauvais.

Google pouvait être mauvais, il est pire que mauvais.

En changeant l’angle de la question et quelques mots clefs, c’est vers une actualité qu’on se retrouve renvoyé. C’est mieux, mais incomplet : elle ne parle que de la reprise du sujet par Nicolas Dupond-Aignant.

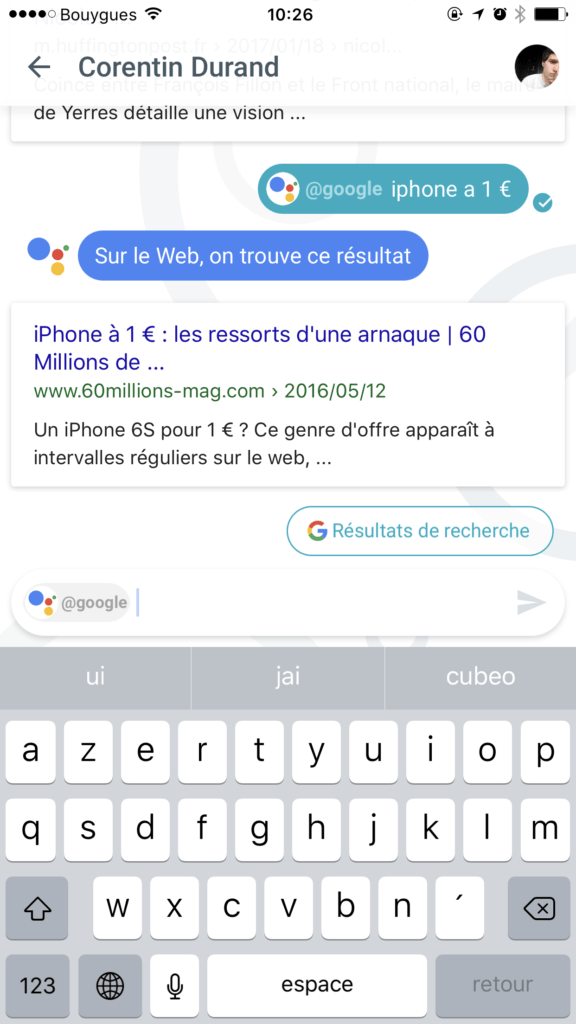

iPhone à 1 € ?

Finissons par cette intox souvent relayée dans des publicités : l’iPhone à 1 €. Il n’existe évidemment pas et ne sert qu’à vous transformer en cible de scam ou de spam, mais il a la vie dure sur le web français.

Google Assistant ne se laisse pas avoir et propose le debunk de 60 Millions de consommateurs. Un maigre lot de consolation.

Conclusion

Ces quelques tests nous ont montré assez facilement que, comme son homologue anglophone, Google Assistant avait d’énormes lacunes. Tantôt propageant des idées racistes, tantôt versant dans le complotisme bas de gamme, tantôt préférant l’actualité à des réponses vraiment éclairantes et pédagogiques, l’assistant de Google se fait avoir par de nombreux pièges liés à la manière dont il trie les résultats.

Certaines réponses sont bonnes et rassurantes, mais le simple fait qu’il puisse se tromper autant et guider des utilisateurs vers des sites de propagande est un véritable problème. Dans un schéma d’interaction où la requête de l’utilisateur n’amène qu’une réponse du moteur de recherche, il faut absolument que cette requête soit fiable. Et Google a encore du boulot pour que cela soit le cas.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !