Quand vous parlerez à ChatGPT ou génèrerez une vidéo avec Sora dans les prochains mois, ce seront peut-être les puces Blackwell B200 de Nvidia qui opèreront en coulisses.

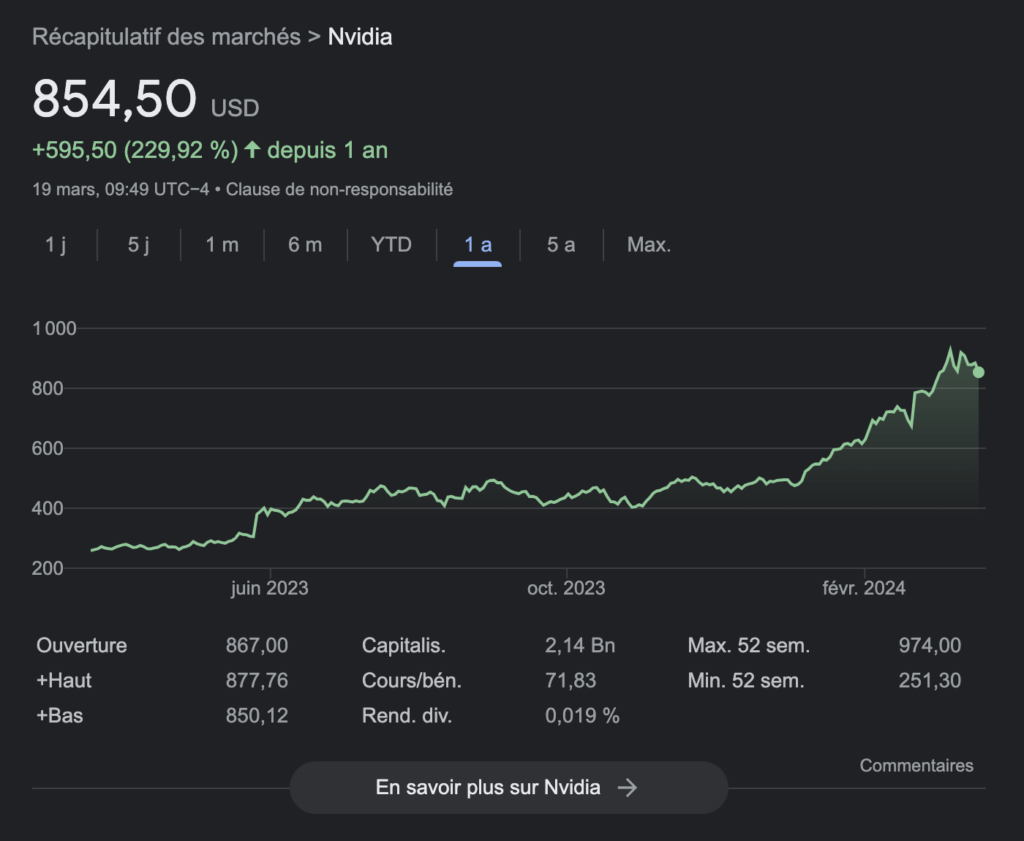

Le 18 mars, à l’occasion de sa grande conférence GTC, Nvidia a levé la voile sur une nouvelle génération de GPU que les créateurs d’intelligence artificielle générative s’empresseront sans doute de commander par milliers. Déjà en position de force sur ce secteur (ses cartes graphiques font tourner la plupart des services du marché, ce qui a fait tripler sa valeur financière en un an), Nvidia creuse l’écart avec la concurrence avec de nouveaux composants pensés pour l’IA. Le Blackwell B200 n’est pas seulement plus puissant, il est aussi annoncé comme bien moins énergivore.

Utiliser beaucoup moins d’énergie : l’exploit de Blackwell

Aujourd’hui, Nvidia doit une partie de son succès aux puces H100, que s’arrachent les entreprises comme OpenAI, Midjourney, Google ou Adobe. Ces cartes graphiques sont très bien adaptées à l’IA, ce qui a permis à Nvidia de voir ses ventes exploser en seulement quelques mois.

Avec un GPU H100 sous l’architecture Hopper (celle qui précède Blackwell), un grand modèle de langage (LLM, pour large language model) avec 1 800 milliards de paramètres a besoin de 8 000 puces pour s’entraîner, avec 15 mégawatts d’alimentation. Avec sa nouvelle architecture Blackwell, Nvidia promet une division par quatre du nombre de puces nécessaires (2 000 suffiraient donc). L’entreprise annonce aussi une consommation énergétique de 4 mégawatts, pour une puissance de calcul équivalente. De quoi faciliter le fonctionnement des LLM sur des installations plus modestes.

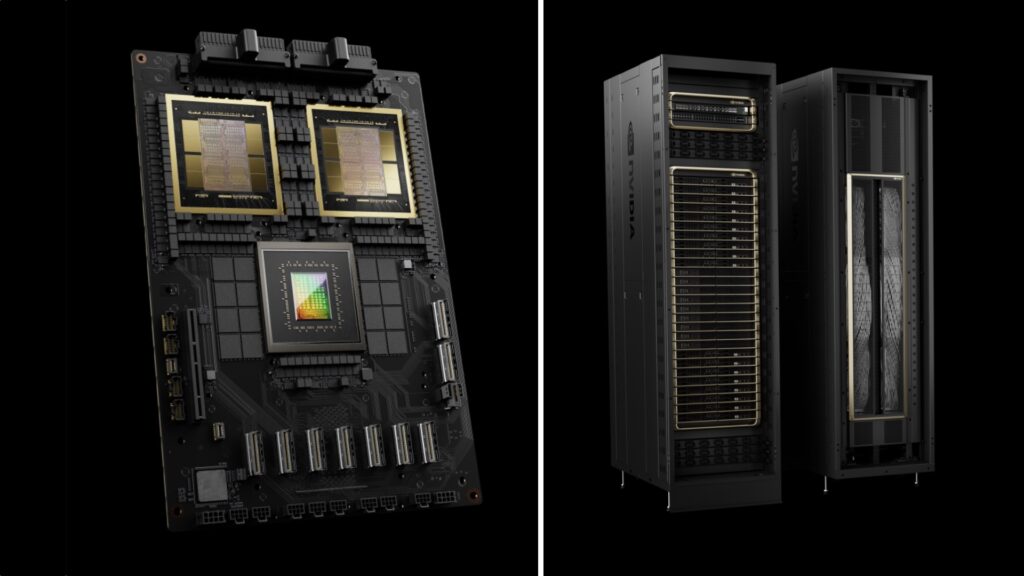

Pour séduire les entreprises, Nvidia a aussi développé une super-puce appelée GB200. Il s’agit d’une combinaison de deux GPU Blackwell et d’un CPU Grace, que les poids lourds du secteur de l’IA générative achèteront sans doute en grand nombre. Le serveur GB200 NVL72, aussi proposé par Nvidia, intègre 36 CPU et 72 GPU d’un seul coup, pour un total de 80 pétaflops. Certains racks peuvent monter jusqu’à 576 GPU, pour une puissance globale de 11,5 exaflops. Des clients comme Amazon, Google, Microsoft et Oracle ont déjà manifesté leur intérêt.

Nvidia, le roi de l’IA malgré lui

Très populaire depuis plusieurs années, notamment dans le secteur du jeu vidéo, Nvidia est devenu malgré lui la star de l’IA, sans s’être publiquement intéressé à ce domaine avant l’émergence de ChatGPT et de ses rivaux. La nouvelle architecture Blackwell va permettre à Nvidia de continuer à croître, alors que la concurrence peine à s’aligner pour l’instant. Certains misent sur des approches locales avec moins de puissance, mais les puces de Nvidia deviennent indispensables dès que le traitement est trop lourd.

Avec 208 milliards de transistors et un moteur de transformation de deuxième génération capable d’utiliser 4 bits par neurone (au lieu de 8), la B200 consolide la position de Nvidia. L’entreprise prédit que Blackwell sera le lancement le plus fort de son histoire, avec de premières livraisons d’ici à la fin de l’année.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !