Cet article est extrait de la newsletter #Règle30, qui est envoyée tous les mercredis à 11h.

Pour s’inscrire gratuitement pour la recevoir, c’est par ici.

En 2015, Google dévoilait Photos, une nouvelle application capable non seulement de stocker les clichés de ses utilisateurs et utilisatrices, mais aussi de les trier en fonction de différents éléments : le lieu, les visages des personnes présentes, leurs actions. En une pression du doigt, on pouvait retrouver les photos de notre fête d’anniversaire, de notre voyage au Japon, de notre chat ou de notre meilleur·e ami·e. Cela paraît un peu banal aujourd’hui, mais c’était très impressionnant pour l’époque. Sauf que quelques mois après la sortie du logiciel, un développeur américain a fait une très mauvaise découverte. Jacky Alciné, un homme noir, souhaitait consulter des photos de lui et son amie. Il a réalisé que Google Photos les avait identifiés comme des gorilles.

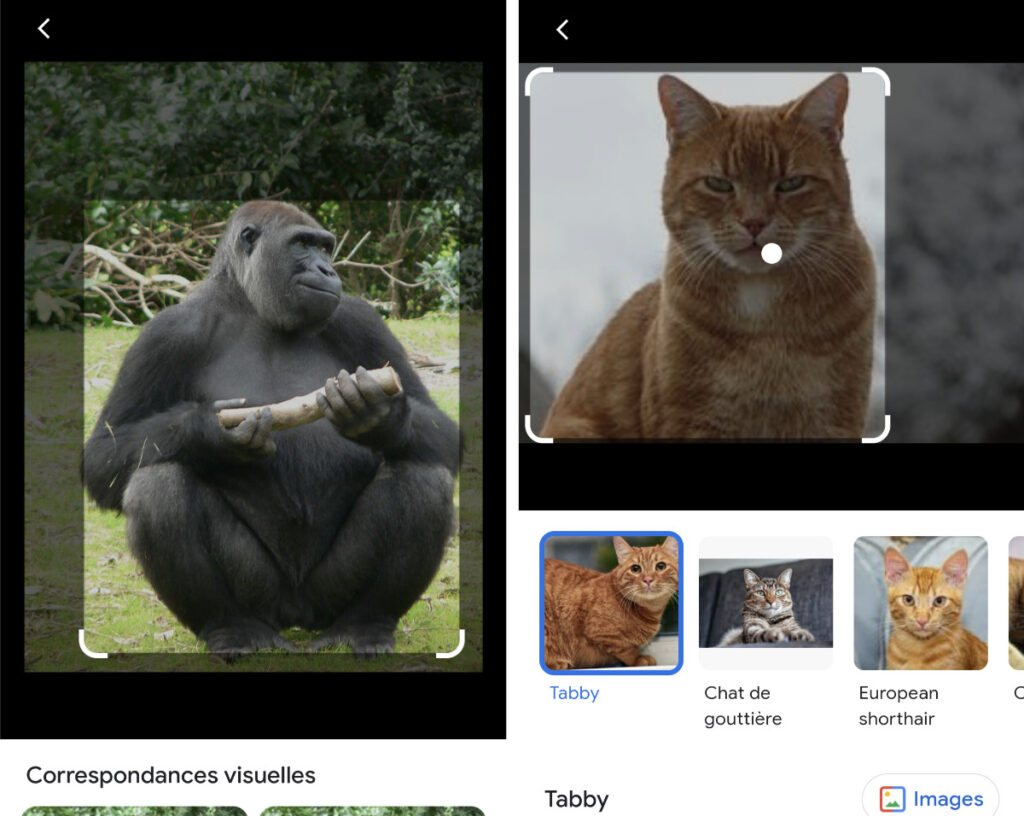

Cette histoire est devenue l’un des premiers exemples médiatisés des biais des algorithmes, un sujet alors encore mal connu du grand public. Google s’est évidemment excusé. Il a suspendu la catégorie « gorilles » dans l’application, puis a promis de vite régler le problème, notamment en diversifiant les bases de données utilisées pour entraîner ses logiciels. Huit ans après l’affaire, le New York Times a souhaité vérifier cette promesse. Le verdict est étonnant : Google Photos refuse toujours d’identifier des gorilles, ou même d’autres types de primates, comme des babouins, des chimpanzés ou des singes. Le problème est le même sur Google Lens, un outil plus récent qui permet de faire des recherches sur internet grâce à des photos, plutôt que des requêtes écrites. Le logiciel est tout à fait capable d’identifier un chat ou un chien. En revanche, face à une image de gorille, il reste étrangement muet.

Parler d’erreurs et non d’hallucinations

Cette enquête est intéressante à plusieurs titres. Déjà, parce que le problème ne concerne visiblement pas que Google. Le New York Times a aussi découvert que l’application de photos d’Apple évitait les images de gorilles et d’autres primates. Ensuite, on peut noter la manière dont Google justifie son choix. Selon l’entreprise, il est préférable d’empêcher son logiciel de reconnaître les primates, car les avantages de cette option « sont moins grands que les risques d’abus ».

Autrement dit, si on ne peut pas garantir qu’une IA traitera les personnes noires comme les blanches, on préfère entraver ses capacités. En un sens, c’est logique : il est plus important d’éviter à des personnes racisées d’être confrontées à des stéréotypes racistes douloureux que de permettre aux internautes de trier des photos de singes sur leur smartphone. Parfois, l’approche la plus éthique de l’IA est de ne pas utiliser d’IA du tout. « Il suffit d’une erreur pour provoquer une avalanche de problèmes sociétaux », explique Margaret Mitchell, chercheuse spécialisée en intelligence artificielle et ancienne employée de Google.

Mais cette stratégie d’évitement agit aussi dans l’intérêt de l’industrie du numérique et de sa réputation. Si on ignore le problème, alors il n’y a plus d’erreurs possibles. Sauf qu’une intelligence artificielle n’est pas raciste. En revanche, elle est le miroir du racisme des gens qui l’ont créée, de la société dans laquelle elle a été développée, des priorités programmées dans l’exécution de ses tâches. Certain·es expert·es rejettent d’ailleurs le terme de « biais », soit parce qu’il est trop proche des biais cognitifs de notre cerveau (les machines ne sont pas des humains), soit parce qu’il sous-entend qu’on peut construire des logiciels sans biais (si vous voulez explorer ce sujet passionnant, mais complexe, je vous recommande la lecture de cet article de NextInpact).

On pourrait enfin comparer les vieilles errances de Google sur les gorilles avec nos fantasmes actuels sur les supposées « hallucinations » des intelligences artificielles génératives, un autre terme très critiqué. « Pourquoi ne pas plutôt parler de bugs ?» s’interrogeait récemment l’essayiste Naomi Klein pour le Guardian. « Parce qu’en empruntant un terme de psychologie, les partisans des IA, tout en reconnaissant que leurs machines sont faillibles, nourrissent la mythologie préférée du secteur des nouvelles technologies : ils auraient donné naissance à une nouvelle forme d’intelligence prête à révolutionner notre espèce (…) Ce ne sont pas les robots qui hallucinent, ce sont les PDG de ces entreprises. » Dire que nos IA sont malades ou racistes, c’est faire croire qu’il s’agit d’une fatalité. Et admettre qu’elles font des erreurs, c’est accepter notre responsabilité de les corriger.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !