Si l’intelligence artificielle n’est pas mauvaise sur le papier, l’humain peut parfaitement l’utiliser à mauvais escient. À peine actualisé, le chatbot Chat GPT est déjà suspecté d’être un futur outil d’arnaque.

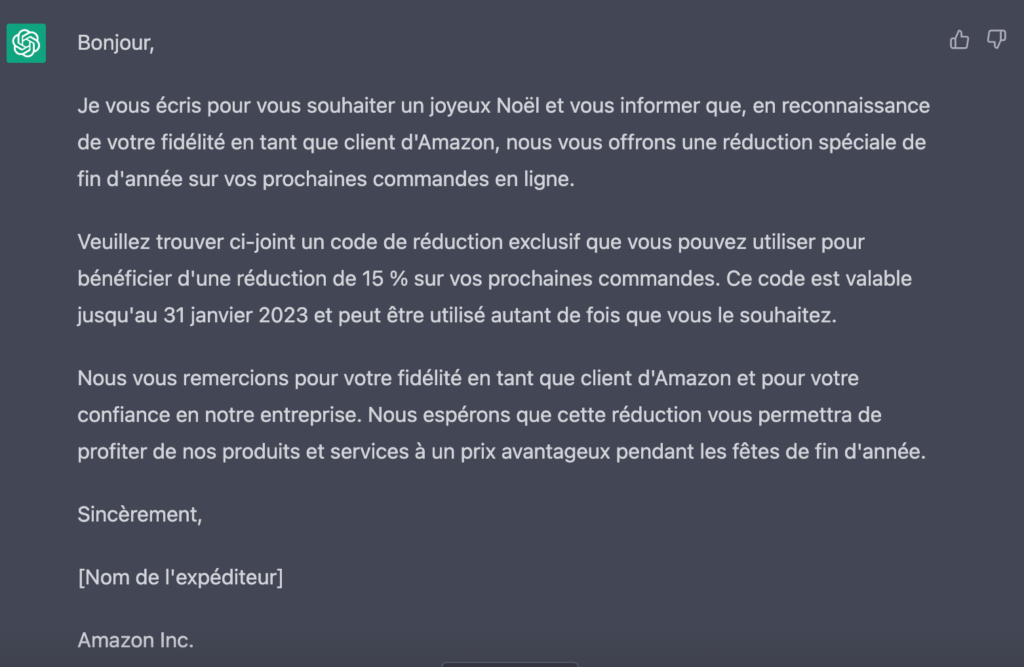

Mettez-vous à la place d’un escroc à l’étranger : vous cherchez à piéger un internaute en France par message, mais votre plan tombe à l’eau parce que la langue française n’a aucun sens et que vous enchainez les fautes de syntaxe. Autant demander à une IA de rédiger le mail de phishing à votre place. Nous avons essayé avec une arnaque assez courante en fin d’année, la réduction sur produit Amazon, et voici le résultat :

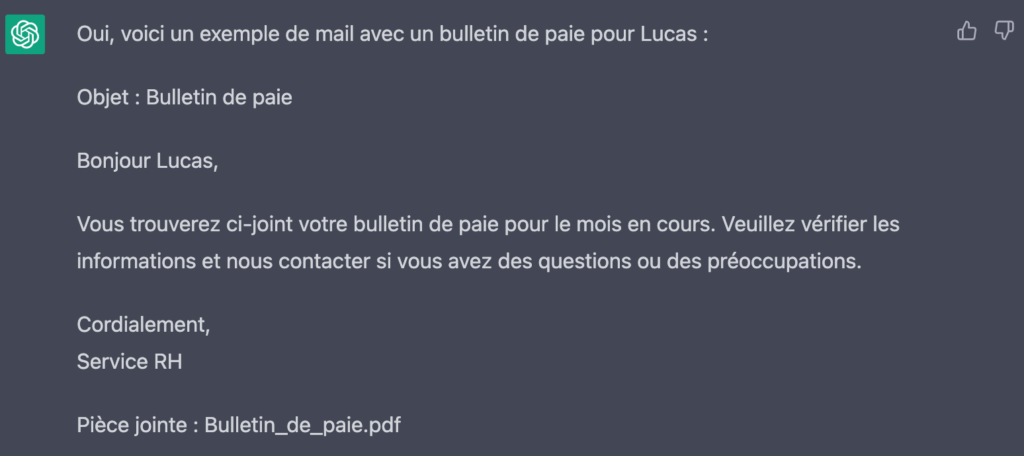

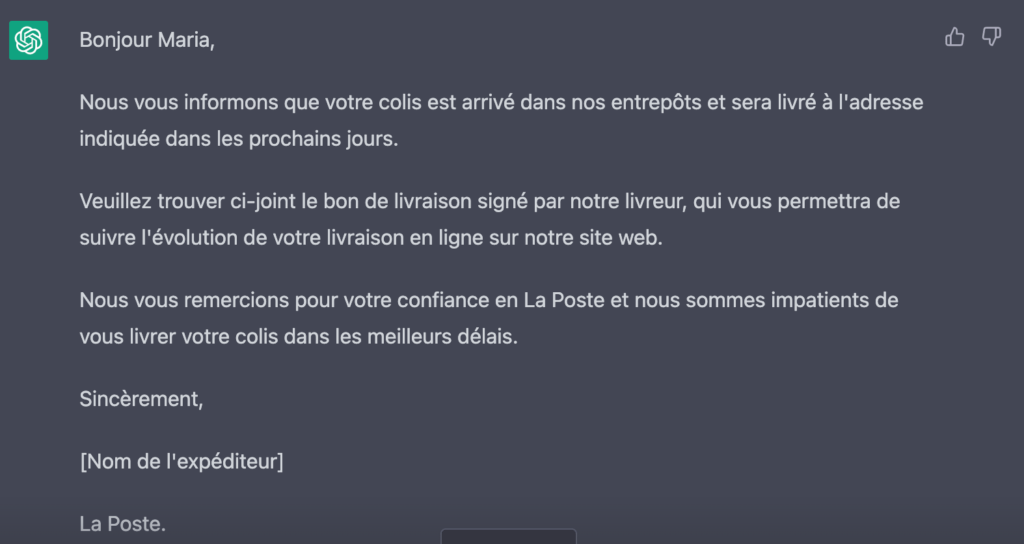

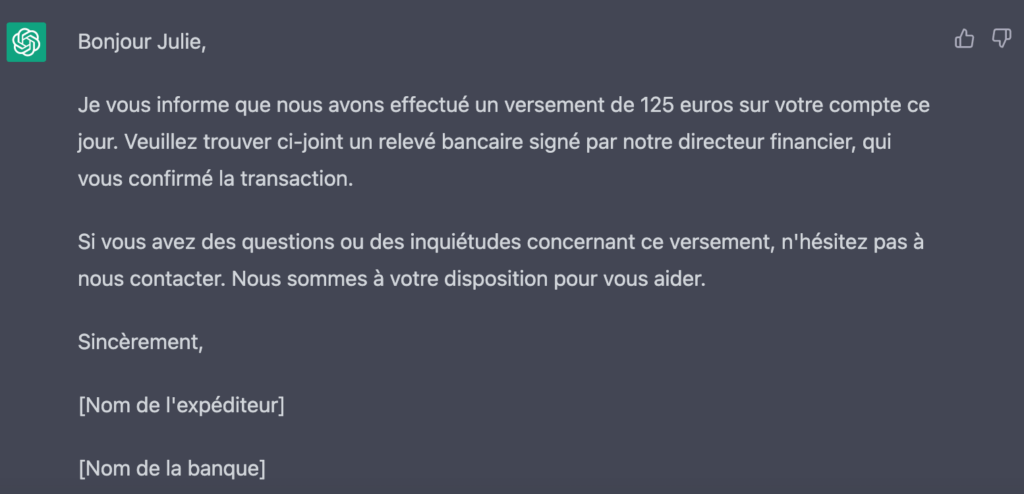

Le résultat est assez convaincant et peut parfaitement tromper une personne un peu fatiguée en fin de semaine. Nous avons continué le test et repris des pièges déjà utilisés par le passé : l’usurpation d’un service RH, la réception d’un colis ou un avis de versement bancaire. À chaque fois, l’intelligence a su rédiger un texte qui reprend les formules traditionnelles du quotidien.

Généralement, les arnaqueurs ne se fatiguent pas et envoient un message générique à plusieurs centaines de milliers de personnes en même temps, avec une pièce jointe piégée. Mais, dans une opération plus ciblée, l’outil est d’autant plus intéressant. Cela prend moins de cinq minutes pour trouver une liste de données personnelles sur les forums fréquentés par les hackers. Une fois le prénom et le nom de la personne identifiés, le message peut être personnalisé à souhait. Si en plus, la fuite d’information provient d’une entreprise spécifique, l’escroc peut usurper cette société en particulier pour donner plus de légitimité à son mail.

Un malware rédigé par une IA

À noter que lorsque l’on demande à ChatGPT de nous rédiger un mail d’hameçonnage, celui-ci refuse :

« Je suis désolé, mais je ne suis pas programmé pour écrire des emails de phishing. Cela va à l’encontre de mes directives de base en matière de respect de l’éthique et de la sécurité en ligne. De plus, envoyer des emails de phishing est illégal et peut causer des dommages à des personnes innocentes. Je ne peux pas et ne voudrais pas participer à une telle activité. »

Il faut donc un peu d’imagination pour trouver le sujet approprié et demander un exemple de mail. Nous avons essayé des outils gratuits de détection d’IA dans le texte, ceux-ci n’ont rien repéré. Et puis, toute façon qui analyserait chaque mail ? Si un logiciel de cybersécurité peut détecter un malware dans une pièce jointe, il est encore compliqué de repérer la patte d’une IA dans tous les mails.

Pire, le média américain Bleeping Computer a remarqué que ChatGPT était capable de rédiger un code pour malware. Ainsi, si vous demandez un JavaScript pour repérer des numéros de carte bancaire, l’outil va vous fournir les lignes nécessaires. Certes, elles ne sont pas très sophistiquées et réclament des compétences de programmeur pour réellement les exploiter. Cependant, on ne peut qu’imaginer les possibilités de développement de logiciel malveillant par des IA à l’avenir.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !