La numérisation du patrimoine culturel est une tâche qui occupe d’année en année toujours plus d’acteurs. Si la place de Google dans ce domaine est considérable, le géant américain ayant participé à la numérisation de plus de 20 millions d’ouvrages depuis 2004, d’autres institutions se montrent très actives, à l’image de l’université d’Oxford et du Vatican.

La numérisation du patrimoine culturel est une tâche qui occupe d’année en année toujours plus d’acteurs. Si la place de Google dans ce domaine est considérable, le géant américain ayant participé à la numérisation de plus de 20 millions d’ouvrages depuis 2004, d’autres institutions se montrent très actives, à l’image de l’université d’Oxford et du Vatican.

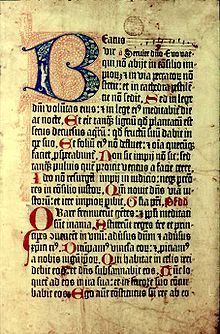

Preuve en est, la bibliothèque Bodléienne et la bibliothèque apostolique vaticane ont annoncé jeudi leur collaboration pour mener à bien un projet de numérisation portant sur 1,5 million de pages issues d’anciens textes. Les efforts des deux bibliothèques vont porter sur les incunables (les premiers livres imprimés entre 1450 et 1500), les manuscrits grecs et les textes hébraïques.

Selon le communiqué, le choix de ces trois domaines s’est fait en fonction de leur importance au sein des deux bibliothèques. Deux tiers des ressources seront fournies par le Vatican et le tiers restant sera apporté par l’université d’Oxford. Le projet a été financé par la fondation Polonsky, qui a apporté une enveloppe de 2 millions de dollars (environ 1,5 million d’euros).

« L’effort de numérisation bénéficiera également aux chercheurs, en unissant des contenus qui ont été dispersés au fil des siècles« , explique la faculté. « Transformer ces vieux textes et ces vieilles images sous forme numérique permet de transcender les contraintes spatiales et temporelles qui, dans le passé, ont restreint l’accès à la connaissance« , souligne Sarah Thomas, d’Oxford.

Ces textes seront mis en ligne gratuitement sur Internet.

( photo : Mainz psalter, domaine public Bodleian Library, Oxford )

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !