Ce n’est pas encore GPT-5, mais c’est une itération bienvenue de l’existant. Vendredi 12 avril, OpenAI a annoncé une mise à jour de ChatGPT, son célèbre chatbot, pour sa clientèle payante (ChatGPT Plus, Team, Entreprise et via l’API). Cette actualisation concerne le mode GPT-4 Turbo, qui a été lancé pour la première fois en novembre 2023.

Une nouvelle version de GPT-4 Turbo que Sam Altman, le patron d’OpenAI, a salué : « GPT-4 est désormais beaucoup plus intelligent et agréable à utiliser. » Cette réaction ne dit toutefois pas grand-chose des changements apportés. N’importe quelle itération d’un chatbot est généralement décrite par ses promoteurs comme « plus intelligente ».

Il faut se tourner vers un fil Twitter d’OpenAI pour découvrir des indications un peu plus précises. L’entreprise américaine explique avoir « amélioré les capacités d’écriture, de calcul, de raisonnement logique et de codage » de son agent conversationnel, notamment depuis sa dernière mise à jour, datée du 25 janvier 2024 — toujours pour GPT-4 Turbo.

Les nouveautés dans GPT-4 Turbo

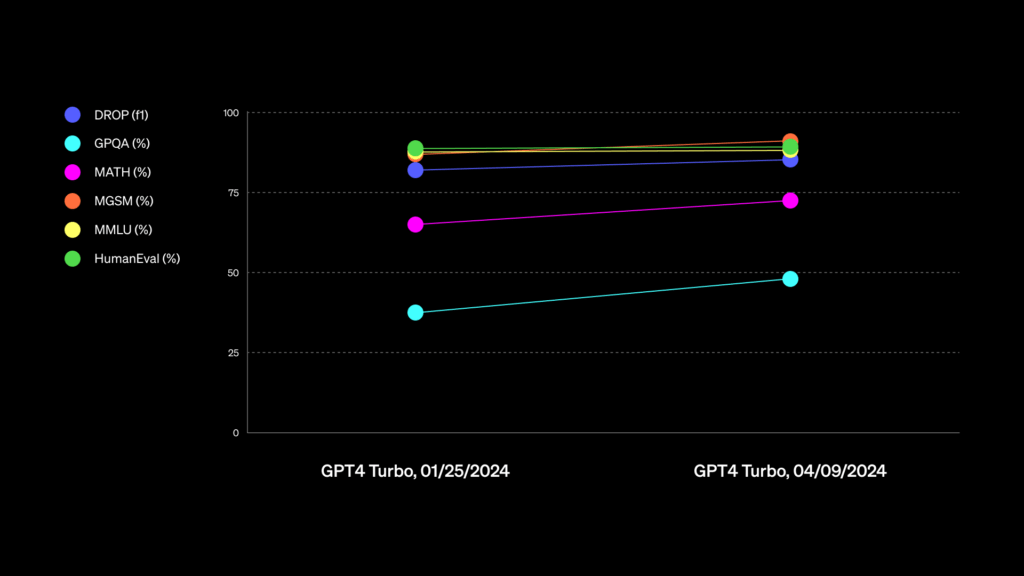

L’entreprise a dévoilé un tableau retranscrivant l’évolution de GPT-4 Turbo sur cinq bancs d’essai (Drop, GPQA, Math, MGSM, MMLU, HumanEval). MMLU et HumanEval apparaissent très stables, tandis qu’un progrès est visible pour tous les autres. OpenAI n’a pas précisé l’unité des chiffres renseignés en ordonnée.

Ces benchmarks ne parleront pas au commun des mortels.

MMLU, par exemple, est un test qui mesure l’étendue des connaissances et la capacité de résolution de problèmes acquises par les grands modèles de langage durant la formation préalable, rappelle Google. Il couvre 57 tâches, dont les mathématiques élémentaires, l’histoire des États-Unis, l’informatique, le droit, etc, ajoute HuggingFace.

Math évalue la capacité d’un modèle à résoudre des problèmes complexes en maths, nécessitant un raisonnement, une résolution de problèmes en plusieurs étapes et la compréhension de concepts. HumanEval sert à mesurer les facultés du côté du code (réussite d’un test unitaire fonctionnel pour de la programmation).

De nombreux benchmarks existent sur le marché de l’IA générative, en plus de ceux déjà mentionnés précédemment. Naturellement, les entreprises du secteur peuvent être amenées à plutôt mettre en avant les tests qui vantent les progrès de leur intelligence artificielle — en tout cas, ce ne sont pas toujours les mêmes bancs d’essai qui sont utilisés.

Une IA qui raconte moins sa vie

Ces épreuves ne parleront pas nécessairement au grand public. Par contre, ce que les internautes pourront relever, c’est que ce tout nouveau ChatGPT va sans doute moins « raconter sa vie » durant la génération d’une réponse. L’outil est censé être désormais plus concis dans ses interventions écrites.

« Les réponses seront plus directes, moins verbeuses et utiliseront un langage plus conversationnel », promet OpenAI. Une capture d’écran partagée par la société compare deux résultats. Le premier compte neuf lignes de texte et deux émojis, le second trois lignes et un seul émoji. Il est donc moins bavard et va davantage à l’essentiel.

Lui qui était paresseux autrefois, on peut dire que c’est une mise à jour qui va dans son sens.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Tous nos articles sont aussi sur notre profil Google : suivez-nous pour ne rien manquer !