« Nous vivons une époque à la fois fantastique et dangereuse. En effet, nous sommes témoins de bouleversements majeurs, auxquels nous allons nécessairement devoir nous adapter. Notre manière d’apprendre, en particulier, va devoir changer. » En novembre dernier, au Web Summit de Lisbonne, Antoine Blondeau donnait le ton dès le début de son intervention. Dans le privé, si le phrasé est plus relâché, le discours reste le même : l’évolution, l’adaptation sont pour lui les clefs ouvrant les portes du futur. Un futur où l’intelligence humaine pourra compter sur l’aide des machines.

Car, sans tambour ni trompette, cet entrepreneur français, naviguant entre Hong Kong et la Silicon Valley, est aujourd’hui en train de créer l’une des intelligences artificielles les plus perfectionnées au monde. L’aventure démarre en 2008, date de création de sa société, Sentient Technologies. Moins connue du public que les ténors de l’intelligence artificielle que sont IBM, Google et Facebook, car plus spécialisée, l’entreprise d’Antoine Blondeau a pour but de construire une intelligence artificielle hors norme, à la fois globale, agnostique et évolutive.

De Deep Blue à AlphaGo

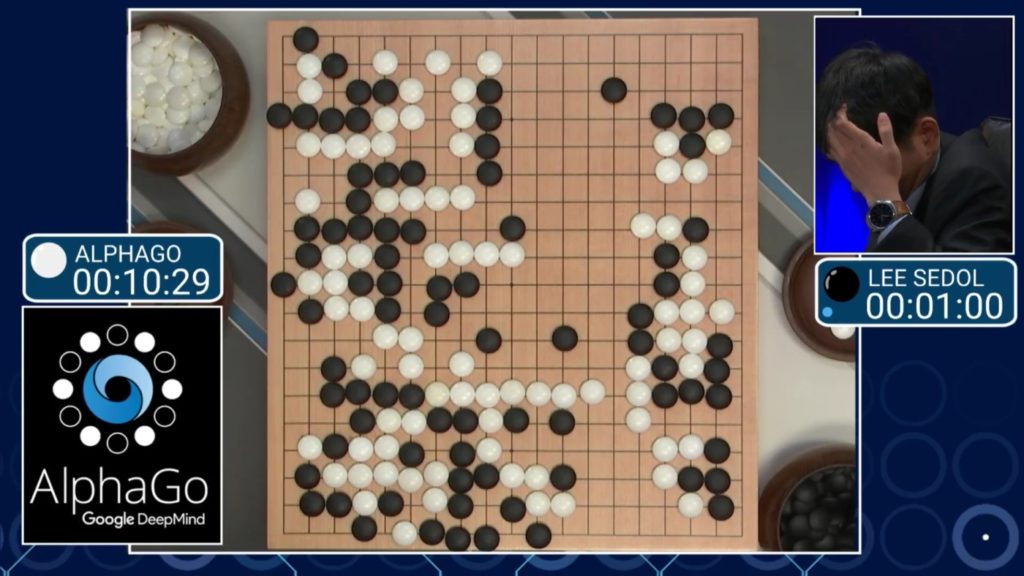

De la victoire de Deep Blue contre Gary Kasparov en 1996 à celle, peut-être plus spectaculaire encore, d’AlphaGo contre Lee Sedol en mars 2016, en passant par celle d’IBM Watson à Jeopardy!, l’intelligence artificielle a récemment accompli des progrès stupéfiants, surpassant l’intelligence humaine dans des domaines que celle-ci prenait jusqu’alors pour sa chasse gardée.

Ces réalisations demeurent l’apanage de logiciels qui doivent tout au labeur humain

Ainsi, le jeu de Go a longtemps semblé trop complexe pour la machine. Le nombre gigantesque de combinaisons possibles dans une partie rendant impuissant le seul calcul de probabilité, ce jeu chinois millénaire exige de s’adapter à chaque situation et de faire preuve d’une certaine créativité, caractéristiques que beaucoup pensaient être l’apanage de l’homme.

Cela n’a pas empêché le logiciel mis au point par Google DeepMind de battre à plate couture le meilleur joueur du monde, et de poursuivre récemment ses exploits en administrant des raclées à de nombreux joueurs professionnels sur l’internet. À l’heure où j’écris ces lignes, le logiciel demeure invaincu, avec soixante victoires d’affilée.

Néanmoins, aussi spectaculaires soient-elles, ces réalisations demeurent l’apanage de logiciels qui doivent tout au labeur humain. Chacun a nécessité l’attention de dizaines de chercheurs hautement qualifiés au cours de plusieurs années de travail. En outre, ces logiciels sont ultra spécialisés : AlphaGo est peut-être le meilleur joueur de Go de tous les temps, il demeure incapable d’aligner trois mots ou de discerner une chèvre d’un hibou, ce dont serait bien sûr capable n’importe quel joueur de Go humain débutant. C’est pourquoi de nombreux experts relativisent les récents progrès de l’intelligence artificielle et récusent toute comparaison possible avec l’intelligence humaine.

C’est le cas de l’écrivain, entrepreneur et futuriste Jerry Kaplan : « Le terme même d’intelligence artificielle est trompeur. Le fait que l’on puisse programmer une machine pour jouer aux échecs, au Go, à Jeopardy! ou pour conduire une voiture ne signifie pas pour autant qu’elle soit intelligente ! Autrefois, les calculs étaient effectués à la main, par des humains très intelligents et portant une grande attention au détail.

Aujourd’hui, n’importe quelle calculette achetée en supermarché peut faire bien mieux que ces brillants cerveaux de jadis. Ces calculatrices sont-elles pour autant intelligentes ? Je ne le crois pas. Au fil du temps, nous découvrons de nouvelles techniques permettant de résoudre des problèmes bien précis, à l’aide de l’automatisation. Cela ne signifie pas pour autant que nous soyons en train de construire une super-intelligence en passe de prendre le pouvoir à notre place. »

Contrairement à l’intelligence humaine, très polyvalente, l’intelligence artificielle serait donc vouée à l’ultraspécialisation.

Le darwinisme au secours de l’intelligence artificielle

Pourtant, les travaux de Sentient Technologies pourraient bien changer la donne. Car l’entreprise d’Antoine Blondeau ambitionne de construire un programme capable de s’attaquer à n’importe quel type de problème, et surtout, d’apprendre à le résoudre tout seul. Pour cela, elle utilise deux techniques d’intelligence artificielle différentes, le deep learning, d’une part, et les algorithmes évolutifs, d’autre part.

Explications : « Le deep learning, qui simule la façon dont un système nerveux fonctionne, est excellent pour deux choses : l’observation et l’abstraction. Il permet, à partir d’une large quantité de données non structurées, d’opérer une classification à l’intérieur de celle-ci, de tisser des relations entre ces différentes catégories, et, dans un deuxième temps, de créer des abstractions à partir de cette observation. Il est ainsi excellent pour créer une modélisation du monde, mais n’est en revanche pas optimal pour l’adaptation, la définition d’une stratégie, et la prise de décision. »

Pour cette seconde phase, Sentient Technologies a puisé son inspiration dans… les théories de Charles Darwin. « Nous utilisons des algorithmes évolutifs, qui imitent la façon dont la vie biologique a évolué sur terre. On peut voir le monde d’aujourd’hui comme une succession de stratégies gagnantes : toutes les espèces sur Terre fournissent des exemples de réussite, car elles sont parvenues à survivre. La nature a, au fil du temps, créé un grand nombre de combinaisons de codes génétiques possibles. En tâtonnant de la sorte, elle est arrivée petit à petit à générer des codes génétiques qui fonctionnent, survivent et parviennent à dominer leur environnement. »

L’évolution résumée en quelques minutes

Une stratégie qu’Antoine Blondeau s’efforce de reproduire sur le plan informatique. « Cette évolution est parfaitement applicable à un logiciel, sauf qu’au lieu de prendre des milliards d’années, elle prend alors quelques minutes, semaines ou mois en fonction de la taille du problème à résoudre. On peut ainsi créer de manière rapide et approfondie une population de stratégies gagnantes. » Hormis le fait que les êtres ainsi générés sont des intelligences artificielles, et non des êtres vivants, le processus est le même.

Parmi une première génération d’intelligence artificielle, Sentient Technologies sélectionne les plus performantes. Elle utilise ensuite leur ADN pour concevoir une seconde génération mieux adaptée. Au sein de cette génération, les meilleures sont de nouveau sélectionnées pour obtenir une troisième génération encore meilleure, etc. Répétée sur de nombreuses générations, cette technique permet l’émergence d’une intelligence artificielle darwinienne, toujours plus performante et capable de s’adapter à son environnement.

Il est possible de construire des logiciels capables de s’attaquer à n’importe quel type de problème

Avec ce système, il est possible de construire des logiciels capables de s’attaquer à n’importe quel type de problème, sans déployer des ressources humaines considérables. « Pour construire AlphaGo, Google a employé entre dix et vingt docteurs (PhD) pendant trois ans. Notre idée consiste à remplacer la conception humaine par un système intelligent et évolutif qui travaille tout seul sur des milliers de cartes graphiques et de processeurs. » explique Antoine Blondeau.

Cette dimension agnostique et évolutive est vue par beaucoup comme la nouvelle étape de l’intelligence artificielle. « Les programmes de demain seront capables d’interagir en permanence avec leur environnement et de s’améliorer sans cesse grâce à l’expérience. » écrit ainsi Sergey Levine, chercheur en informatique à l’Université de Berkeley. Sentient Technologies n’est d’ailleurs pas la seule entreprise à suivre ce chemin.

Ainsi, Google DeepMind, à qui l’on doit le logiciel AlphaGo, multiplie depuis peu les domaines d’application de son logiciel. L’entreprise a noué un partenariat avec Blizzard afin d’entraîner son intelligence artificielle sur le jeu Starcraft II. Elle a également rendu public le code de son programme sur GitHub, afin d’inciter les chercheurs de tous horizons à l’utiliser et le personnaliser pour résoudre différents types de problèmes.

OpenAi, autre projet financé par Elon Musk et Peter Thiel, a de son côté rendu publique une interface baptisée Universe, qui consiste en une intelligence artificielle capable d’analyser le contenu d’un écran et de manipuler un clavier et une souris. L’objectif : obtenir un système capable d’apprendre à jouer à n’importe quel jeu vidéo. Au-delà des différentes applications, on retrouve cette même volonté de construire un logiciel autodidacte, pouvant s’adapter à n’importe quelle situation. Ainsi, Google applique d’ores et déjà ses compétences acquises en matière d’intelligence artificielle via Google DeepMind à la recherche sur les maladies oculaires liées au diabète, via sa filiale Verily.

Sentient Technologies a de son côté commencé par employer son logiciel dans les domaines de la finance et du commerce en ligne. Aujourd’hui, les seules limites semblent celles de l’imagination. Dans la santé, l’entreprise a mis au point une technique capable de prédire l’apparition d’une septicémie une demi-heure avant qu’elle ne se manifeste aux yeux des médecins.

Une fois approuvée par les autorités médicales, cette méthode permettrait d’accroître considérablement les chances de survie du patient. Elle propose également des services de maintenance prédictive dans l’industrie et l’électroménager, détectant les défaillances en amont. Elle travaille même avec le MIT sur un système permettant de prévoir les chocs sismiques trente minutes avant qu’ils ne se produisent.

En matière de cybersécurité, ce sont les fraudes et cyberattaques qui peuvent être prévues. Citons encore l’agriculture, où les possibilités sont également nombreuses : « Nous avons développé un système de conteneurs intelligents, en partenariat avec le MIT Media Lab. » explique-t-il. « À l’intérieur, l’intelligence artificielle contrôle la lumière, l’humidité, la température, mais aussi les nutriments apportés aux plantes, supervisant leur croissance en temps réel. Cela permet d’améliorer l’efficacité sans avoir recours aux OGM. »

De la place de l’homme

Si l’intelligence artificielle devient à la fois meilleure que l’intelligence humaine pour résoudre des problèmes précis et capable de s’adapter à n’importe quel type de situation, quelle place restera-t-il pour l’humain ? Pas de panique : pour Antoine Blondeau, l’humain n’est pas près de s’effacer au profit de la machine.

Quelle place restera-t-il pour l’humain ?

« Notre cerveau consomme environ 20 watts. Comparé à la puissance énergétique dont un ordinateur de puissance équivalente aurait besoin, c’est très faible. Le cerveau humain a encore de beaux jours devant lui, car il est très efficace, et va le rester. En revanche, l’intelligence artificielle sera de plus en plus utilisée pour les problèmes où la dimensionnalité des données est très importante (plus l’on en a, mieux c’est), d’une part, et où la rapidité d’apprentissage est capitale, d’autre part. Car l’humain est limité à la fois dans sa mémoire et dans sa capacité d’apprentissage, contrairement à la machine.

À terme, peut-être que les machines deviendront plus intelligentes que l’homme, mais cela va prendre beaucoup de temps, et cela sera surtout un processus progressif : on ne va pas se réveiller un matin en réalisant que les machines sont devenues conscientes.

Il ne faut pas non plus perdre de vue l’objectif que nous cherchons à atteindre avec l’intelligence artificielle : elle doit servir à résoudre nos grands problèmes sociétaux, à construire un monde plus juste, plus humaniste, où les gens seront plus heureux. Pour y parvenir, il faut que cette technologie soit disponible pour tout le monde, ne demeure pas l’apanage de quelques personnes. »

Elon Musk ne pourra qu’approuver.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Toute l'actu tech en un clin d'œil

Ajoutez Numerama à votre écran d'accueil et restez connectés au futur !

Pour ne rien manquer de l’actualité, suivez Numerama sur Google !